配置騰訊雲知識引擎原子能力

騰訊雲知識引擎(LKE)是騰訊雲推出的企業級 AI 服務平臺,提供 DeepSeek-V3 系列模型的 API 接入服務。支援超大規模引數(685B)、混合推理、稀疏注意力等先進技術,適用於複雜推理、程式碼生成、長文字處理等場景。

1. 開通知識引擎服務並獲取 API Key

1.1 訪問知識引擎控制檯

訪問騰訊雲知識引擎原子能力控制檯並登入:https://console.cloud.tencent.com/lke

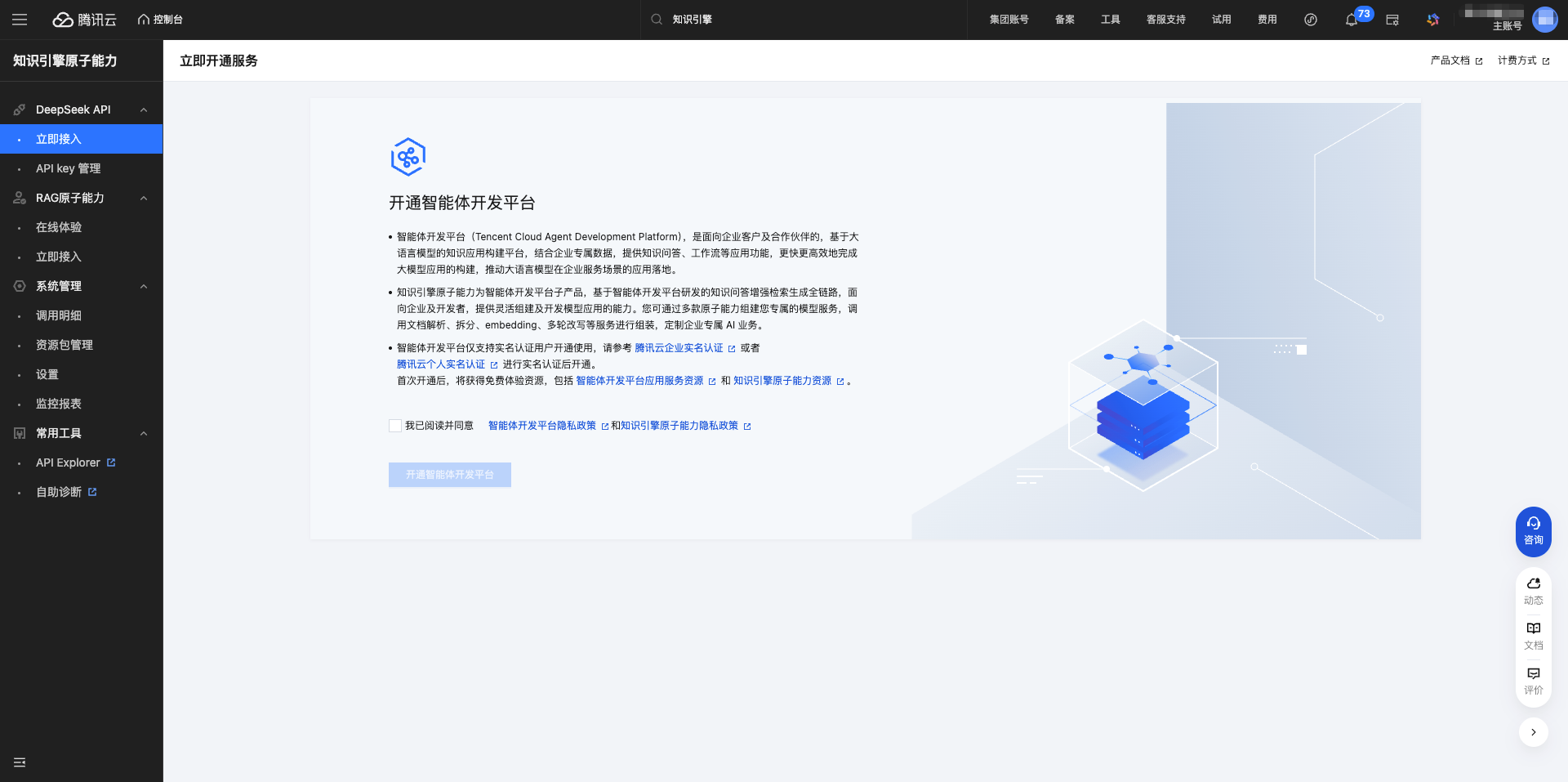

1.2 開通智慧體開發平臺

登入後,點選左側選單的 DeepSeek API → 立即接入,進入服務開通頁面。

點選 開通智慧體開發平臺 按鈕。

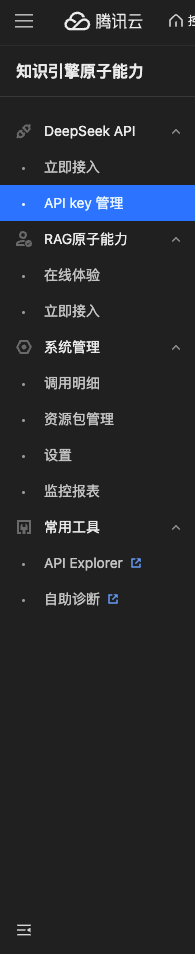

1.3 進入 API KEY 管理

服務開通後,點選左側選單的 API KEY 管理。

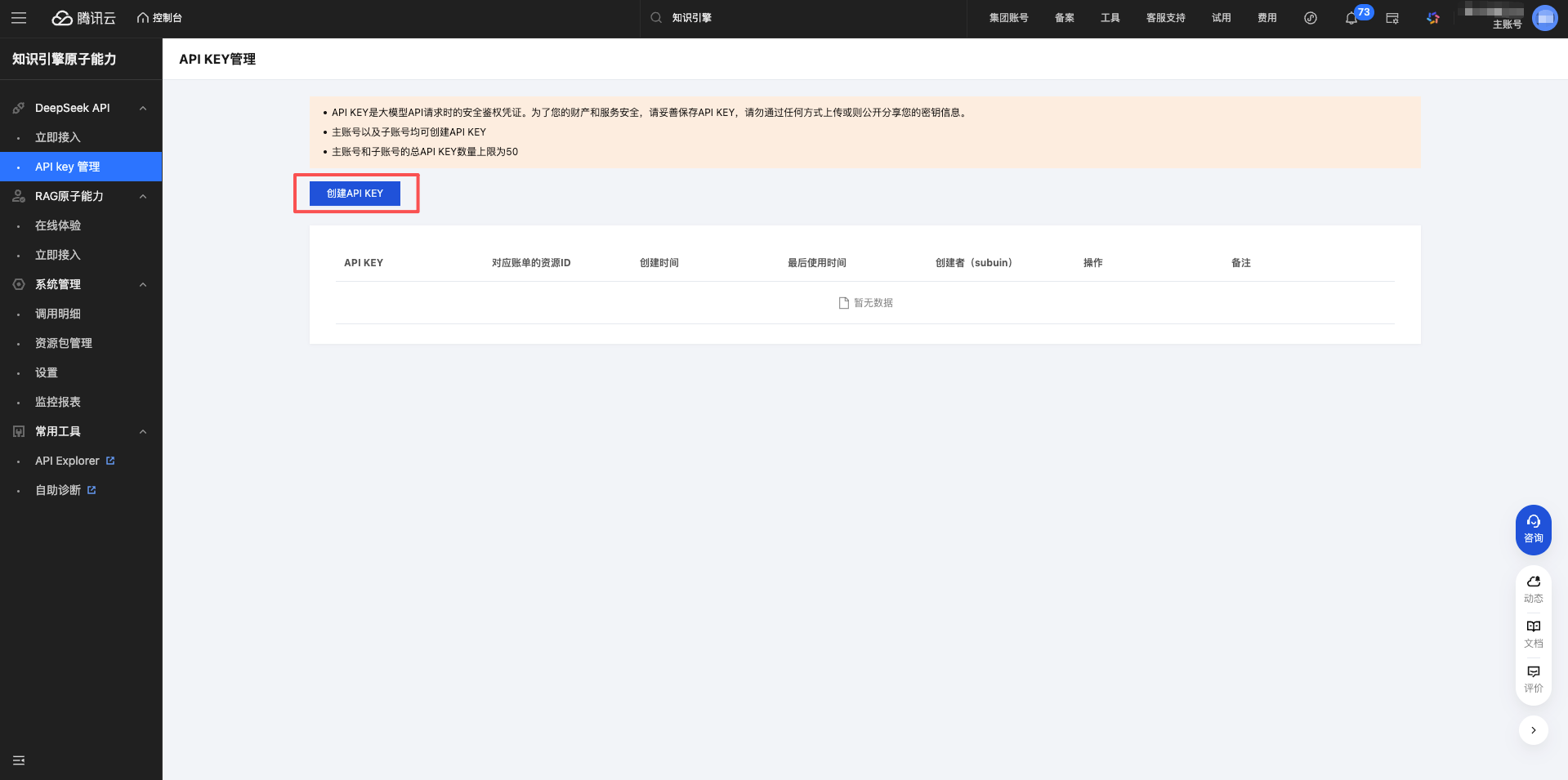

1.4 建立 API Key

點選 建立 API KEY 按鈕。

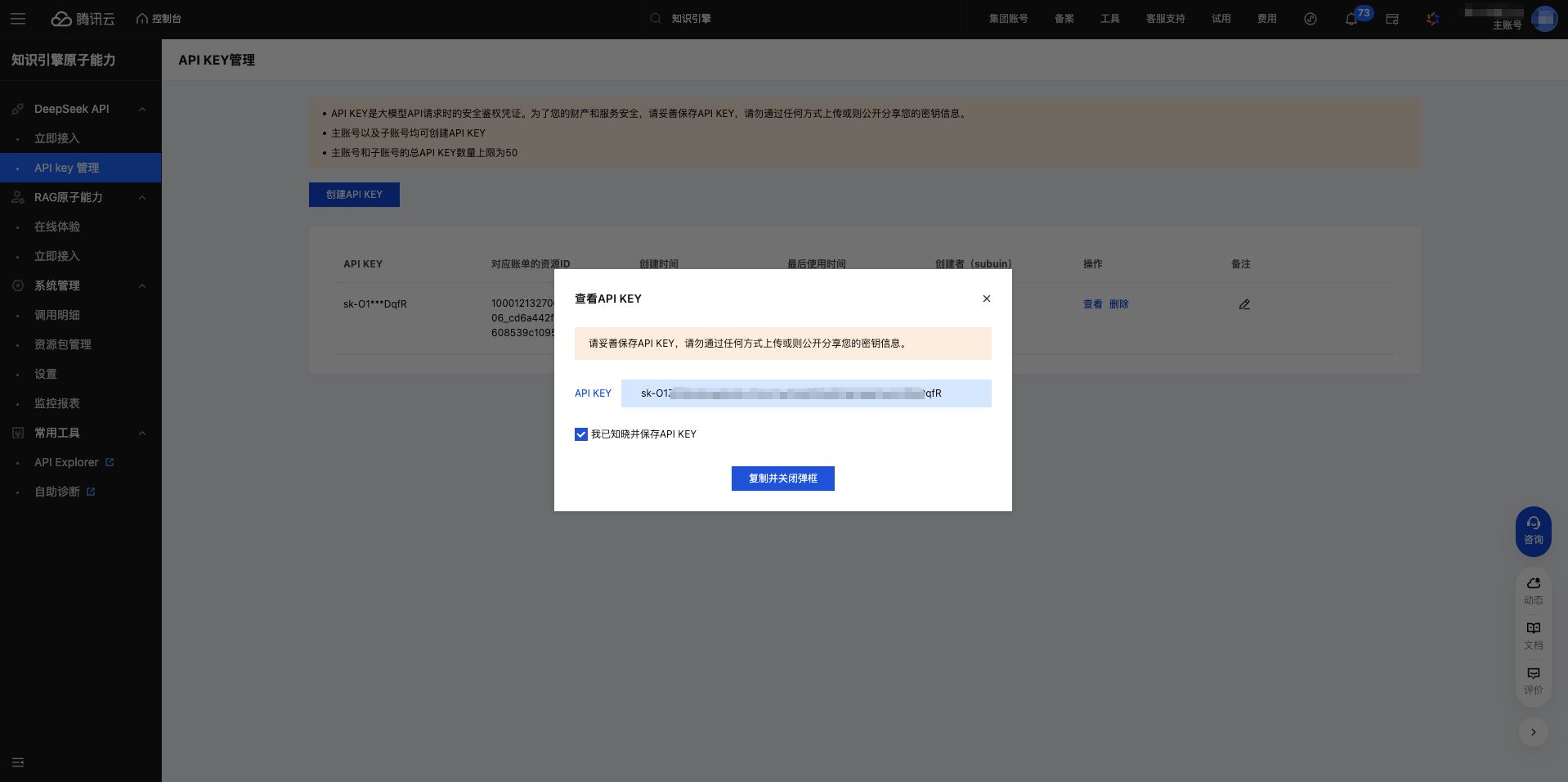

1.5 複製 API Key

建立成功後,系統會顯示 API Key。

重要:請立即複製並妥善儲存,API Key 以 sk- 開頭。

點選複製按鈕,API Key 已複製到剪貼簿。

2. 在 CueMate 中配置騰訊雲知識引擎模型

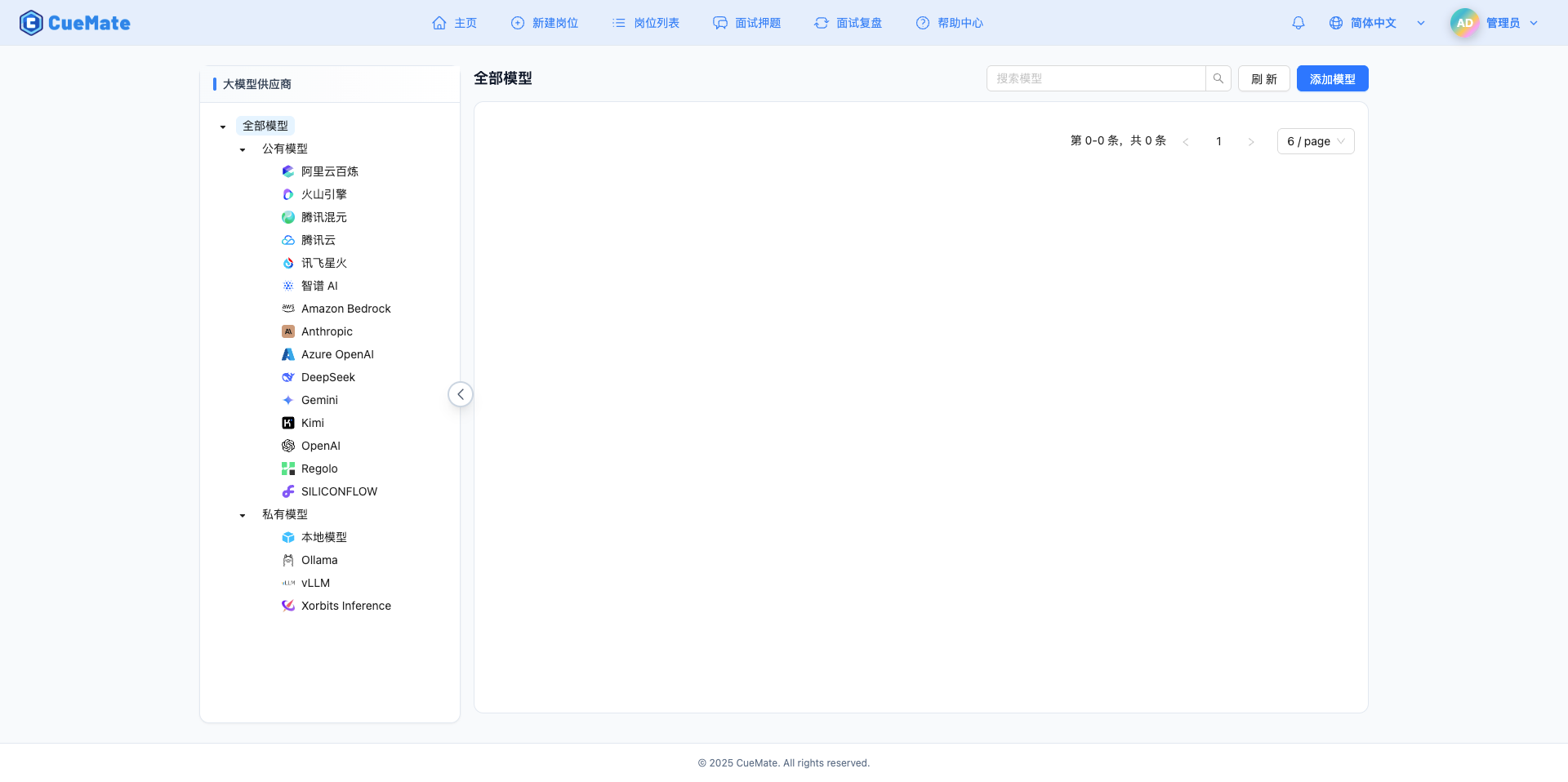

2.1 進入模型設定頁面

登入 CueMate 系統後,點選右上角下拉選單的 模型設定。

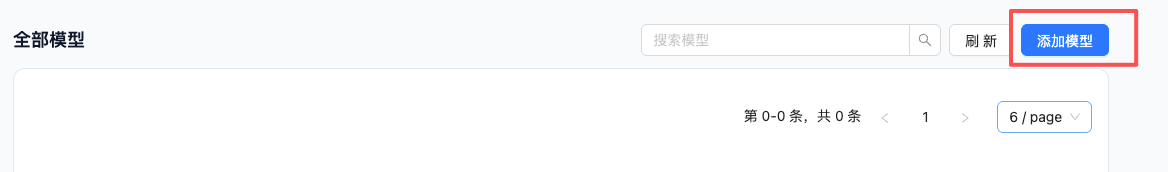

2.2 新增新模型

點選右上角的 新增模型 按鈕。

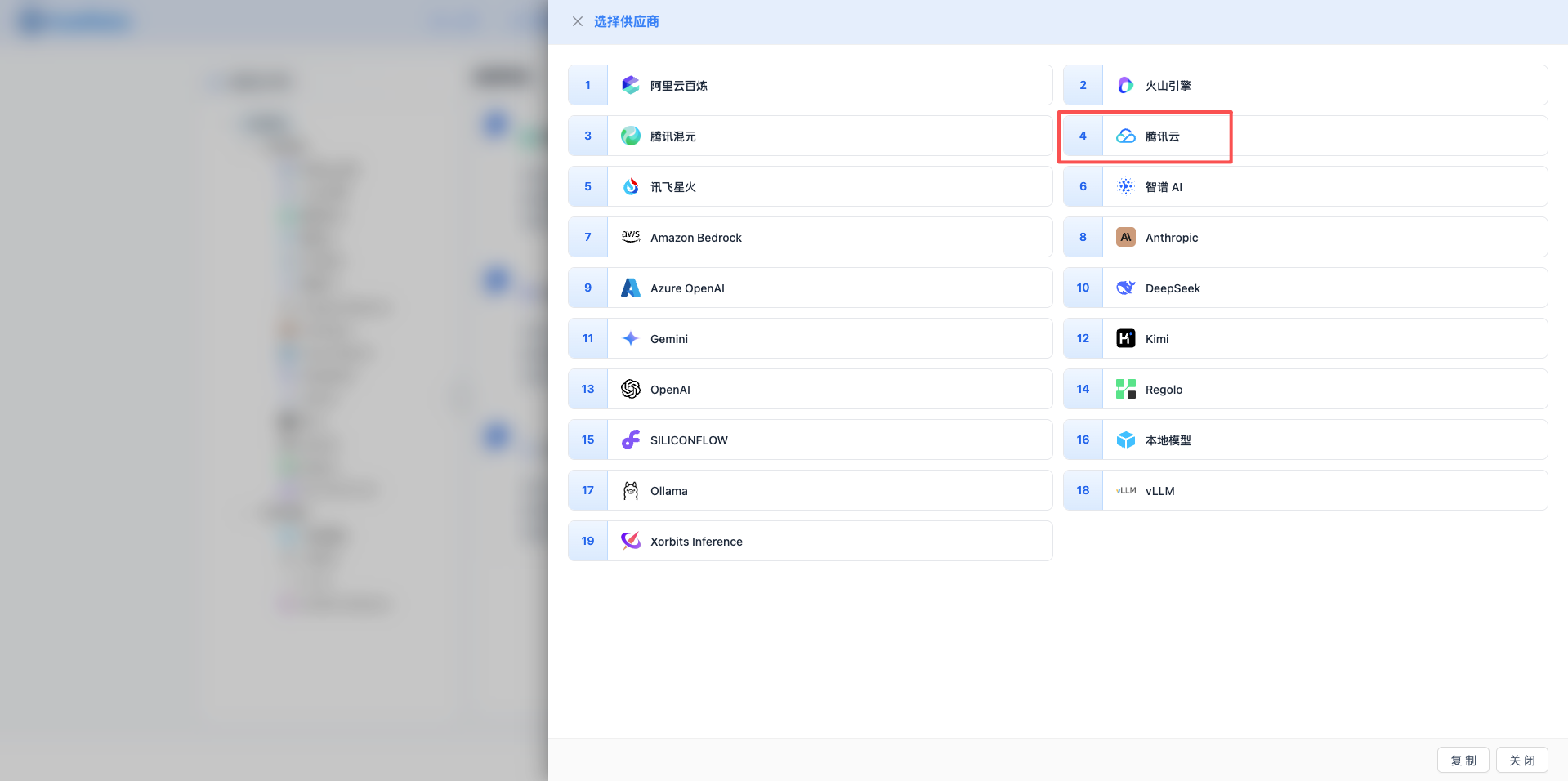

2.3 選擇騰訊雲知識引擎服務商

在彈出的對話方塊中:

- 服務商型別:選擇 騰訊雲知識引擎

- 點選後 自動進入下一步

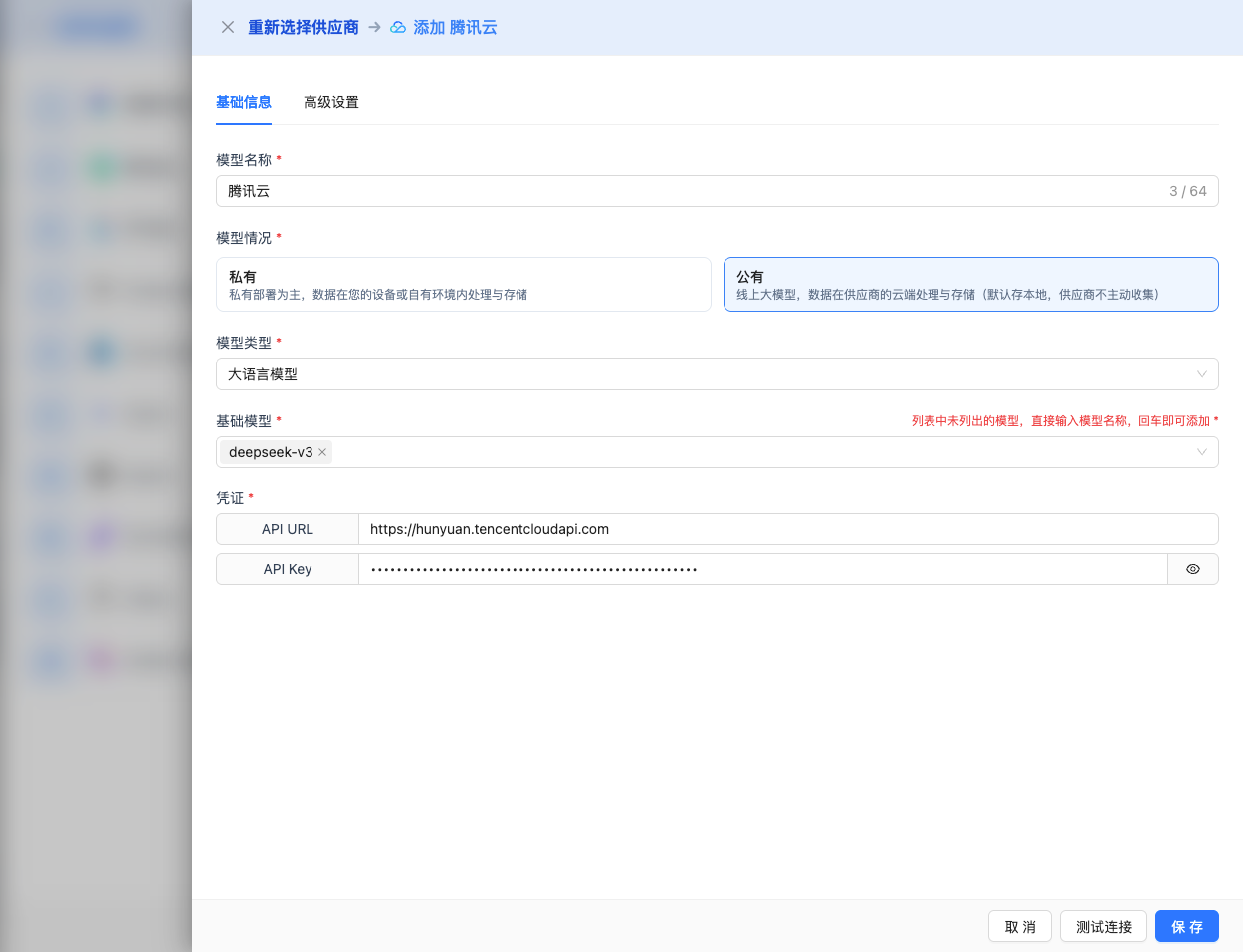

2.4 填寫配置資訊

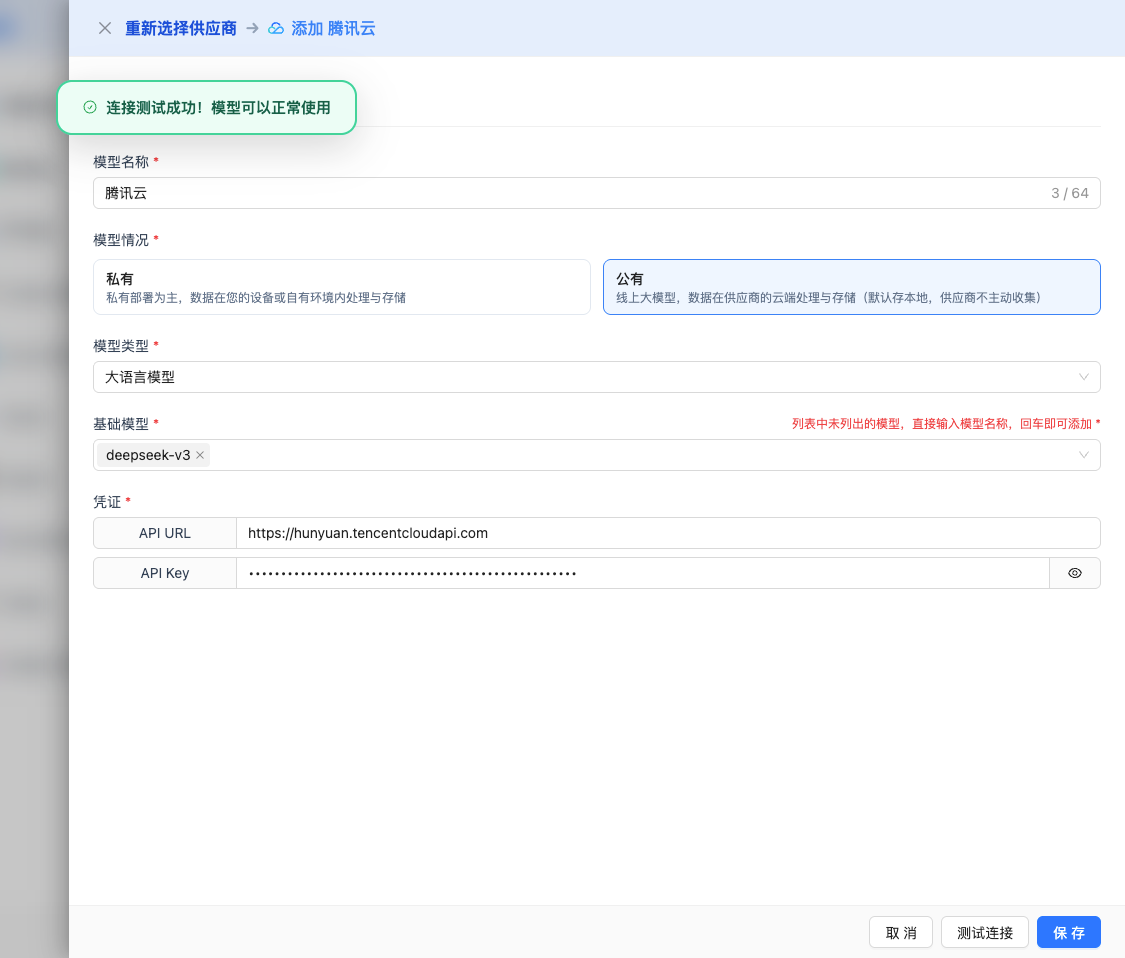

在配置頁面填寫以下資訊:

基礎配置

- 模型名稱:為這個模型配置起個名字(例如:DeepSeek-V3.1)

- API URL:保持預設

https://api.lkeap.cloud.tencent.com/v1(OpenAI 相容格式) - API Key:貼上剛才複製的 API Key

- 模型版本:選擇要使用的模型ID,常用模型包括:

deepseek-v3.1:685B引數,最大輸出32K,混合推理,適合複雜任務deepseek-v3.1-terminus:685B引數,最大輸出32K,最佳化語言一致性deepseek-v3.2-exp:685B引數,最大輸出64K推理,稀疏注意力機制deepseek-r1-0528:671B引數,最大輸出16K,增強程式碼生成和長文字處理deepseek-r1:671B引數,最大輸出16K,推理模型,適合數學和複雜邏輯deepseek-v3-0324:671B引數,最大輸出16K,128K上下文,強程式設計能力deepseek-v3:671B引數,最大輸出16K,64K上下文,通用知識和數學推理

高階配置(可選)

展開 高階配置 面板,可以調整以下引數:

CueMate 介面可調引數:

溫度(temperature):控制輸出隨機性

- 範圍:0-2

- 推薦值:0.7

- 作用:值越高輸出越隨機創新,值越低輸出越穩定保守

- 使用建議:

- 創意寫作/頭腦風暴:1.0-1.5

- 常規對話/問答:0.7-0.9

- 程式碼生成/精確任務:0.3-0.5

輸出最大 tokens(max_tokens):限制單次輸出長度

- 範圍:256 - 64000(根據模型而定)

- 推薦值:8192

- 作用:控制模型單次響應的最大字數

- 模型限制:

- deepseek-v3.1/v3.1-terminus:最大 32K tokens

- deepseek-v3.2-exp:最大 64K tokens(推理模式)

- deepseek-r1/r1-0528:最大 16K tokens

- deepseek-v3/v3-0324:最大 16K tokens

- 使用建議:

- 簡短問答:1024-2048

- 常規對話:4096-8192

- 長文生成:16384-32768

- 超長推理:65536(僅 v3.2-exp)

騰訊雲知識引擎 API 支援的其他高階引數:

雖然 CueMate 介面只提供 temperature 和 max_tokens 調整,但如果你透過 API 直接呼叫騰訊雲知識引擎,還可以使用以下高階引數(採用 OpenAI 相容的 API 格式):

top_p(nucleus sampling)

- 範圍:0-1

- 預設值:1

- 作用:從機率累積達到 p 的最小候選集中取樣

- 與 temperature 的關係:通常只調整其中一個

- 使用建議:

- 保持多樣性但避免離譜:0.9-0.95

- 更保守的輸出:0.7-0.8

frequency_penalty(頻率懲罰)

- 範圍:-2.0 到 2.0

- 預設值:0

- 作用:降低重複相同詞彙的機率(基於詞頻)

- 使用建議:

- 減少重複:0.3-0.8

- 允許重複:0(預設)

presence_penalty(存在懲罰)

- 範圍:-2.0 到 2.0

- 預設值:0

- 作用:降低已出現過的詞彙再次出現的機率(基於是否出現)

- 使用建議:

- 鼓勵新話題:0.3-0.8

- 允許重複話題:0(預設)

stop(停止序列)

- 型別:字串或陣列

- 預設值:null

- 作用:當生成內容包含指定字串時停止

- 示例:

["###", "使用者:", "\n\n"] - 使用場景:

- 結構化輸出:使用分隔符控制格式

- 對話系統:防止模型代替使用者說話

stream(流式輸出)

- 型別:布林值

- 預設值:false

- 作用:啟用 SSE 流式返回,邊生成邊返回

- CueMate 中:自動處理,無需手動設定

| 序號 | 場景 | temperature | max_tokens | top_p | frequency_penalty | presence_penalty |

|---|---|---|---|---|---|---|

| 1 | 創意寫作 | 1.0-1.2 | 4096-8192 | 0.95 | 0.5 | 0.5 |

| 2 | 程式碼生成 | 0.2-0.5 | 2048-4096 | 0.9 | 0.0 | 0.0 |

| 3 | 問答系統 | 0.7 | 1024-2048 | 0.9 | 0.0 | 0.0 |

| 4 | 摘要總結 | 0.3-0.5 | 512-1024 | 0.9 | 0.0 | 0.0 |

| 5 | 複雜推理 | 0.7 | 32768-65536 | 0.9 | 0.0 | 0.0 |

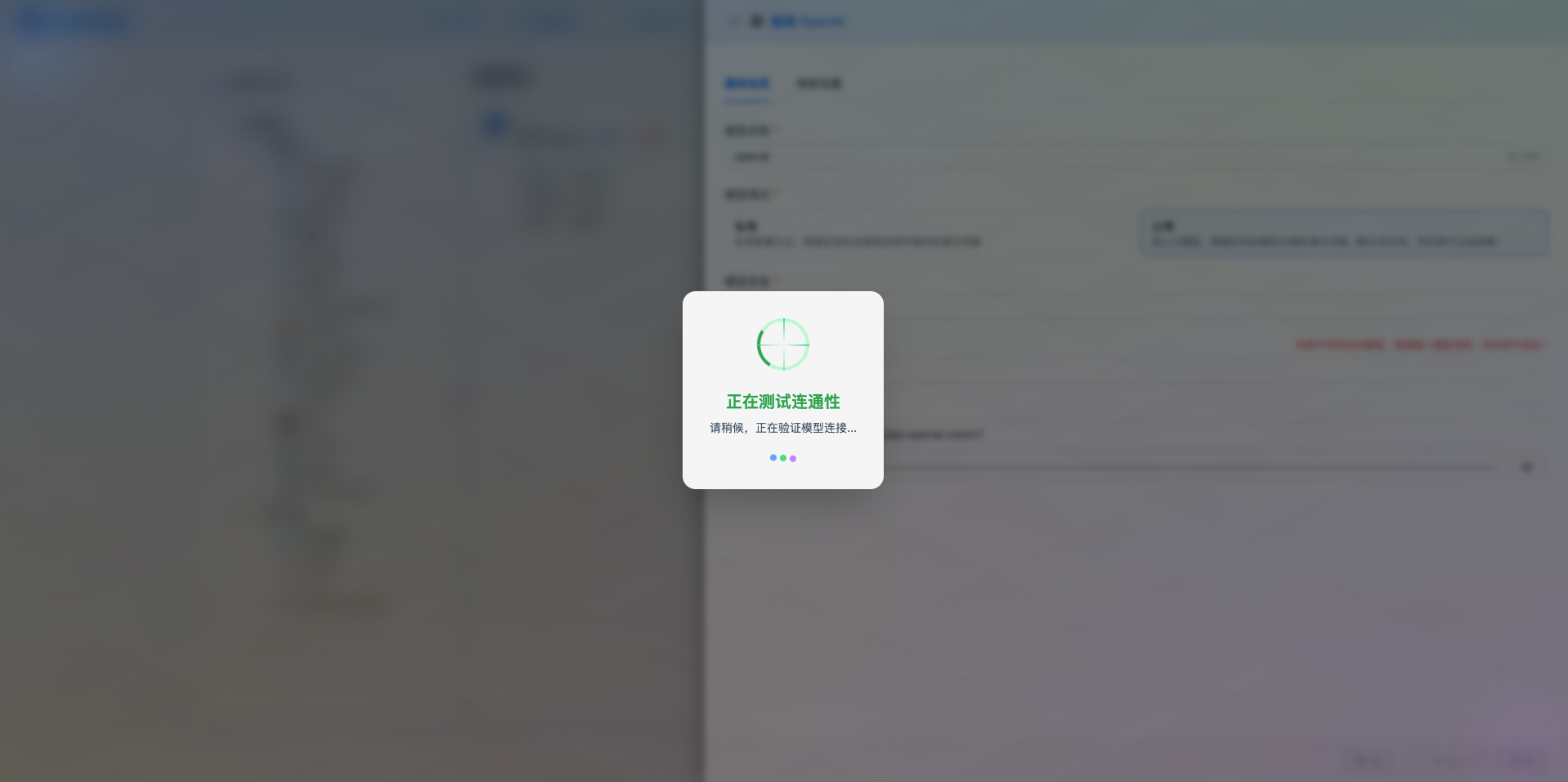

2.5 測試連線

填寫完配置後,點選 測試連線 按鈕,驗證配置是否正確。

如果配置正確,會顯示測試成功的提示,並返回模型的響應示例。

如果配置錯誤,會顯示測試錯誤的日誌,並且可以透過日誌管理,檢視具體報錯資訊。

2.6 儲存配置

測試成功後,點選 儲存 按鈕,完成模型配置。

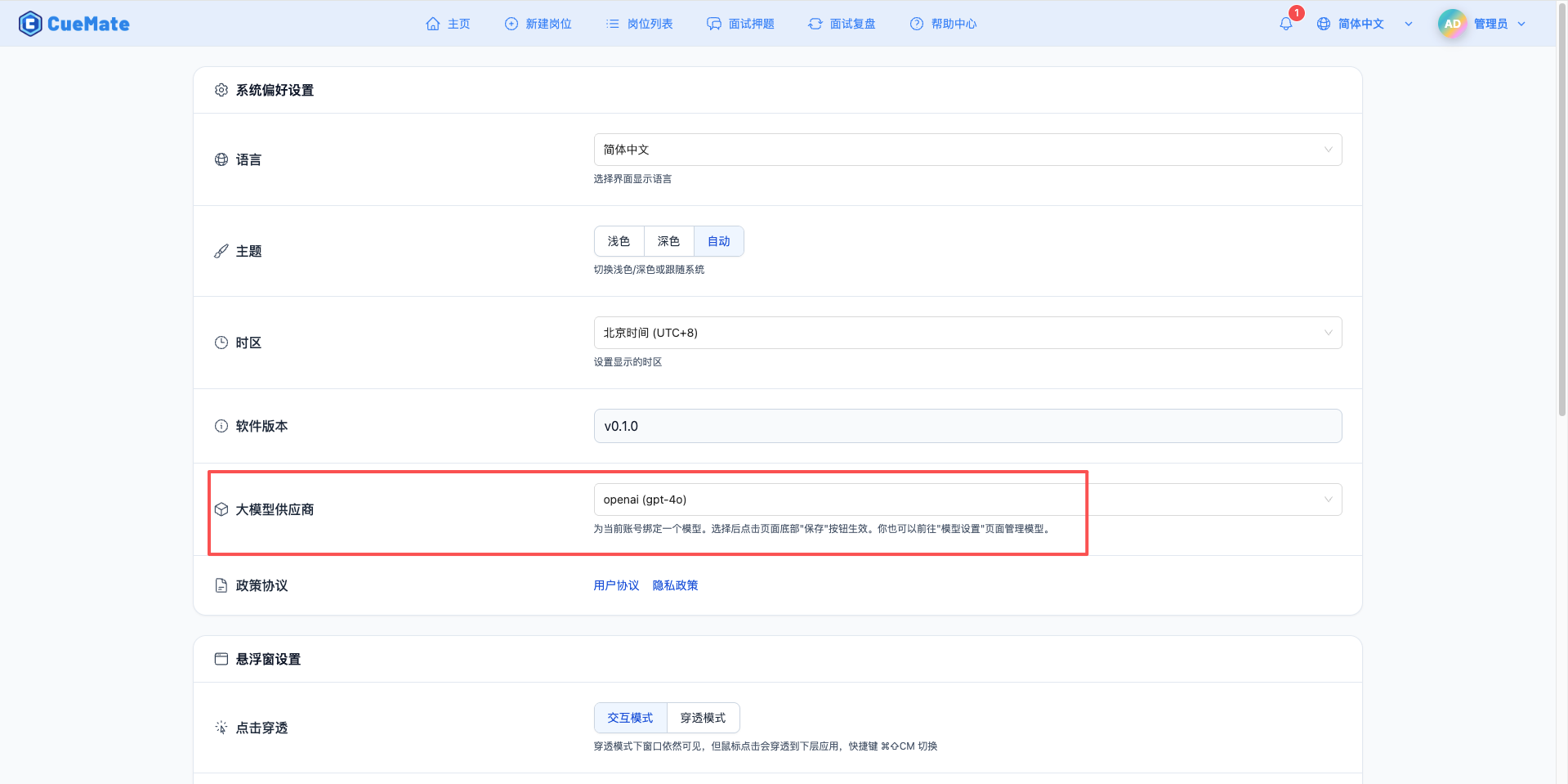

3. 使用模型

透過右上角下拉選單,進入系統設定介面,在大模型服務商欄目選擇想要使用的模型配置。

配置完成後,可以在面試訓練、問題生成等功能中選擇使用此模型,當然也可以在面試的選項中單獨選擇此次面試的模型配置。

4. 支援的模型列表

4.1 685B引數模型(最新)

| 序號 | 模型名稱 | 模型 ID | 最大輸出 | 適用場景 |

|---|---|---|---|---|

| 1 | DeepSeek-V3.1 | deepseek-v3.1 | 32K tokens | 混合推理、Agent能力、複雜任務 |

| 2 | DeepSeek-V3.1-Terminus | deepseek-v3.1-terminus | 32K tokens | 最佳化語言一致性、Agent穩定性 |

| 3 | DeepSeek-V3.2-Exp | deepseek-v3.2-exp | 64K tokens(推理) | 稀疏注意力、長文字最佳化 |

4.2 671B引數模型

| 序號 | 模型名稱 | 模型 ID | 最大輸出 | 適用場景 |

|---|---|---|---|---|

| 1 | DeepSeek-R1-0528 | deepseek-r1-0528 | 16K tokens | 增強程式碼生成、長文字處理、複雜推理 |

| 2 | DeepSeek-R1 | deepseek-r1 | 16K tokens | 數學、程式碼、複雜邏輯推理任務 |

| 3 | DeepSeek-V3-0324 | deepseek-v3-0324 | 16K tokens | 程式設計與技術能力、128K上下文 |

| 4 | DeepSeek-V3 | deepseek-v3 | 16K tokens | 通用知識、數學推理、64K上下文 |

5. 常見問題

5.1 API Key無效

現象:測試連線時提示 API Key 錯誤

解決方案:

- 檢查 API Key 是否以

sk-開頭 - 確認 API Key 完整複製

- 檢查賬戶是否有可用額度

- 驗證 API Key 未過期或被禁用

5.2 請求超時

現象:測試連線或使用時長時間無響應

解決方案:

- 檢查網路連線是否正常

- 確認 API URL 地址正確:

https://api.lkeap.cloud.tencent.com/v1 - 檢查防火牆設定

5.3 模型不可用

現象:提示模型服務不可用

解決方案:

- 確認選擇的模型ID正確

- 檢查賬戶是否開通了知識引擎原子能力服務

- 聯絡騰訊雲客服確認服務狀態

5.4 配額限制

現象:提示超出請求配額

解決方案:

- 登入騰訊雲控制檯檢視配額使用情況

- 申請提高配額限制(API頻率限制為20次/秒)

- 最佳化使用頻率