配置本地大模型

本地大模型是指在個人電腦或私有伺服器上部署的開源大語言模型,無需依賴雲端 API。支援多種推理框架(Ollama、vLLM、Xinference 等),提供資料隱私保護和完全離線執行能力。

1. 部署本地模型服務

本地大模型支援多種推理框架,包括 Ollama、vLLM、Xinference 等。本文件以通用方式介紹如何配置本地模型服務。

1.1 選擇推理框架

根據您的需求選擇合適的推理框架:

- Ollama:易於使用,適合個人開發者

- vLLM:高效能推理,適合生產環境

- Xinference:支援多種模型,功能豐富

詳細安裝說明請參考各框架的獨立文件:

1.2 啟動本地服務

以 Ollama 為例:

# 下載模型

ollama pull deepseek-r1:7b

# Ollama 會自動啟動服務,預設監聽 http://localhost:114341.3 驗證服務執行

# 檢查服務狀態

curl http://localhost:11434/api/version2. 在 CueMate 中配置本地模型

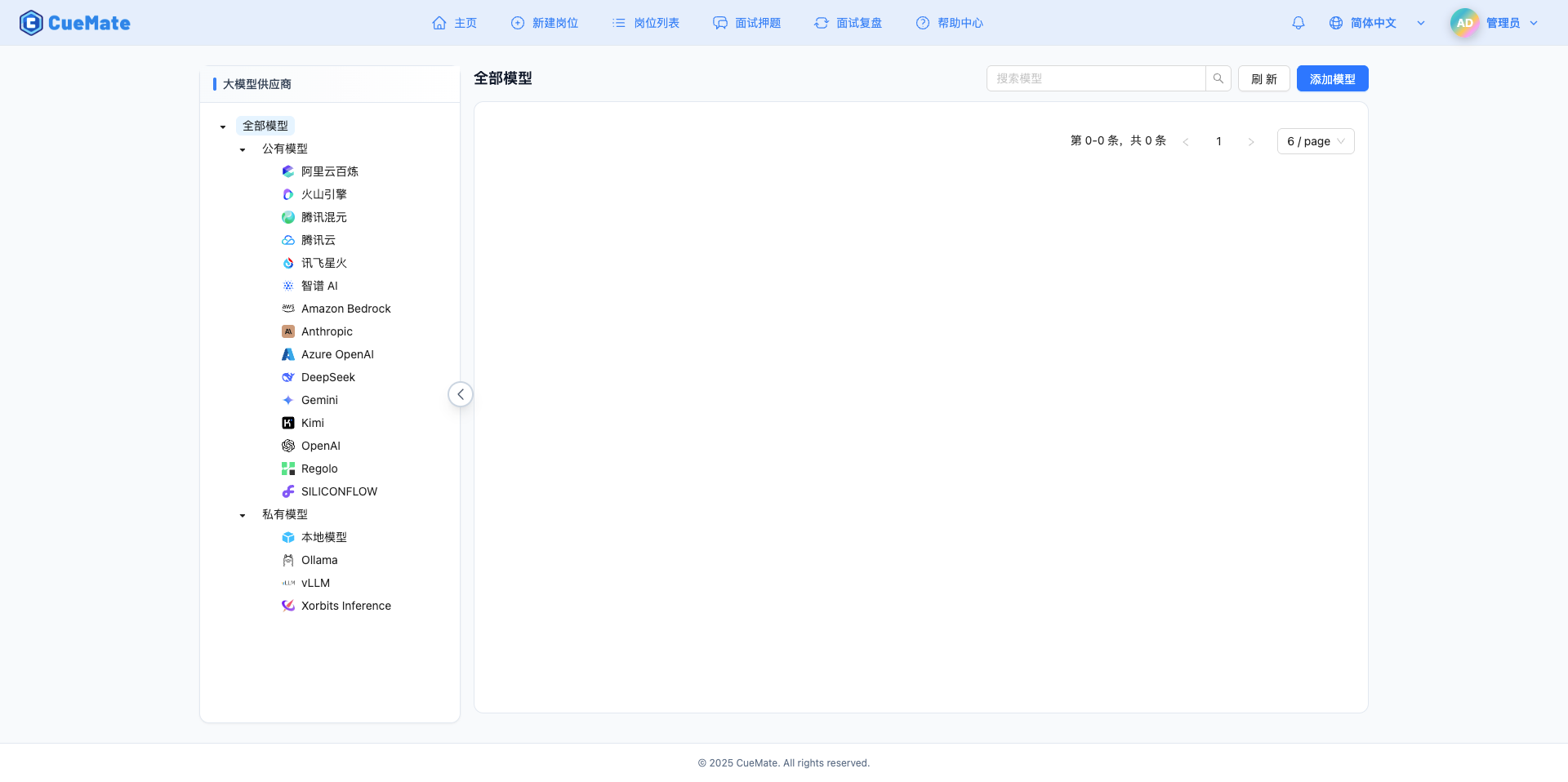

2.1 進入模型設定頁面

登入 CueMate 系統後,點選右上角下拉選單的 模型設定。

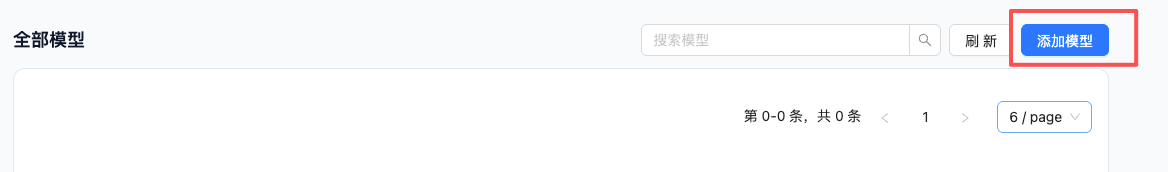

2.2 新增新模型

點選右上角的 新增模型 按鈕。

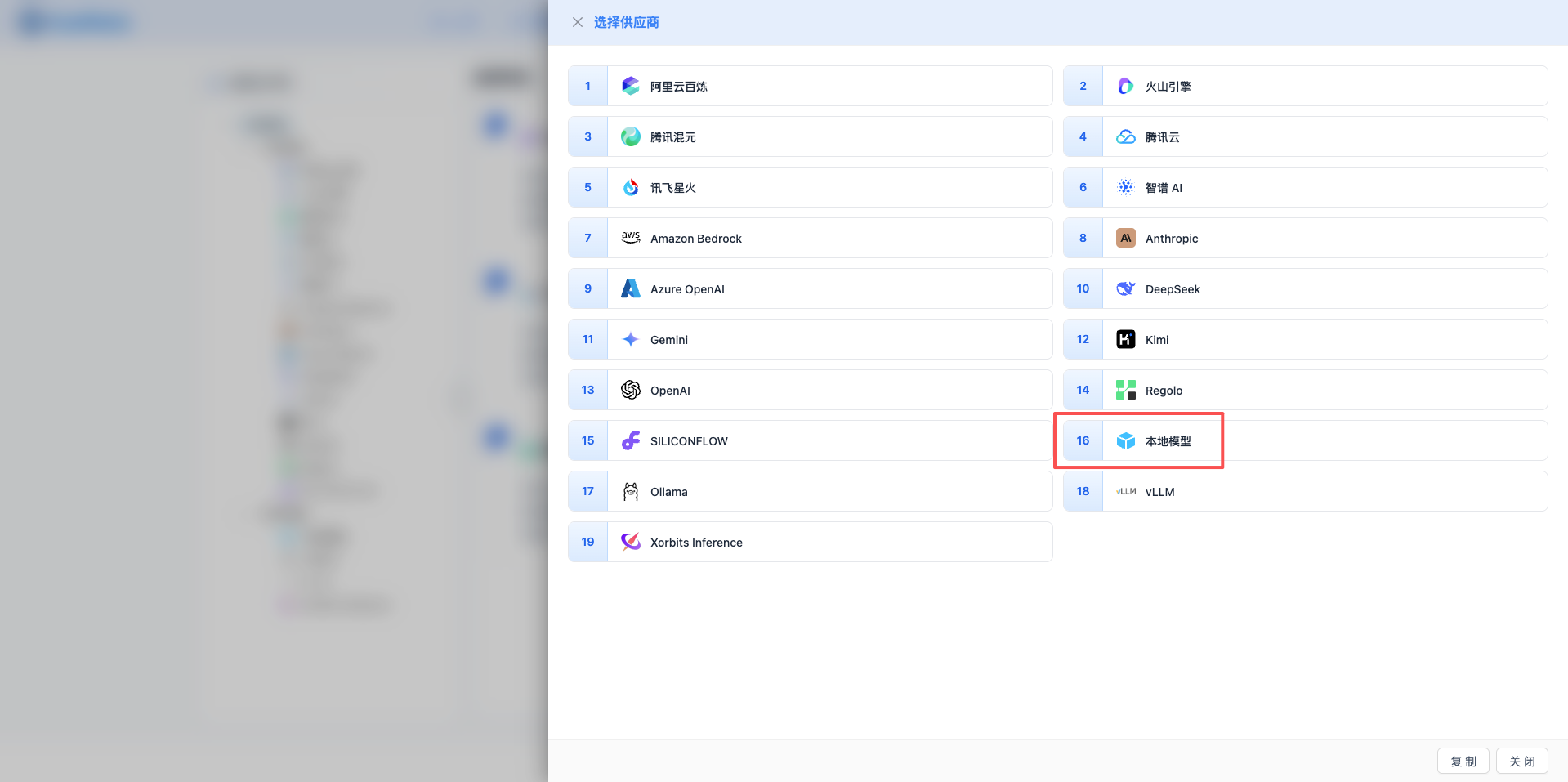

2.3 選擇本地模型服務商

在彈出的對話方塊中:

- 服務商型別:選擇 本地模型

- 點選後 自動進入下一步

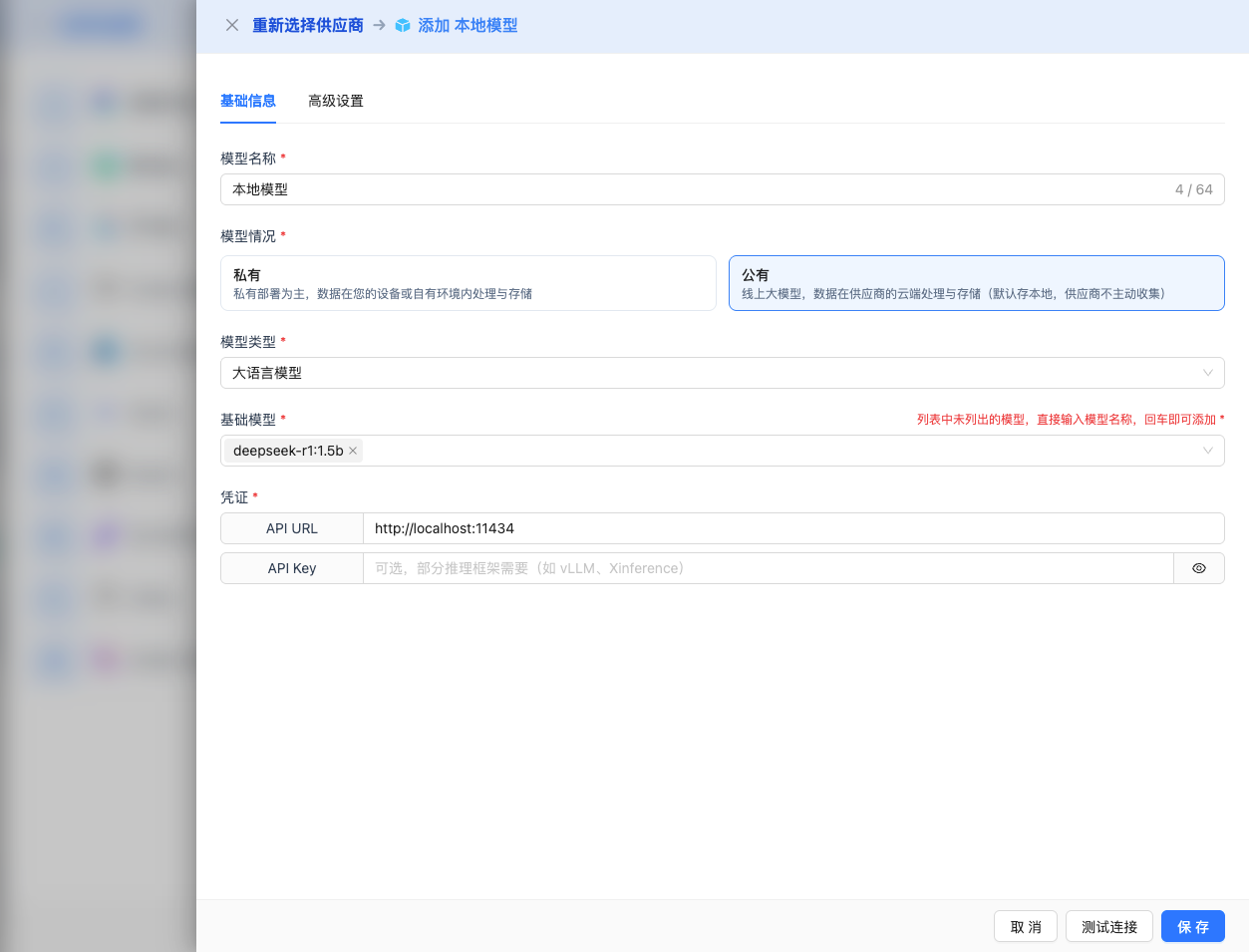

2.4 填寫配置資訊

在配置頁面填寫以下資訊:

基礎配置

- 模型名稱:為這個模型配置起個名字(例如:本地 DeepSeek R1)

- API URL:填寫本地服務地址

- Ollama 預設:

http://localhost:11434 - vLLM 預設:

http://localhost:8000/v1 - Xinference 預設:

http://localhost:9997/v1

- Ollama 預設:

- 模型版本:輸入已部署的模型名稱

2025 推薦模型:

- DeepSeek R1 系列:

deepseek-r1:1.5b、deepseek-r1:7b、deepseek-r1:14b、deepseek-r1:32b - Llama 3.3 系列:

llama3.3:70b(最新版本) - Llama 3.2 系列:

llama3.2:1b、llama3.2:3b、llama3.2:11b、llama3.2:90b - Llama 3.1 系列:

llama3.1:8b、llama3.1:70b、llama3.1:405b - Qwen 2.5 系列:

qwen2.5:0.5b、qwen2.5:1.5b、qwen2.5:3b、qwen2.5:7b、qwen2.5:14b、qwen2.5:32b、qwen2.5:72b

注意:模型版本必須是已在本地服務中部署的模型。不同推理框架的模型命名可能略有不同,請根據實際情況調整。

高階配置(可選)

展開 高階配置 面板,可以調整以下引數:

CueMate 介面可調引數:

溫度(temperature):控制輸出隨機性

- 範圍:0-2(根據模型而定)

- 推薦值:0.7

- 作用:值越高輸出越隨機創新,值越低輸出越穩定保守

- 模型範圍:

- DeepSeek/Llama 系列:0-2

- Qwen 系列:0-1

- 使用建議:

- 創意寫作:0.8-1.2

- 常規對話:0.6-0.8

- 程式碼生成:0.3-0.5

輸出最大 tokens(max_tokens):限制單次輸出長度

- 範圍:256 - 8192

- 推薦值:4096

- 作用:控制模型單次響應的最大字數

- 使用建議:

- 簡短問答:1024-2048

- 常規對話:4096-8192

- 長文生成:8192(最大)

本地模型 API 支援的其他引數:

本地模型服務(Ollama、vLLM、Xinference)通常採用 OpenAI 相容的 API 格式,支援以下高階引數:

top_p(nucleus sampling)

- 範圍:0-1

- 預設值:0.9

- 作用:從機率累積達到 p 的最小候選集中取樣

- 使用建議:保持預設 0.9,與 temperature 通常只調整一個

top_k

- 範圍:1-100

- 預設值:40(Ollama),50(vLLM)

- 作用:從機率最高的 k 個候選詞中取樣

- 使用建議:通常保持預設值

frequency_penalty(頻率懲罰)

- 範圍:-2.0 到 2.0

- 預設值:0

- 作用:降低重複相同詞彙的機率

- 使用建議:減少重複時設為 0.3-0.8

presence_penalty(存在懲罰)

- 範圍:-2.0 到 2.0

- 預設值:0

- 作用:降低已出現過的詞彙再次出現的機率

- 使用建議:鼓勵新話題時設為 0.3-0.8

stream(流式輸出)

- 型別:布林值

- 預設值:false

- 作用:啟用流式返回,邊生成邊返回

- CueMate 中:自動處理,無需手動設定

| 場景 | temperature | max_tokens | top_p | 推薦模型 |

|---|---|---|---|---|

| 創意寫作 | 0.8-1.0 | 4096-8192 | 0.9 | DeepSeek R1 7B/14B |

| 程式碼生成 | 0.3-0.5 | 2048-4096 | 0.9 | Qwen 2.5 7B/14B |

| 問答系統 | 0.7 | 1024-2048 | 0.9 | Llama 3.2 11B |

| 技術面試 | 0.6-0.7 | 2048-4096 | 0.9 | DeepSeek R1 7B/14B |

| 快速響應 | 0.5 | 1024-2048 | 0.9 | Llama 3.2 3B |

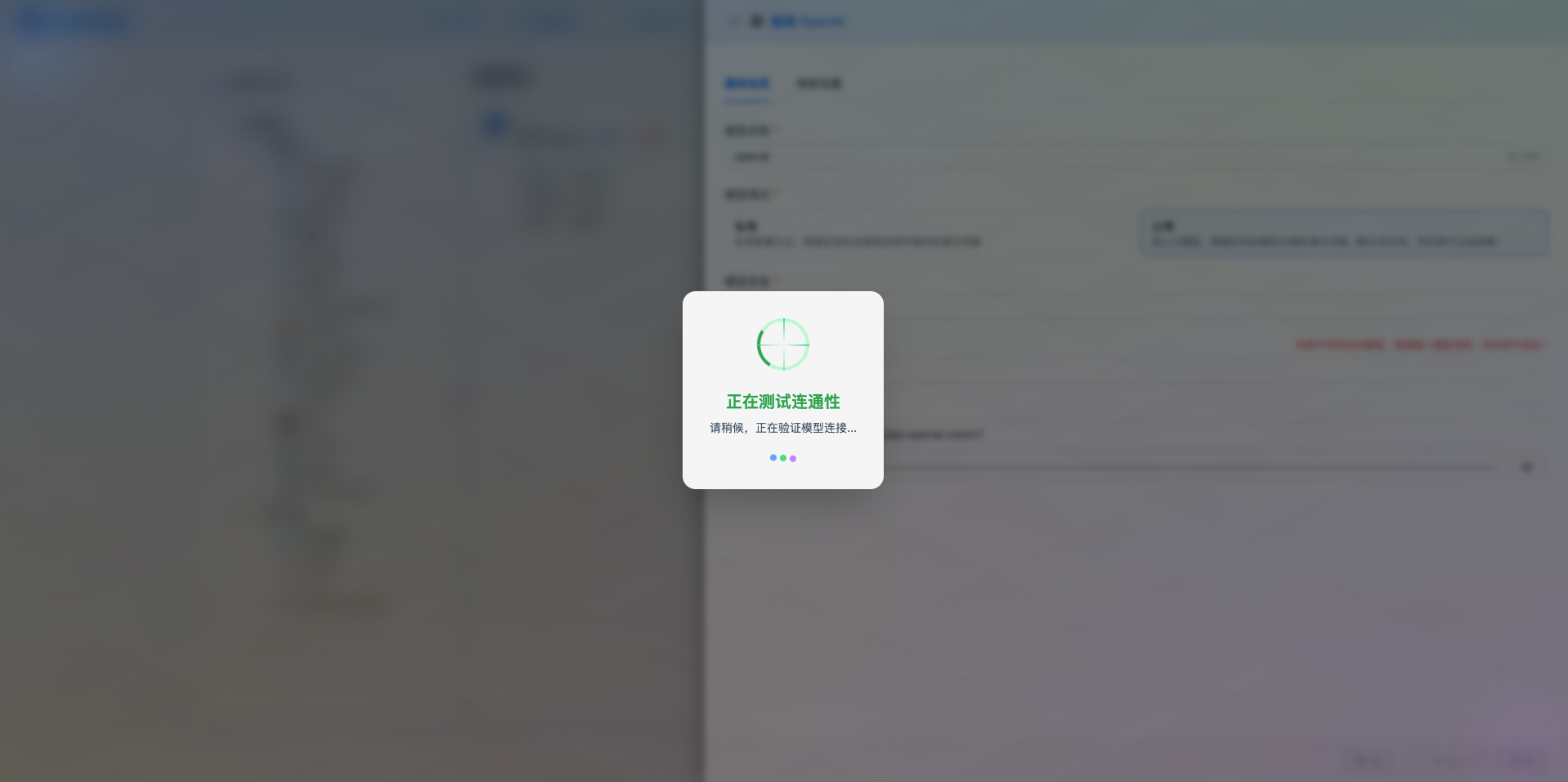

2.5 測試連線

填寫完配置後,點選 測試連線 按鈕,驗證配置是否正確。

如果配置正確,會顯示測試成功的提示,並返回模型的響應示例。

如果配置錯誤,會顯示測試錯誤的日誌,並且可以透過日誌管理,檢視具體報錯資訊。

2.6 儲存配置

測試成功後,點選 儲存 按鈕,完成模型配置。

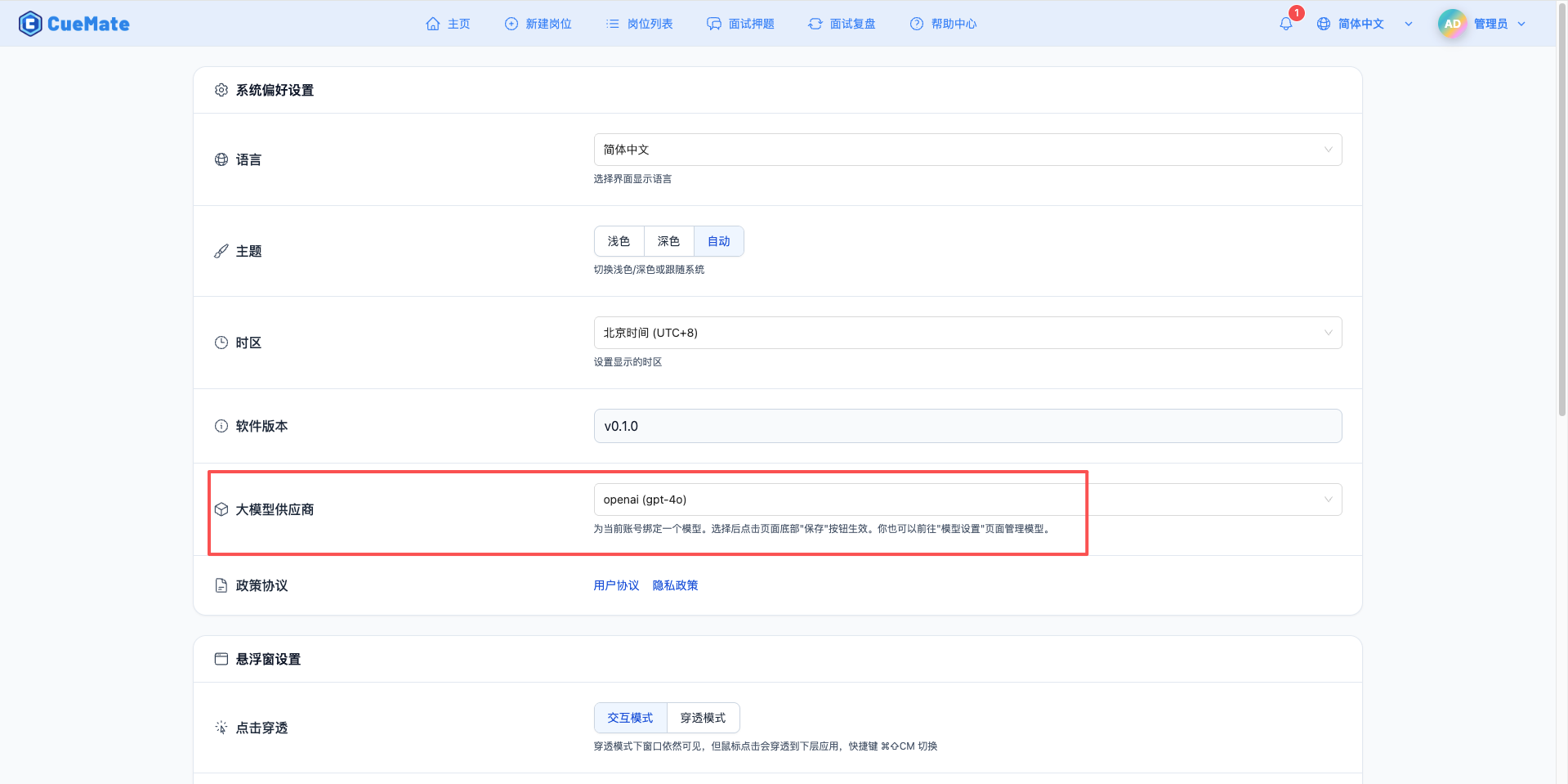

3. 使用模型

透過右上角下拉選單,進入系統設定介面,在大模型服務商欄目選擇想要使用的模型配置。

配置完成後,可以在面試訓練、問題生成等功能中選擇使用此模型, 當然也可以在面試的選項中單此選擇此次面試的模型配置。

4. 支援的模型系列

DeepSeek R1 系列

| 模型名稱 | 模型 ID | 引數量 | 最大輸出 | 適用場景 |

|---|---|---|---|---|

| DeepSeek R1 1.5B | deepseek-r1:1.5b | 1.5B | 8K tokens | 輕量級推理 |

| DeepSeek R1 7B | deepseek-r1:7b | 7B | 8K tokens | 推理增強、技術面試 |

| DeepSeek R1 14B | deepseek-r1:14b | 14B | 8K tokens | 高效能推理 |

| DeepSeek R1 32B | deepseek-r1:32b | 32B | 8K tokens | 超強推理能力 |

Llama 3 系列

| 模型名稱 | 模型 ID | 引數量 | 最大輸出 | 適用場景 |

|---|---|---|---|---|

| Llama 3.3 70B | llama3.3:70b | 70B | 8K tokens | 最新版本、高效能 |

| Llama 3.2 90B | llama3.2:90b | 90B | 8K tokens | 超大規模推理 |

| Llama 3.2 11B | llama3.2:11b | 11B | 8K tokens | 中等規模任務 |

| Llama 3.2 3B | llama3.2:3b | 3B | 8K tokens | 小規模任務 |

| Llama 3.2 1B | llama3.2:1b | 1B | 8K tokens | 超輕量級 |

| Llama 3.1 405B | llama3.1:405b | 405B | 8K tokens | 超大規模推理 |

| Llama 3.1 70B | llama3.1:70b | 70B | 8K tokens | 大規模任務 |

| Llama 3.1 8B | llama3.1:8b | 8B | 8K tokens | 標準任務 |

Qwen 2.5 系列

| 模型名稱 | 模型 ID | 引數量 | 最大輸出 | 適用場景 |

|---|---|---|---|---|

| Qwen 2.5 72B | qwen2.5:72b | 72B | 8K tokens | 超大規模任務 |

| Qwen 2.5 32B | qwen2.5:32b | 32B | 8K tokens | 大規模任務 |

| Qwen 2.5 14B | qwen2.5:14b | 14B | 8K tokens | 中等規模任務 |

| Qwen 2.5 7B | qwen2.5:7b | 7B | 8K tokens | 通用場景、價效比高 |

| Qwen 2.5 3B | qwen2.5:3b | 3B | 8K tokens | 小規模任務 |

| Qwen 2.5 1.5B | qwen2.5:1.5b | 1.5B | 8K tokens | 輕量級任務 |

| Qwen 2.5 0.5B | qwen2.5:0.5b | 0.5B | 8K tokens | 超輕量級 |

5. 常見問題

服務連線失敗

現象:測試連線時提示無法連線

解決方案:

- 確認本地推理服務是否執行

- 檢查 API URL 配置是否正確

- 驗證埠是否被佔用

- 檢查防火牆設定

模型未部署

現象:提示模型不存在

解決方案:

- 確認模型已在本地服務中部署

- 檢查模型名稱拼寫是否正確

- 檢視推理服務的模型列表

效能問題

現象:模型響應速度慢

解決方案:

- 選擇引數量較小的模型

- 確保有足夠的 GPU 記憶體或系統記憶體

- 最佳化推理框架配置

- 考慮使用量化模型

記憶體不足

現象:模型載入失敗或系統卡頓

解決方案:

- 選擇更小引數量的模型

- 使用量化版本(如 4-bit、8-bit)

- 增加系統記憶體或使用 GPU

- 調整推理框架的記憶體配置

最低配置

| 模型引數 | CPU | 記憶體 | GPU |

|---|---|---|---|

| 0.5B-3B | 4 核 | 8GB | 可選 |

| 7B-14B | 8 核 | 16GB | 推薦 |

| 32B-70B | 16 核 | 64GB | 必需 |

推薦配置

| 模型引數 | CPU | 記憶體 | GPU |

|---|---|---|---|

| 0.5B-3B | 8 核 | 16GB | GTX 1660 |

| 7B-14B | 16 核 | 32GB | RTX 3060 |

| 32B-70B | 32 核 | 128GB | RTX 4090 |

資料隱私

- 所有資料處理在本地完成

- 不依賴外部 API 服務

- 完全掌控資料安全

成本控制

- 無 API 呼叫費用

- 一次性硬體投入

- 長期使用成本低

靈活性

- 支援自定義模型

- 可調整推理引數

- 完全控制服務配置

適用場景

- 企業內部部署

- 敏感資料處理

- 離線環境使用

- 開發測試環境