配置 Ollama

Ollama 是一個輕量級本地大模型執行框架,支援在個人電腦上快速部署和執行開源大語言模型。提供簡單的命令列工具和 API 介面,讓本地 AI 部署變得簡單高效。

1. 安裝 Ollama

1.1 下載 Ollama

訪問 Ollama 官網下載對應系統的安裝包:https://ollama.com/

1.2 安裝 Ollama

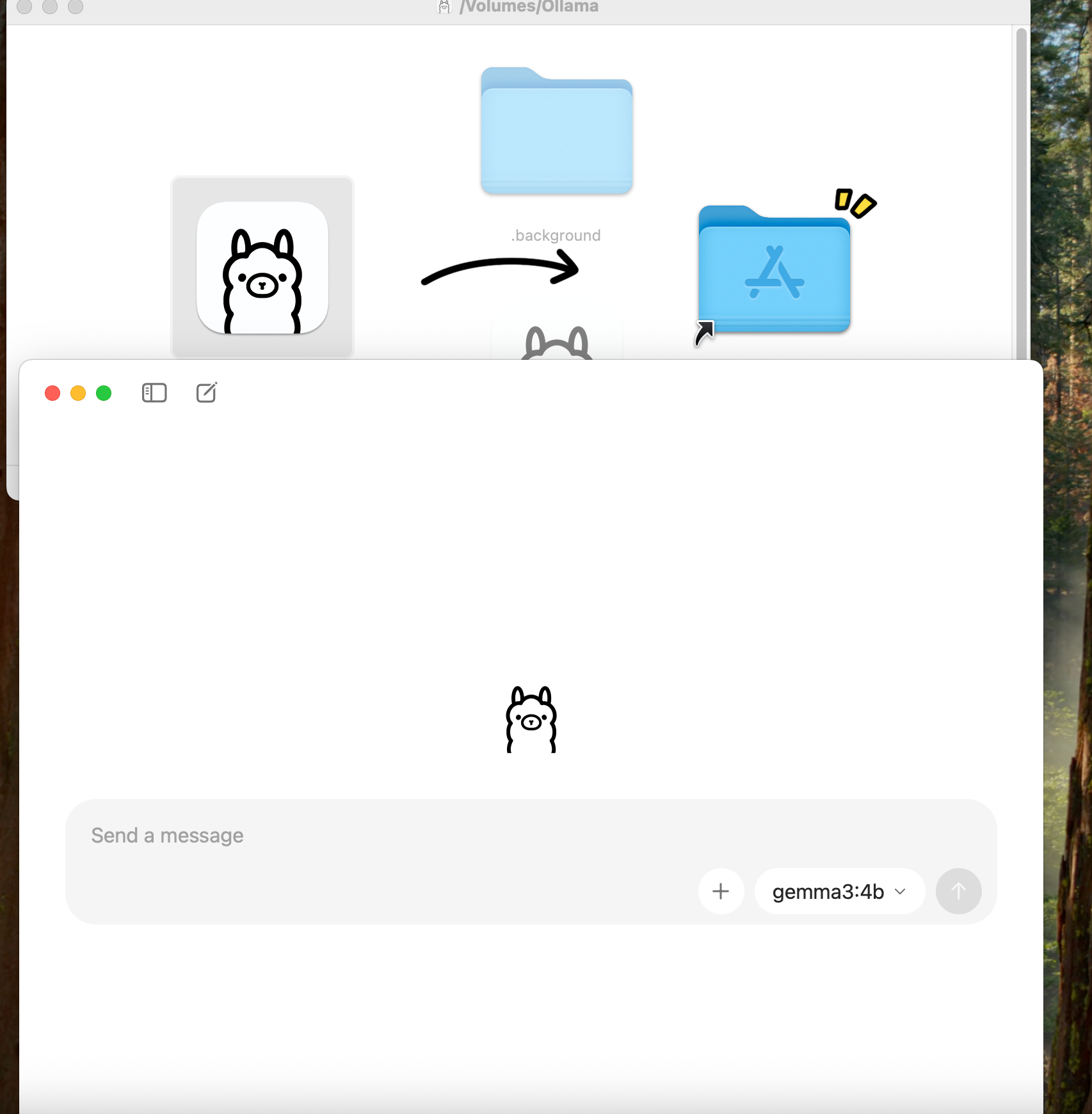

下載對應系統的安裝包並執行安裝程式:

- macOS:下載 .dmg 檔案,拖拽到 Applications 資料夾

- Windows:下載 .exe 安裝包,雙擊執行安裝

- Linux:下載對應發行版的安裝包(.deb / .rpm)或使用包管理器安裝

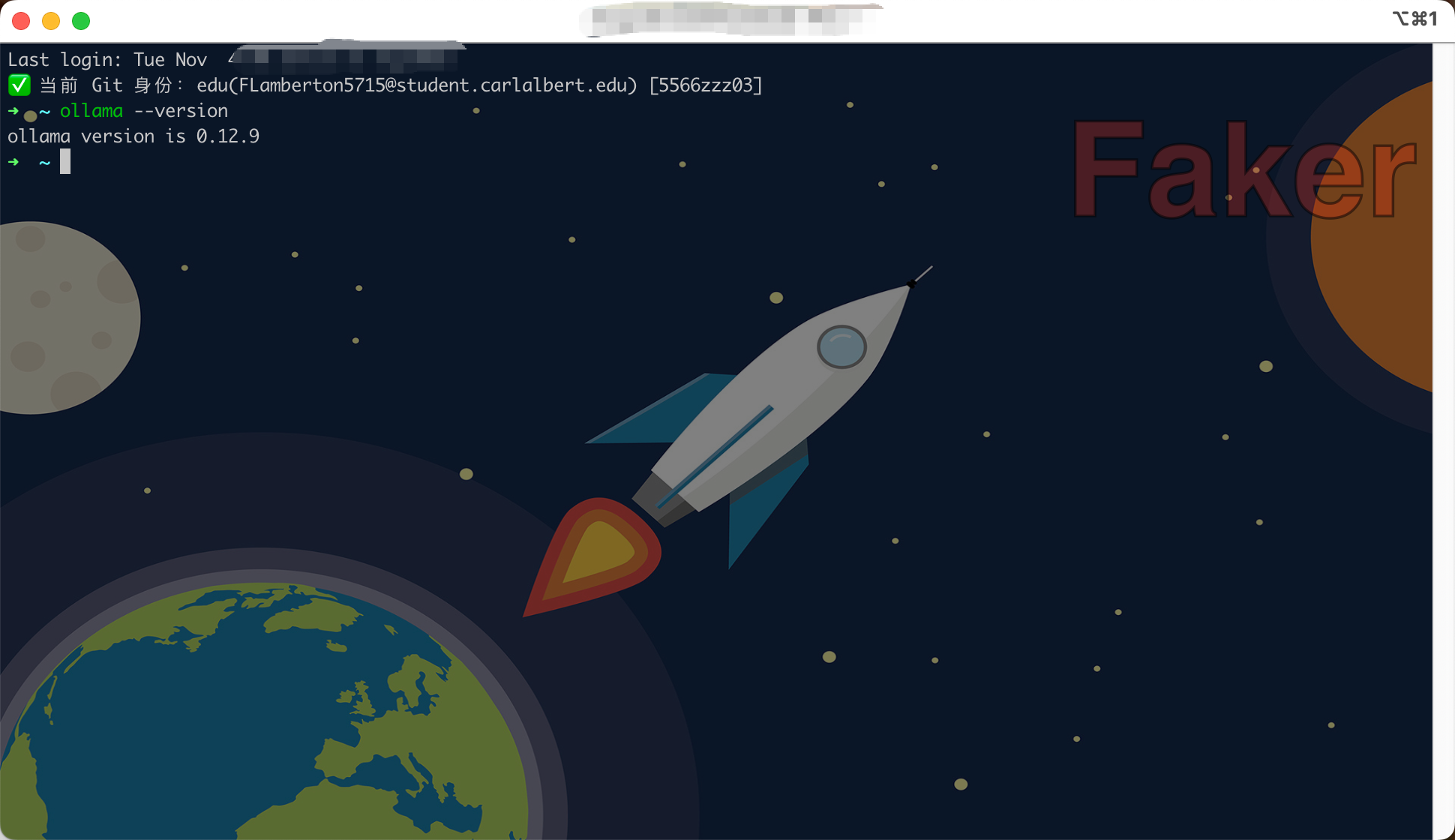

1.3 驗證安裝

開啟終端,執行以下命令驗證安裝:

ollama --version

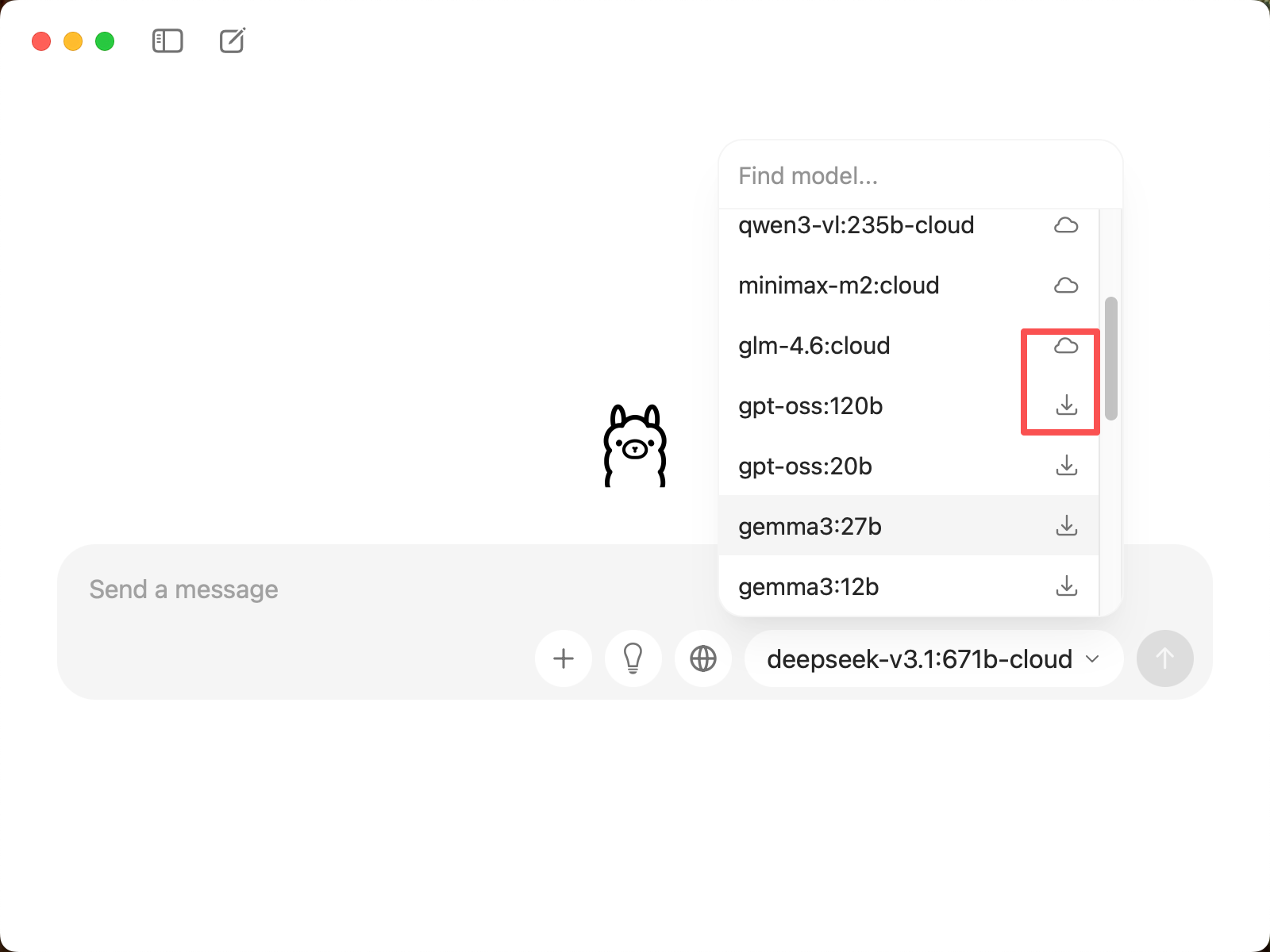

1.4 選擇模型

在 CueMate 的模型選擇介面,你可以看到兩種型別的模型:

雲端模型(名稱包含

-cloud):- 無需下載,直接透過網路呼叫

- 示例:

deepseek-v3.1:671b-cloud、qwen3-coder:480b-cloud、glm-4.6:cloud - 優勢:無需本地儲存空間,支援超大引數模型(如 671B)

本地模型(標記 ↓,無

-cloud字尾):- 首次選擇時會自動下載到本地

- 示例:

gpt-oss:120b、gemma3:27b、deepseek-r1:8b、qwen3:8b - 優勢:執行速度快,無需網路連線,資料隱私性高

1.5 雲端模型配置(使用雲端模型必做)

如果你選擇使用雲端模型(如 deepseek-v3.1:671b-cloud),需要先在 Ollama 官網建立模型:

1.5.1 訪問 Ollama 官網

訪問 https://ollama.com/ 並登入或註冊賬號。

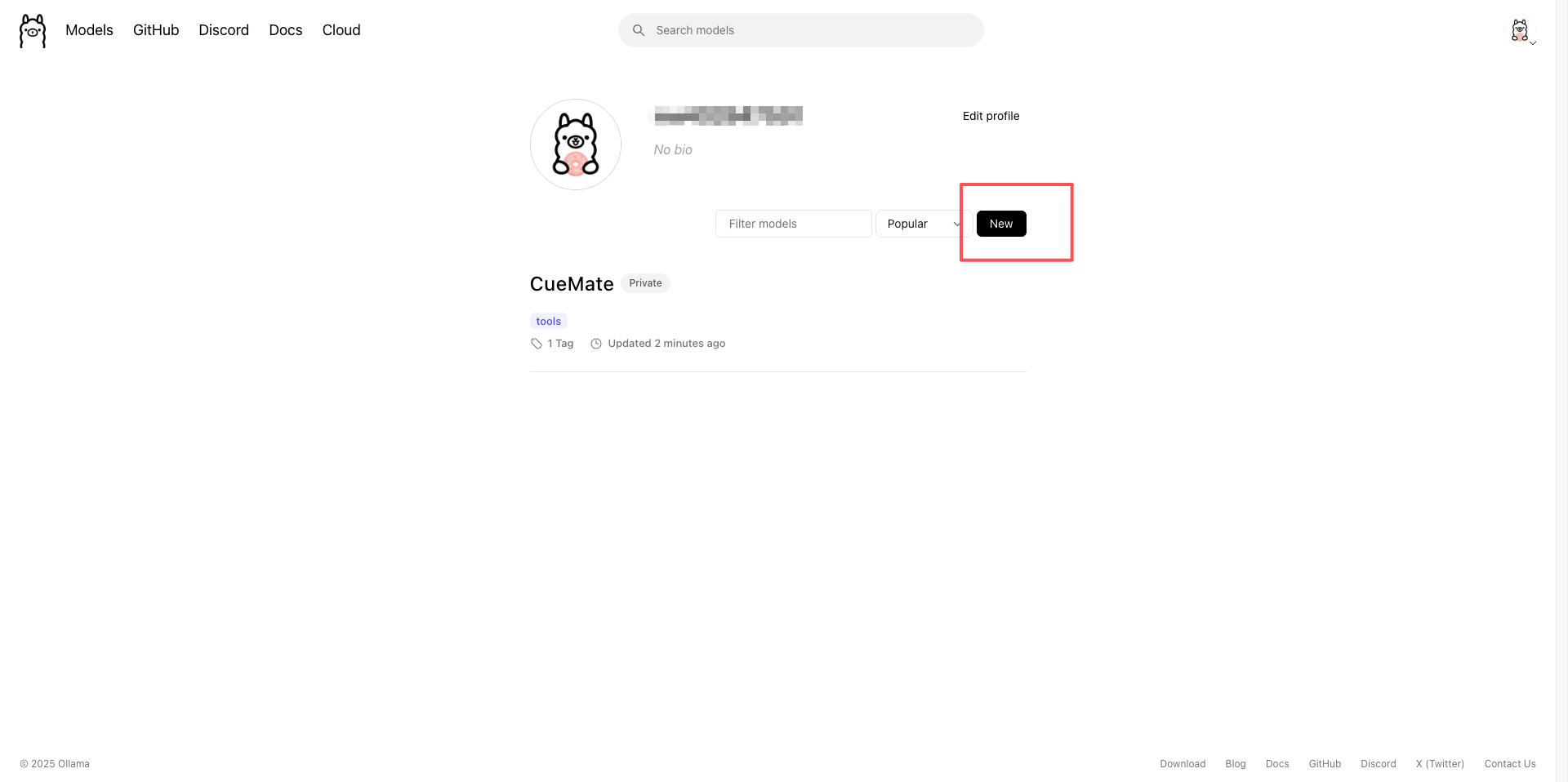

1.5.2 建立雲端模型

- 登入後,點選 Models 選單

- 點選 Create a new model 按鈕

- 填寫模型名稱(例如:CueMate)

- 選擇 Private(私有)或 Public(公開)

- 點選 Create model 完成建立

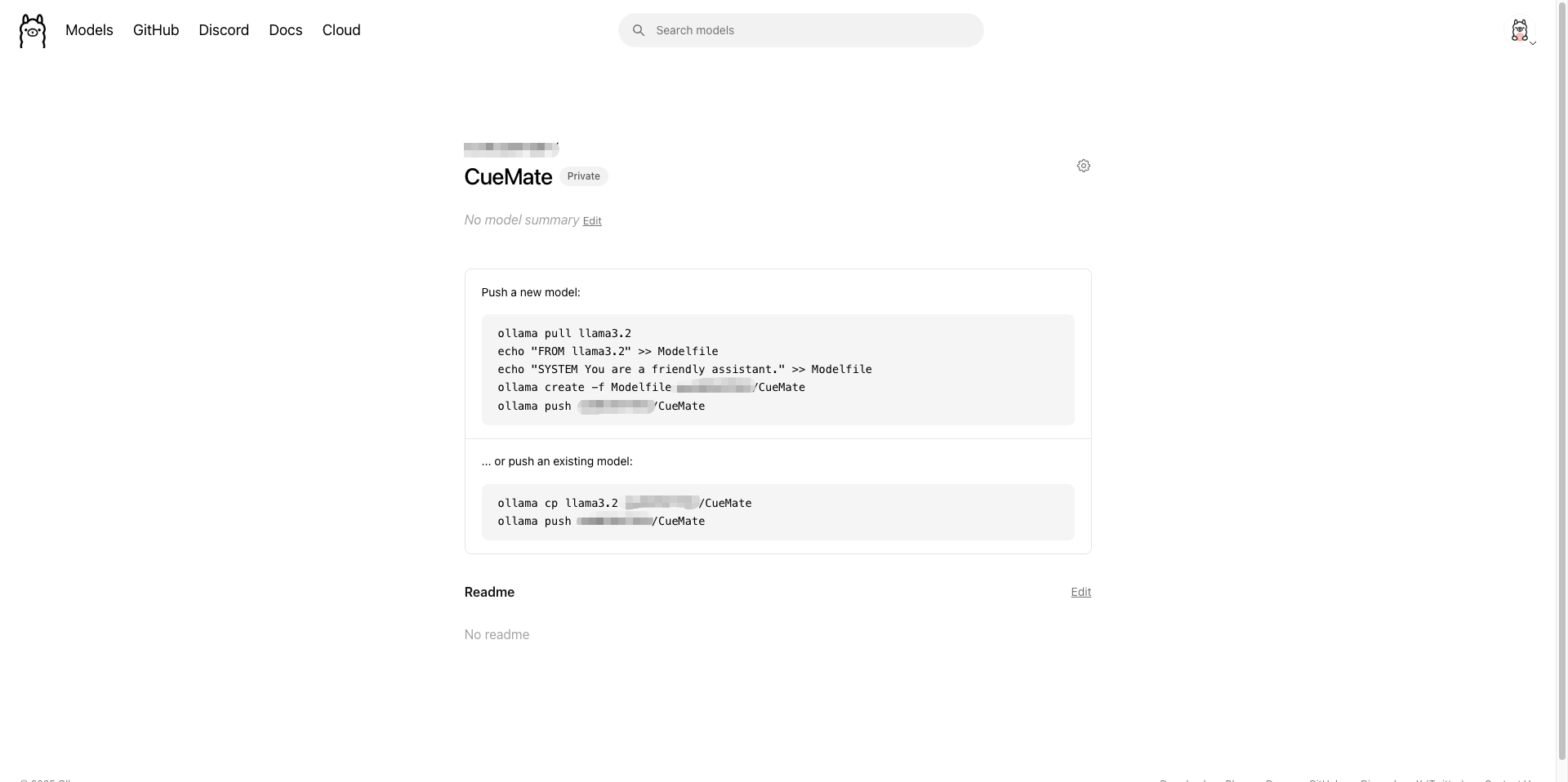

建立後會進入模型詳情頁:

1.5.3 推送模型到雲端

建立模型後,頁面會顯示推送命令。有兩種方式:

方式一:基於現有模型建立並推送

# 1. 拉取基礎模型

ollama pull llama3.2

# 2. 建立 Modelfile

echo "FROM llama3.2" >> Modelfile

echo "SYSTEM You are a friendly assistant." >> Modelfile

# 3. 建立自定義模型

ollama create -f Modelfile 你的使用者名稱/CueMate

# 4. 推送到雲端

ollama push 你的使用者名稱/CueMate方式二:直接複製現有模型並推送

# 複製現有模型

ollama cp llama3.2 你的使用者名稱/CueMate

# 推送到雲端

ollama push 你的使用者名稱/CueMate

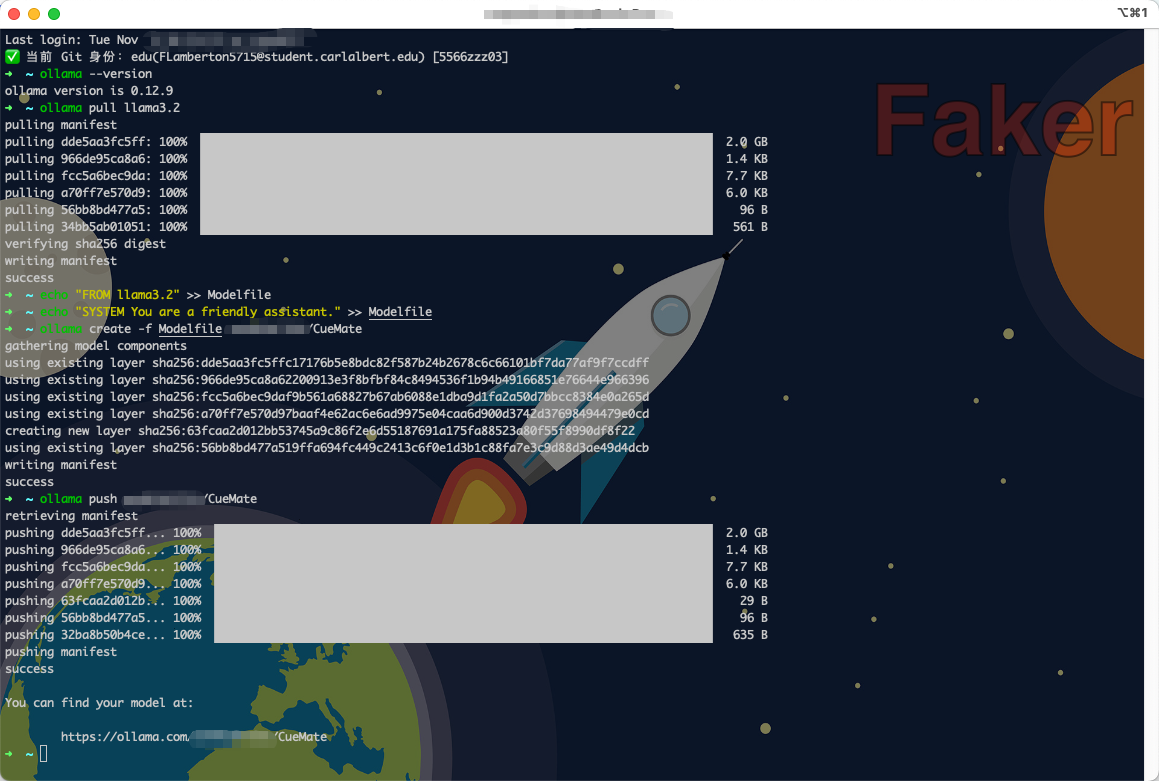

1.5.4 檢視雲端模型地址

推送成功後,頁面會顯示你的雲端模型訪問地址:

You can find your model at:

https://ollama.com/你的使用者名稱/CueMate這個地址就是你的雲端模型連結,可以分享給其他人使用。

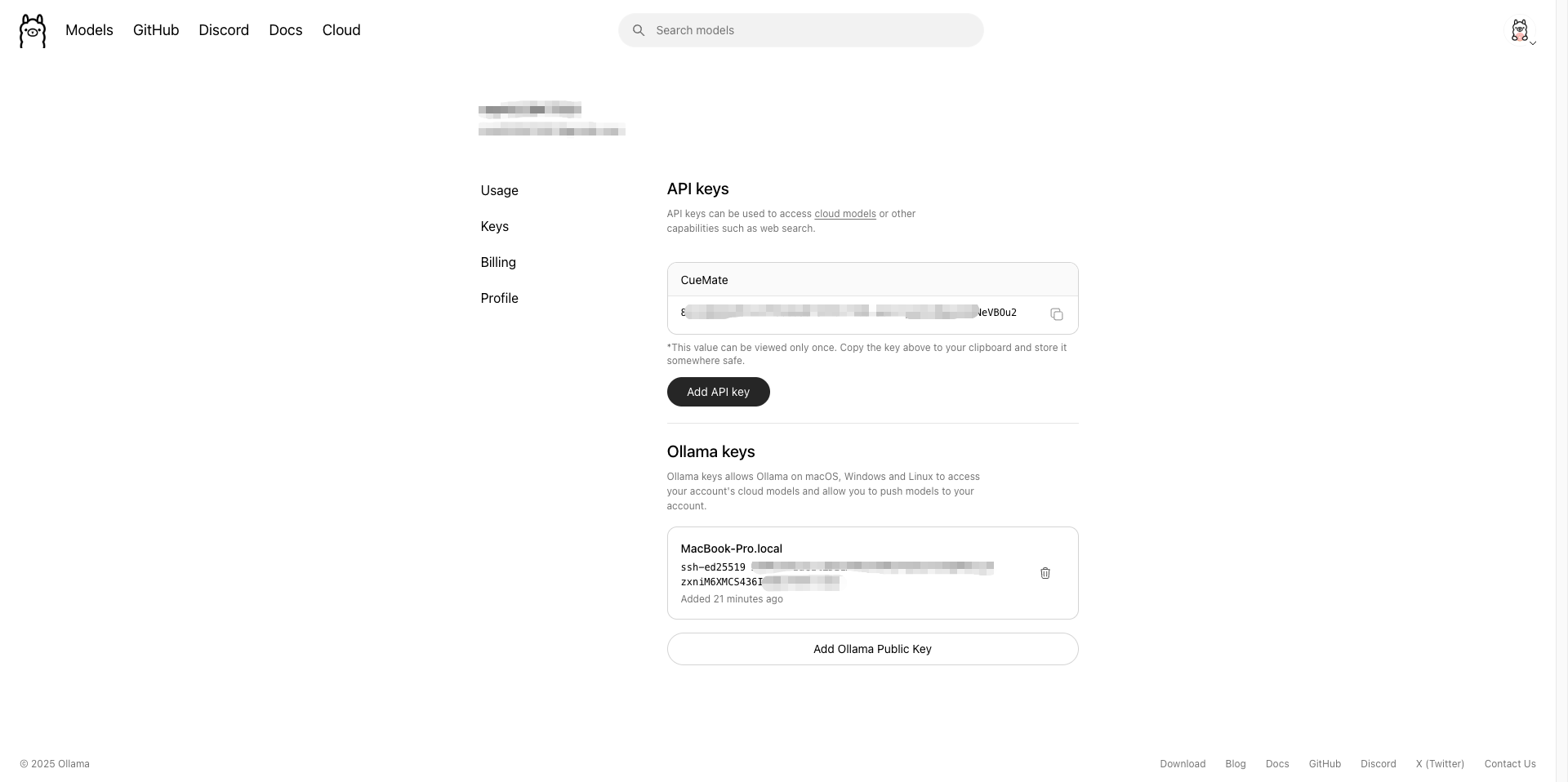

1.5.5 獲取 API Key(在 CueMate 中使用)

在 CueMate 中配置雲端模型時需要 API Key:

- 訪問 Ollama 官網設定頁面:https://ollama.com/settings/keys

- 點選 Create new key 建立新的 API Key

- 複製生成的 API Key 儲存備用

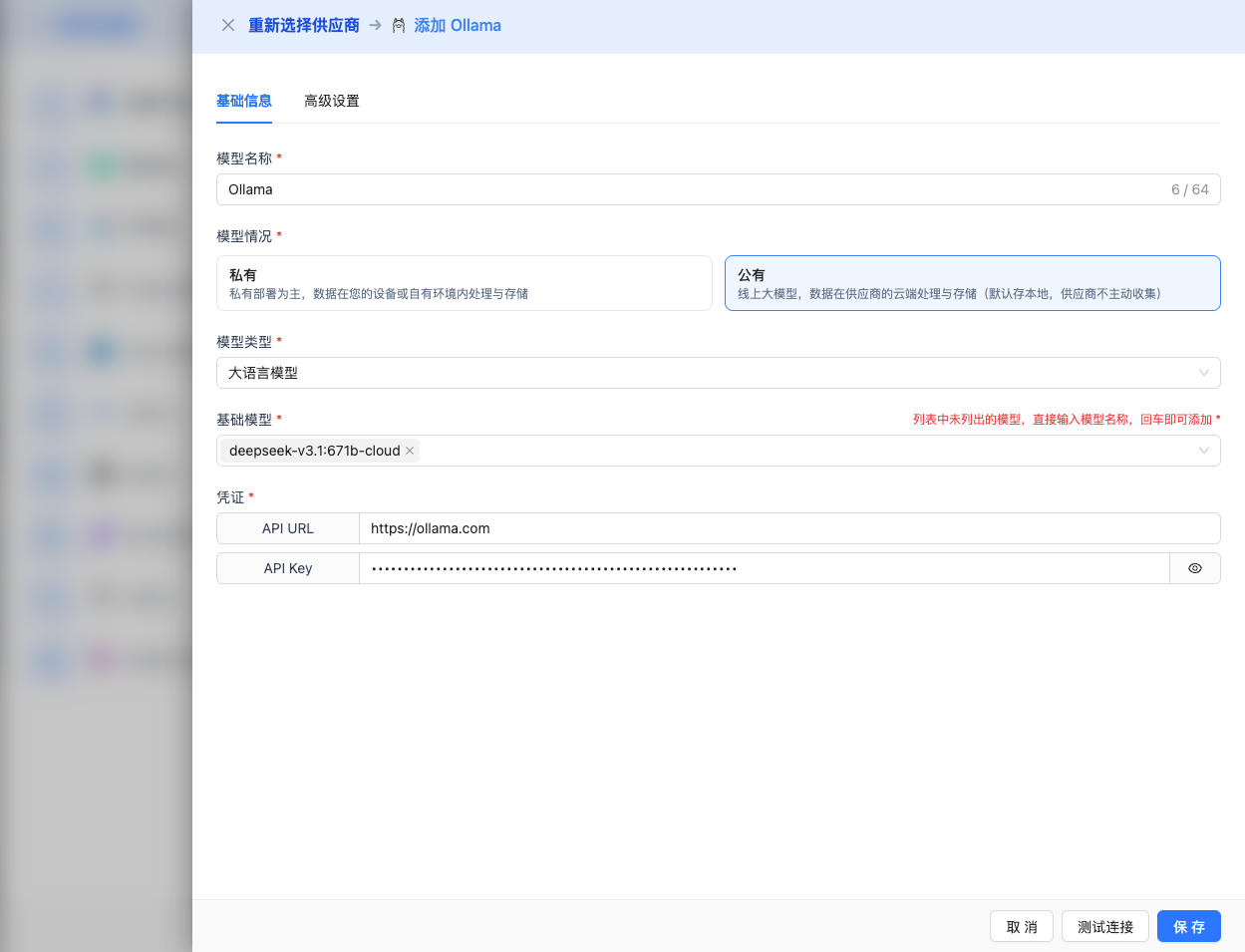

在 CueMate 中配置時填寫:

- 模型名稱:

你的使用者名稱/CueMate(雲端模型無需新增:cloud字尾) - API URL:

https://ollama.com - API Key:剛才建立的 API Key

1.6 本地模型配置(使用本地模型必做)

如果你選擇使用本地模型(如 gemma3:12b、deepseek-r1:8b),需要啟動本地 Ollama 服務:

- Ollama 安裝後會自動啟動服務,預設監聽

http://localhost:11434 - 驗證服務是否執行:bash

curl http://localhost:11434/api/version - 本地模型首次使用時會自動下載

2. 在 CueMate 中配置 Ollama 模型

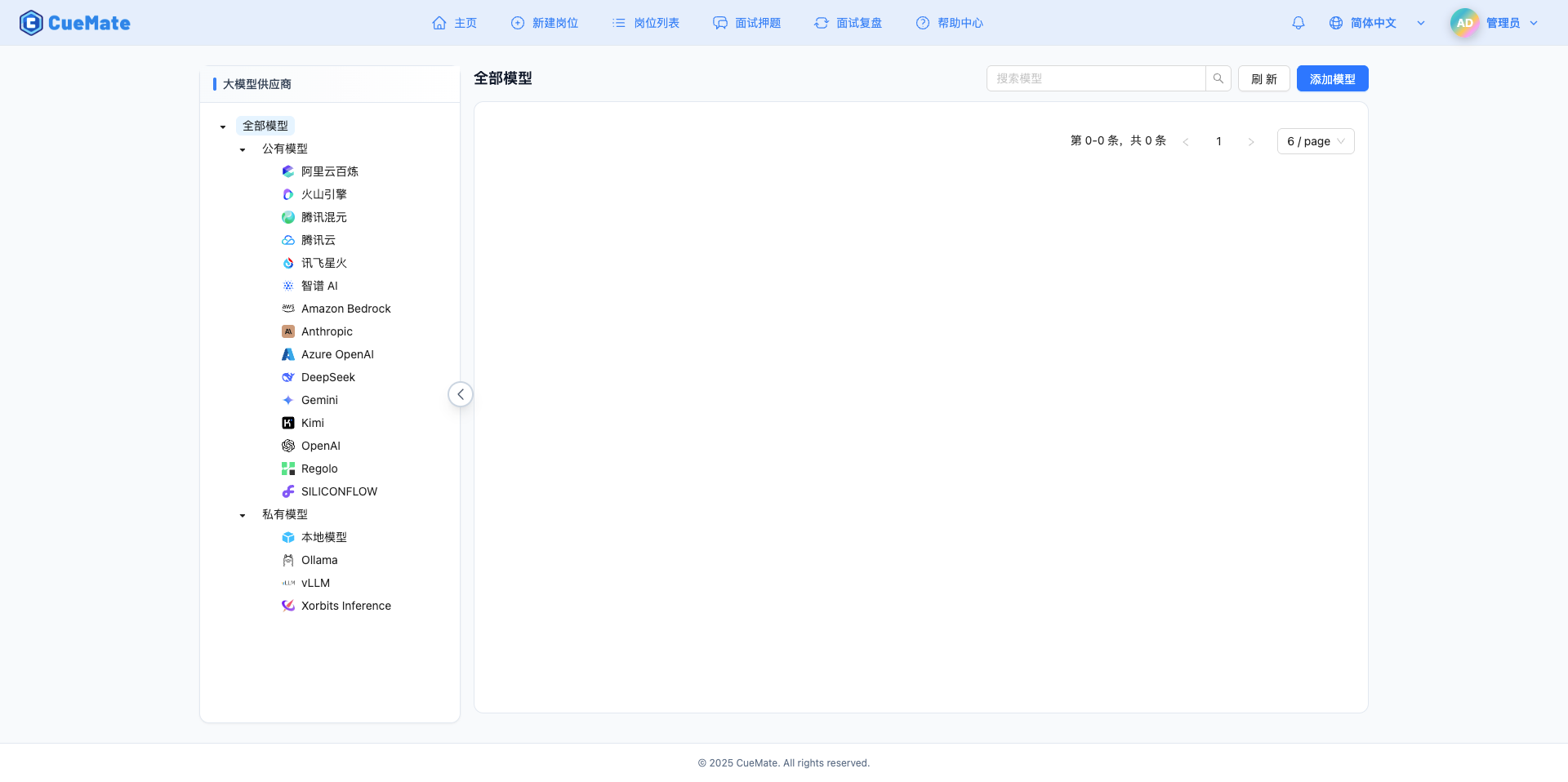

2.1 進入模型設定頁面

登入 CueMate 系統後,點選右上角下拉選單的 模型設定。

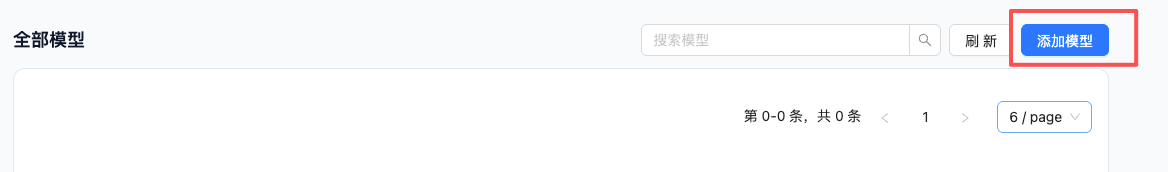

2.2 新增新模型

點選右上角的 新增模型 按鈕。

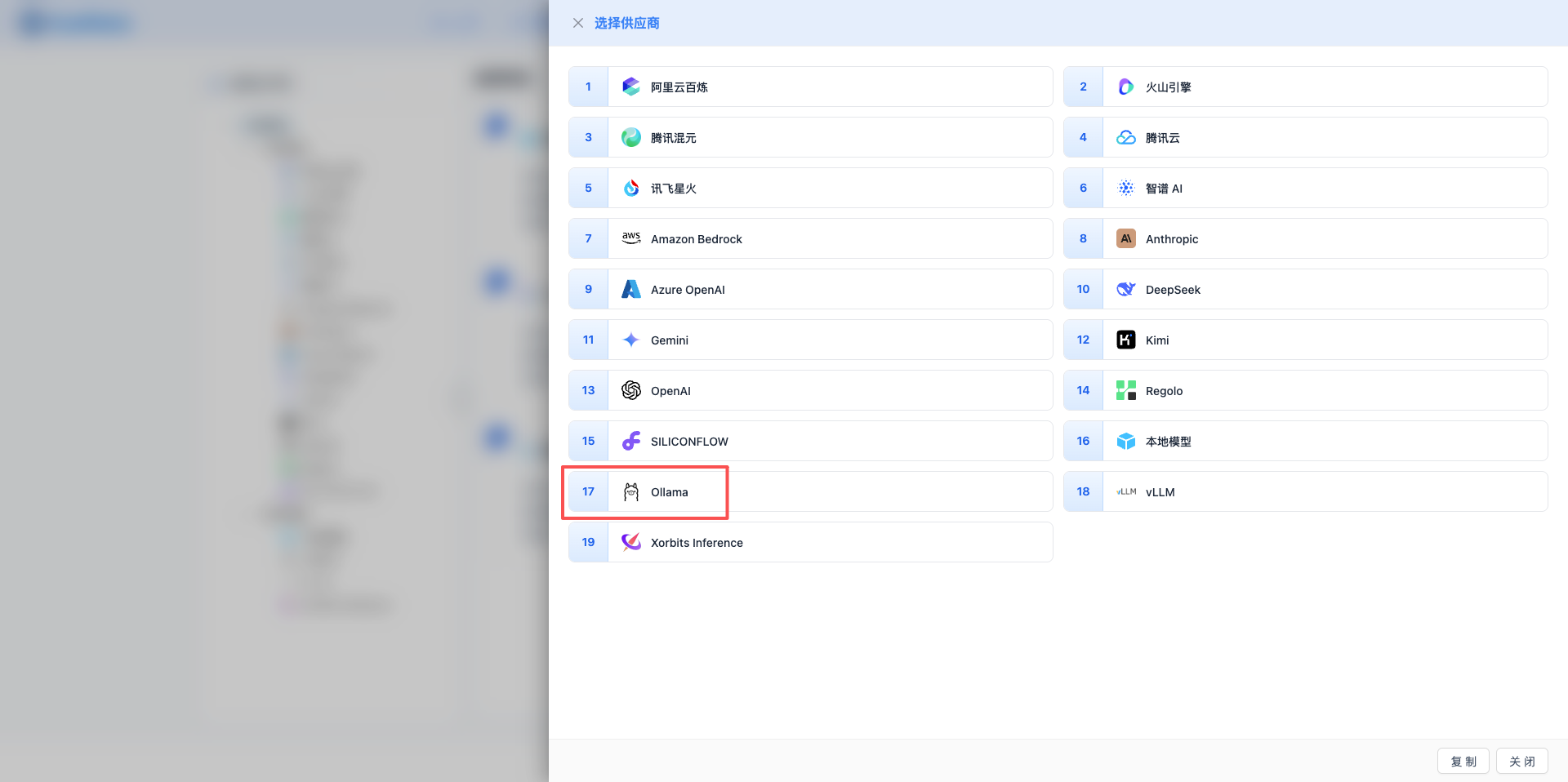

2.3 選擇 Ollama 服務商

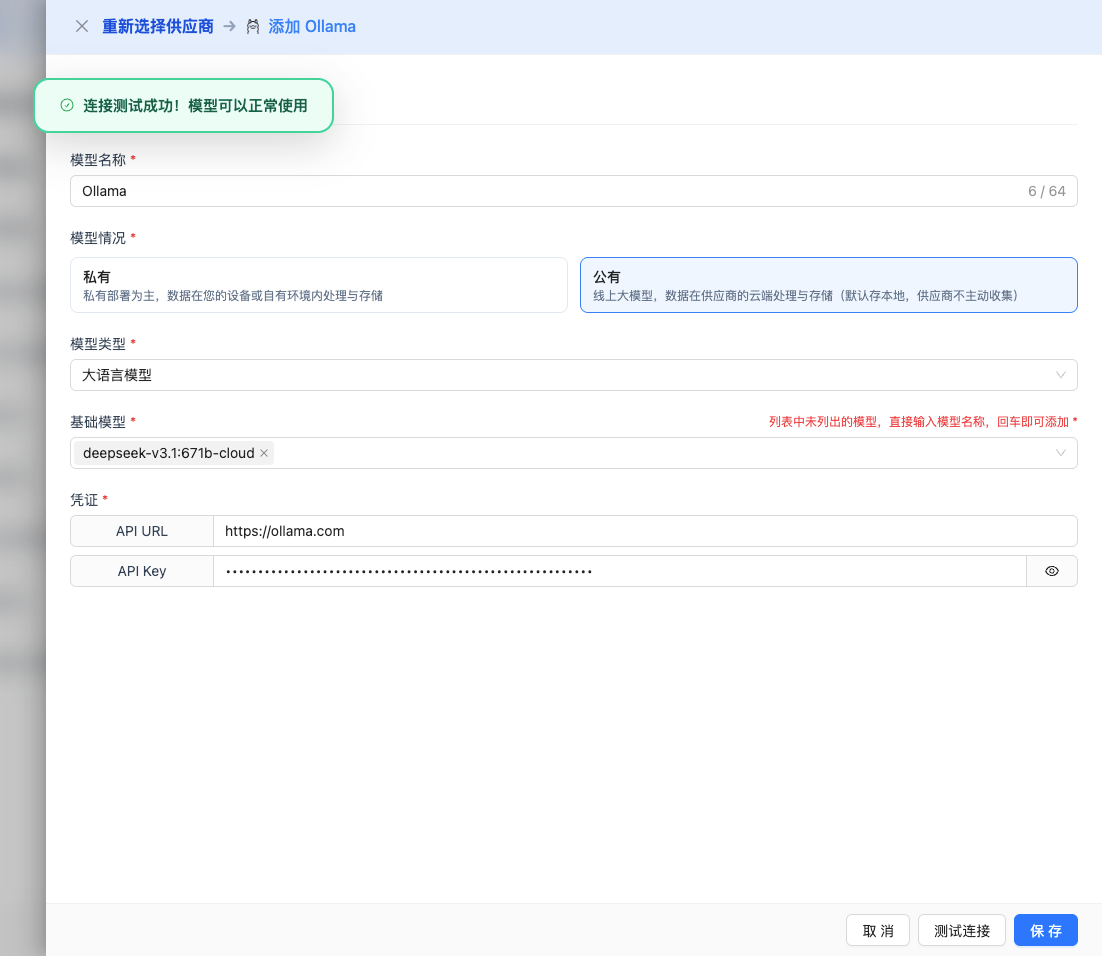

在彈出的對話方塊中:

- 服務商型別:選擇 Ollama

- 點選後 自動進入下一步

2.4 填寫配置資訊

在配置頁面填寫以下資訊:

基礎配置

- 模型名稱:為這個模型配置起個名字(例如:本地 DeepSeek R1)

- API URL:保持預設

http://localhost:11434(如果 Ollama 執行在其他地址,需修改) - 模型版本:輸入已下載的模型名稱

2025 推薦模型:

- 雲端模型:

deepseek-v3.1:671b-cloud、qwen3-coder:480b-cloud、qwen3-vl:235b-cloud、glm-4.6:cloud、minimax-m2:cloud - 本地模型:

gpt-oss:120b、gemma3:27b、gemma3:12b、deepseek-r1:8b、qwen3-coder:30b、qwen3-vl:30b、qwen3:30b、qwen3:8b

注意:本地模型首次使用時會自動下載,雲端模型無需下載。

高階配置(可選)

展開 高階配置 面板,可以調整以下引數:

CueMate 介面可調引數:

溫度(temperature):控制輸出隨機性

- 範圍:0-2

- 推薦值:0.7

- 作用:值越高輸出越隨機創新,值越低輸出越穩定保守

- 使用建議:

- 創意寫作/頭腦風暴:1.0-1.5

- 常規對話/問答:0.7-0.9

- 程式碼生成/精確任務:0.3-0.5

輸出最大 tokens(max_tokens):限制單次輸出長度

- 範圍:256 - 32768(根據模型而定)

- 推薦值:8192

- 作用:控制模型單次響應的最大字數

- 使用建議:

- 簡短問答:1024-2048

- 常規對話:4096-8192

- 長文生成:16384-32768

Ollama API 支援的其他高階引數:

雖然 CueMate 介面只提供 temperature 和 max_tokens 調整,但如果你透過 API 直接呼叫 Ollama,還可以使用以下高階引數(Ollama 採用 OpenAI 相容的 API 格式):

top_p(nucleus sampling)

- 範圍:0-1

- 預設值:1

- 作用:從機率累積達到 p 的最小候選集中取樣

- 與 temperature 的關係:通常只調整其中一個

- 使用建議:

- 保持多樣性但避免離譜:0.9-0.95

- 更保守的輸出:0.7-0.8

top_k

- 範圍:0-100

- 預設值:40

- 作用:從機率最高的 k 個候選詞中取樣

- 使用建議:

- 更多樣化:50-100

- 更保守:10-30

frequency_penalty(頻率懲罰)

- 範圍:-2.0 到 2.0

- 預設值:0

- 作用:降低重複相同詞彙的機率(基於詞頻)

- 使用建議:

- 減少重複:0.3-0.8

- 允許重複:0(預設)

presence_penalty(存在懲罰)

- 範圍:-2.0 到 2.0

- 預設值:0

- 作用:降低已出現過的詞彙再次出現的機率(基於是否出現)

- 使用建議:

- 鼓勵新話題:0.3-0.8

- 允許重複話題:0(預設)

stop(停止序列)

- 型別:字串或陣列

- 預設值:null

- 作用:當生成內容包含指定字串時停止

- 示例:

["###", "使用者:", "\n\n"] - 使用場景:

- 結構化輸出:使用分隔符控制格式

- 對話系統:防止模型代替使用者說話

stream(流式輸出)

- 型別:布林值

- 預設值:false

- 作用:啟用 SSE 流式返回,邊生成邊返回

- CueMate 中:自動處理,無需手動設定

seed(隨機種子)

- 型別:整數

- 預設值:null

- 作用:固定隨機種子,相同輸入產生相同輸出

- 使用場景:

- 可復現的測試

- 對比實驗

| 序號 | 場景 | temperature | max_tokens | top_p | top_k | frequency_penalty | presence_penalty |

|---|---|---|---|---|---|---|---|

| 1 | 創意寫作 | 1.0-1.2 | 4096-8192 | 0.95 | 50 | 0.5 | 0.5 |

| 2 | 程式碼生成 | 0.2-0.5 | 2048-4096 | 0.9 | 40 | 0.0 | 0.0 |

| 3 | 問答系統 | 0.7 | 1024-2048 | 0.9 | 40 | 0.0 | 0.0 |

| 4 | 摘要總結 | 0.3-0.5 | 512-1024 | 0.9 | 30 | 0.0 | 0.0 |

| 5 | 頭腦風暴 | 1.2-1.5 | 2048-4096 | 0.95 | 60 | 0.8 | 0.8 |

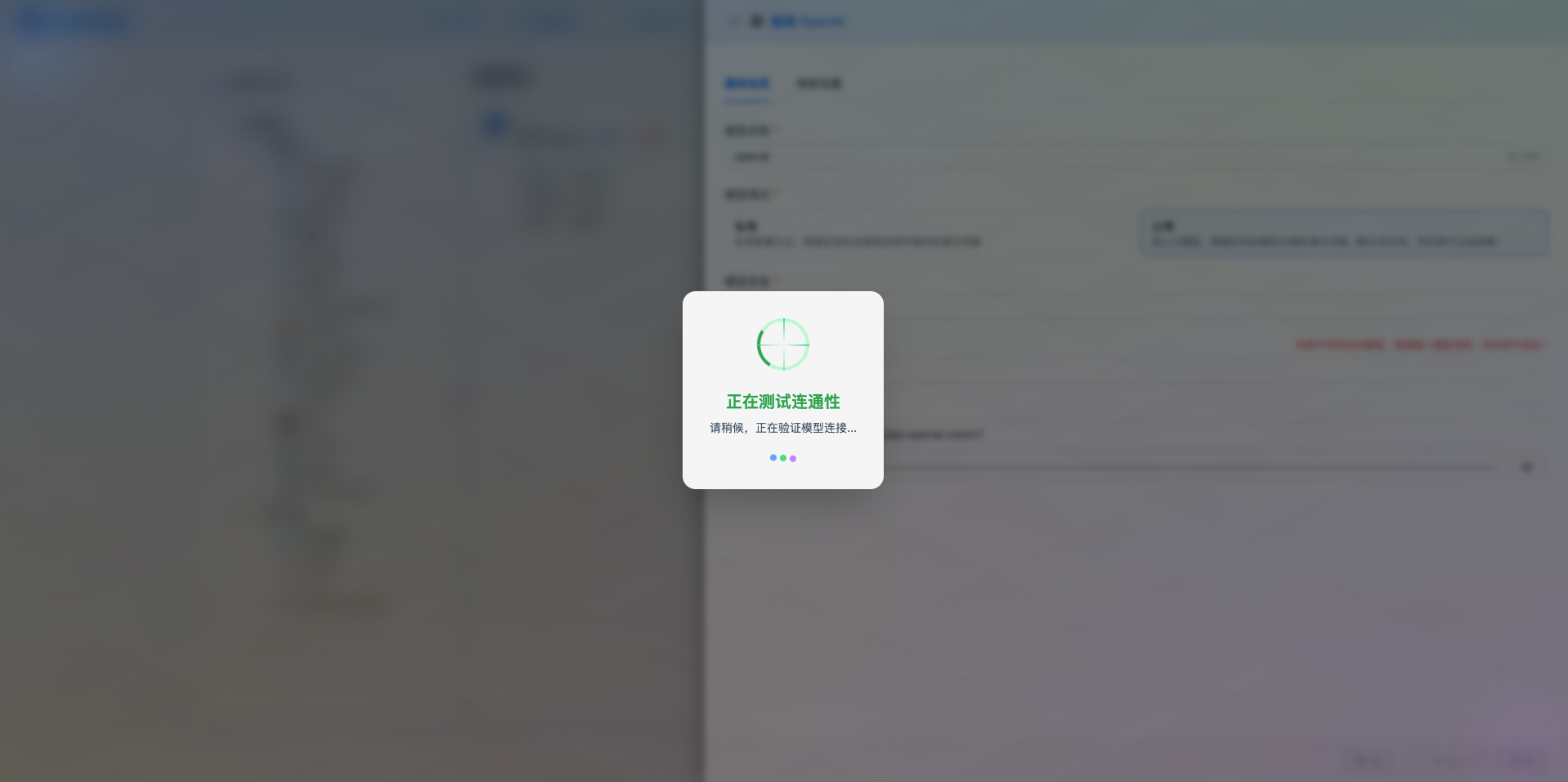

2.5 測試連線

填寫完配置後,點選 測試連線 按鈕,驗證配置是否正確。

如果配置正確,會顯示測試成功的提示,並返回模型的響應示例。

如果配置錯誤,會顯示測試錯誤的日誌,並且可以透過日誌管理,檢視具體報錯資訊。

2.6 儲存配置

測試成功後,點選 儲存 按鈕,完成模型配置。

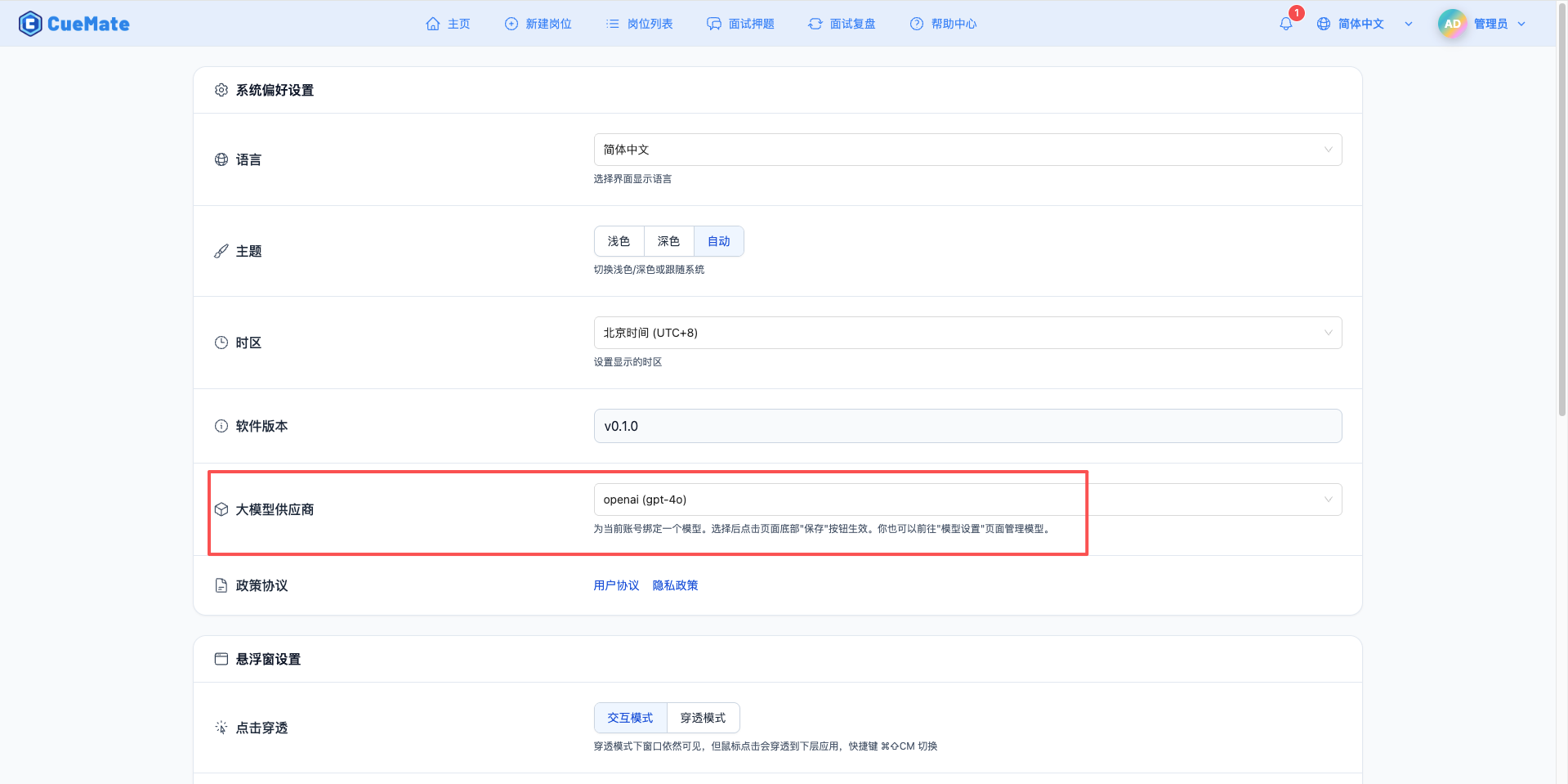

3. 使用模型

透過右上角下拉選單,進入系統設定介面,在大模型服務商欄目選擇想要使用的模型配置。

配置完成後,可以在面試訓練、問題生成等功能中選擇使用此模型, 當然也可以在面試的選項中單此選擇此次面試的模型配置。

4. 支援的模型列表

4.1 雲端模型(Cloud Models)

| 序號 | 模型名稱 | 模型 ID | 引數量 | 特點 |

|---|---|---|---|---|

| 1 | GPT-OSS 120B Cloud | gpt-oss:120b-cloud | 120B | 開源 GPT 雲端版 |

| 2 | GPT-OSS 20B Cloud | gpt-oss:20b-cloud | 20B | 開源 GPT 雲端版 |

| 3 | DeepSeek V3.1 | deepseek-v3.1:671b-cloud | 671B | 超大規模推理模型 |

| 4 | Qwen3 Coder | qwen3-coder:480b-cloud | 480B | 程式碼生成專用 |

| 5 | Qwen3 VL | qwen3-vl:235b-cloud | 235B | 視覺語言模型 |

| 6 | MiniMax M2 | minimax-m2:cloud | - | MiniMax 雲端模型 |

| 7 | GLM-4.6 | glm-4.6:cloud | - | 智譜 GLM 最新版 |

4.2 本地模型(Local Models)

GPT-OSS 系列

| 序號 | 模型名稱 | 模型 ID | 引數量 | 適用場景 |

|---|---|---|---|---|

| 1 | GPT-OSS 120B | gpt-oss:120b | 120B | 開源 GPT 超大模型 |

| 2 | GPT-OSS 20B | gpt-oss:20b | 20B | 開源 GPT 中型模型 |

Gemma 3 系列(Google)

| 序號 | 模型名稱 | 模型 ID | 引數量 | 適用場景 |

|---|---|---|---|---|

| 1 | Gemma3 27B | gemma3:27b | 27B | Google 最新旗艦模型 |

| 2 | Gemma3 12B | gemma3:12b | 12B | 中等規模任務 |

| 3 | Gemma3 4B | gemma3:4b | 4B | 輕量級任務 |

| 4 | Gemma3 1B | gemma3:1b | 1B | 超輕量級 |

DeepSeek R1 系列

| 序號 | 模型名稱 | 模型 ID | 引數量 | 適用場景 |

|---|---|---|---|---|

| 1 | DeepSeek R1 8B | deepseek-r1:8b | 8B | 推理增強 |

Qwen 3 系列

| 序號 | 模型名稱 | 模型 ID | 引數量 | 適用場景 |

|---|---|---|---|---|

| 1 | Qwen3 Coder 30B | qwen3-coder:30b | 30B | 程式碼生成 |

| 2 | Qwen3 VL 30B | qwen3-vl:30b | 30B | 視覺語言 |

| 3 | Qwen3 VL 8B | qwen3-vl:8b | 8B | 視覺語言 |

| 4 | Qwen3 VL 4B | qwen3-vl:4b | 4B | 視覺語言 |

| 5 | Qwen3 30B | qwen3:30b | 30B | 通用對話 |

| 6 | Qwen3 8B | qwen3:8b | 8B | 通用對話 |

| 7 | Qwen3 4B | qwen3:4b | 4B | 輕量級任務 |

5. 常見問題

5.1 Ollama 服務未啟動

現象:測試連線時提示連線失敗

解決方案:

- 確認 Ollama 服務是否執行:

ollama list - 重啟 Ollama 服務

- 檢查埠 11434 是否被佔用:

lsof -i :11434

5.2 模型未下載

現象:提示模型不存在

解決方案:

- 使用

ollama list檢視已下載的模型 - 使用

ollama pull <model-name>下載模型 - 確認模型名稱拼寫正確

5.3 效能問題

現象:模型響應速度慢

解決方案:

- 選擇引數量較小的模型(如 7B 而非 70B)

- 確保有足夠的 GPU 記憶體或系統記憶體

- 檢查系統資源使用情況

5.4 API URL 錯誤

現象:無法連線到 Ollama 服務

解決方案:

- 確認 API URL 配置正確(預設 http://localhost:11434)

- 如果 Ollama 執行在 Docker 中,使用容器的內部地址

- 檢查防火牆設定

5.5 模型選擇

- 開發測試:使用 7B-14B 引數的模型,響應快,資源消耗低

- 生產環境:根據效能需求選擇 14B-32B 引數的模型

- 資源受限:使用 0.5B-3B 引數的輕量級模型

5.6 硬體要求

| 模型引數 | 最小記憶體 | 推薦記憶體 | GPU |

|---|---|---|---|

| 0.5B-3B | 4GB | 8GB | 可選 |

| 7B-14B | 8GB | 16GB | 推薦 |

| 32B-70B | 32GB | 64GB | 必需 |