配置 Regolo

Regolo 是本地模型服务,整合了全球主流大模型服务商的 API 接口。提供统一的接入方式、灵活的计费模式和高可用性保障,简化多模型设置和切换。

1. 获取 Regolo API Key

1.1 访问 Regolo 平台

访问 Regolo AI 平台并注册登录:https://api.regolo.ai/

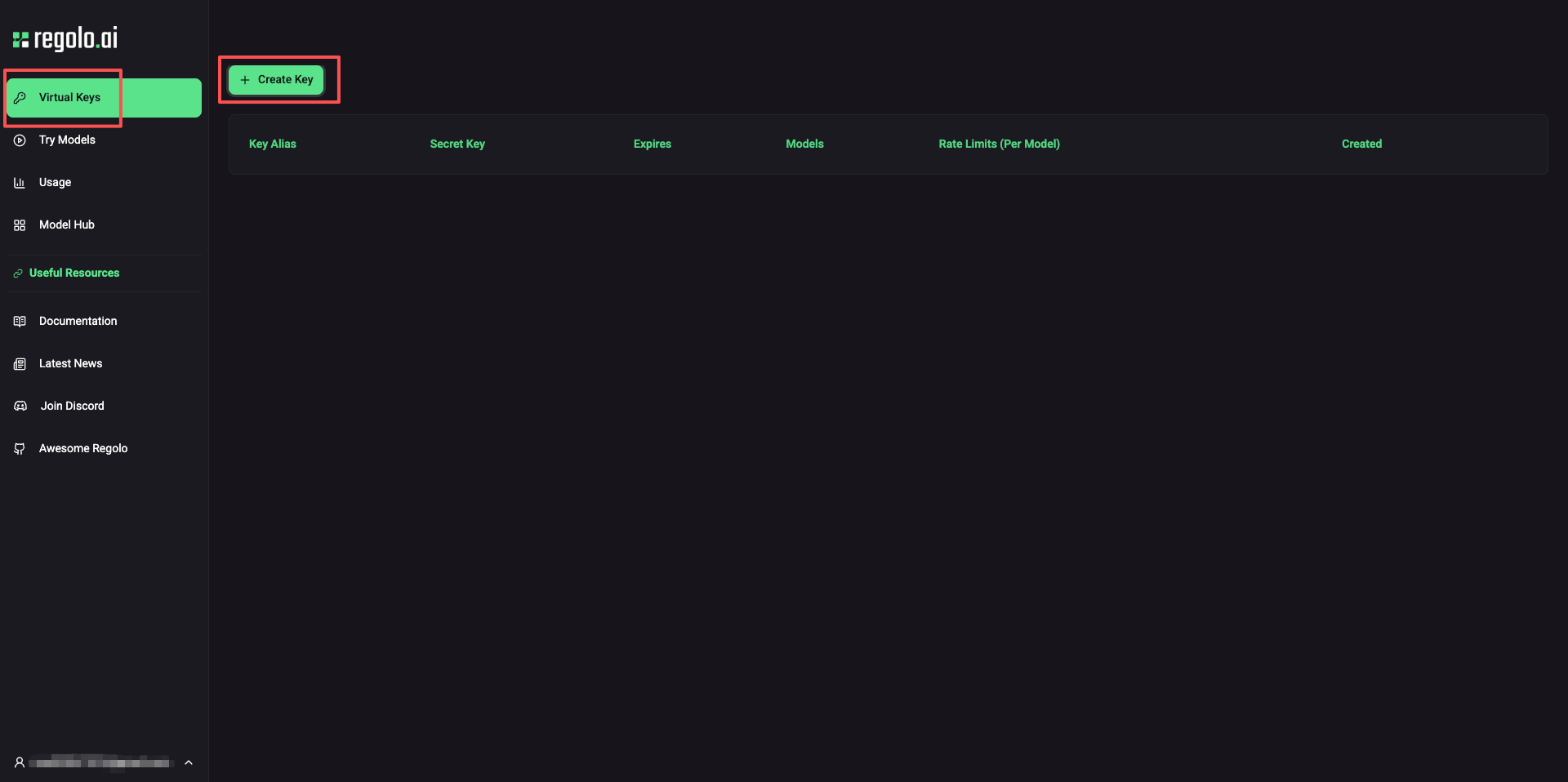

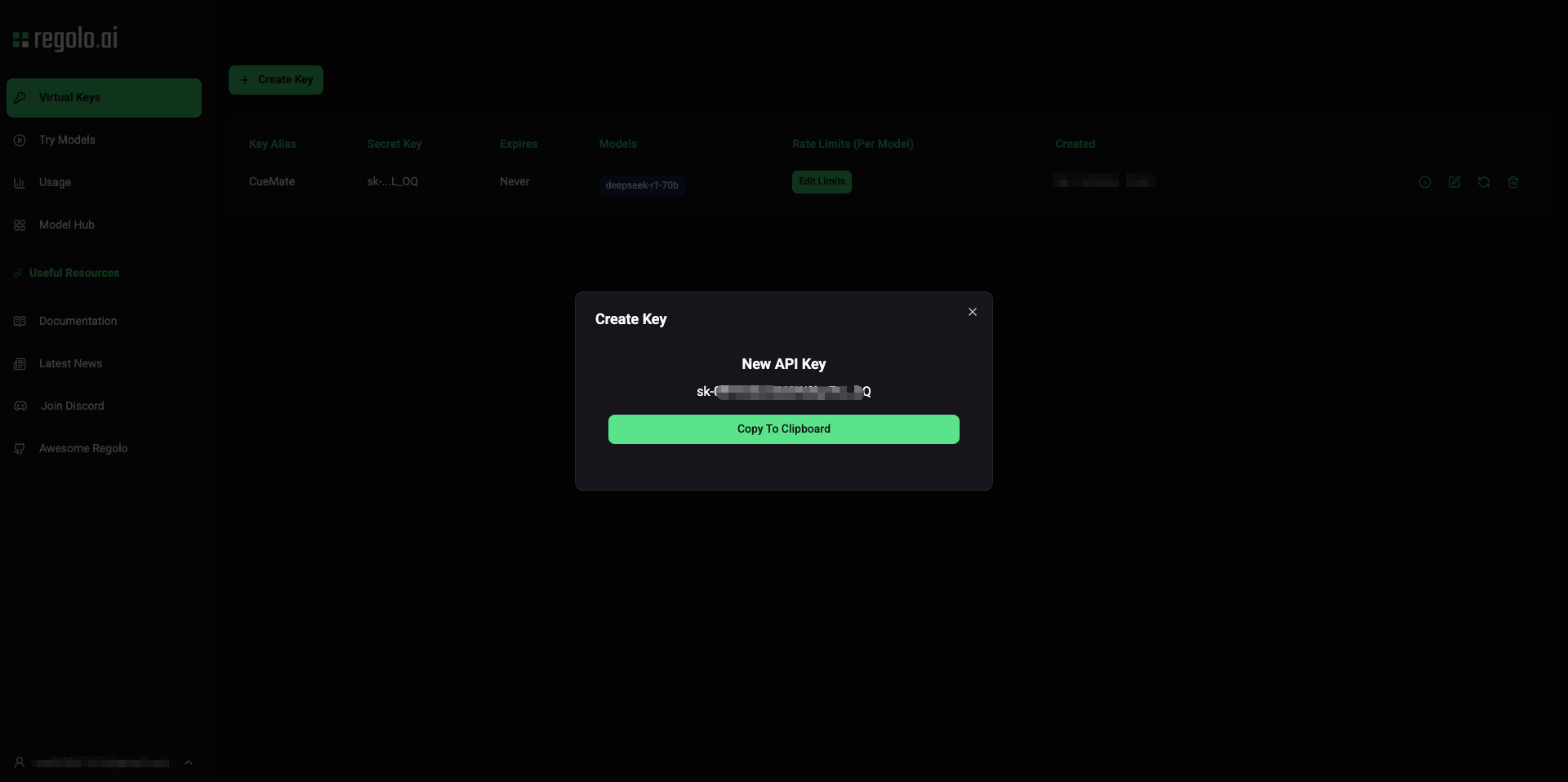

1.2 进入 Virtual Keys 管理页面

登录后,在左侧菜单栏点击 Virtual Keys 进入 API 密钥管理页面。

1.3 创建新的 API Key

点击右上角的 Create Key 按钮,打开创建对话框。

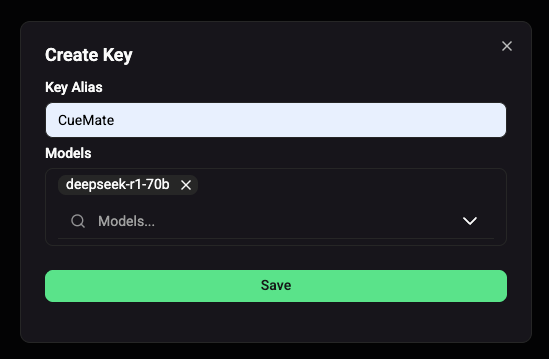

1.4 配置 API Key 信息

在 Create Key 对话框中配置以下信息:

1.4.1 设置 Key Alias(密钥别名)

输入一个便于识别的名称,例如 CueMate。

命名建议:

- 使用项目名称或用途作为前缀

- 区分开发/测试/生产环境(如

CueMate-Dev、CueMate-Prod) - 避免包含敏感信息

1.4.2 选择授权模型(Models)

点击 Models 下拉框,选择该 API Key 可以访问的模型:

可选模式:

- All models:授权访问所有模型(推荐用于生产环境)

- 指定模型:仅授权访问特定模型(推荐用于开发测试)

模型选择建议:

- 生产环境:选择 "All models" 以便灵活切换

- 开发环境:仅选择需要测试的模型,降低误用风险

- 按需授权:根据实际业务场景选择对应模型

当前可选的 LLM 模型:

deepseek-r1-70b:DeepSeek R1 推理模型(最大 64K tokens)llama-guard3-8b:Llama Guard 3 安全审核模型qwen3-30b:Qwen3 30B 通用模型(最大 32K tokens)qwen3-coder-30b:Qwen3 代码专用模型(最大 256K tokens)mistral-small3.2:Mistral Small 3.2 轻量模型(最大 32K tokens)gpt-oss-120b:开源 GPT 120B 大模型Llama-3.3-70B-Instruct:Llama 3.3 最新版本Llama-3.1-8B-Instruct:Llama 3.1 8B 高性价比maestrale-chat-v0.4-beta:Regolo 原创对话模型Qwen3-8B:Qwen3 8B 轻量模型(最大 32K tokens)gemma-3-27b-it:Google Gemma 3 27B(最大 128K tokens)

1.4.3 设置速率限制(Rate Limits)

点击 Edit Limits 按钮,可配置该 API Key 的请求速率限制:

- RPM(Requests Per Minute):每分钟请求数

- TPM(Tokens Per Minute):每分钟 token 数

- RPD(Requests Per Day):每天请求数

速率限制建议:

- 开发测试:RPM=60, TPM=100000, RPD=10000

- 生产环境:根据实际业务量设置,避免意外超额

1.4.4 完成创建

配置完成后,点击 Save 按钮。

1.5 保存 API Key

创建成功后,系统会显示 API Key。

重要提示:

- API Key 仅显示一次,关闭对话框后无法再次查看

- 请立即复制并保存到安全的位置(如密码管理器)

- 如果遗失,需要删除旧的 Key 并重新创建

保存方式推荐:

- 点击复制按钮,API Key 已复制到剪贴板

- 粘贴到密码管理器(如 1Password、Bitwarden)

- 或保存到安全的文本文件中,并妥善保管(不要分享给他人)

1.6 验证 API Key

在 Virtual Keys 列表中可以看到刚创建的 Key:

- 状态:显示 Key 是否启用

- 授权模型:显示可访问的模型列表

- 创建时间:记录创建日期

- 操作:可以编辑限制或删除 Key

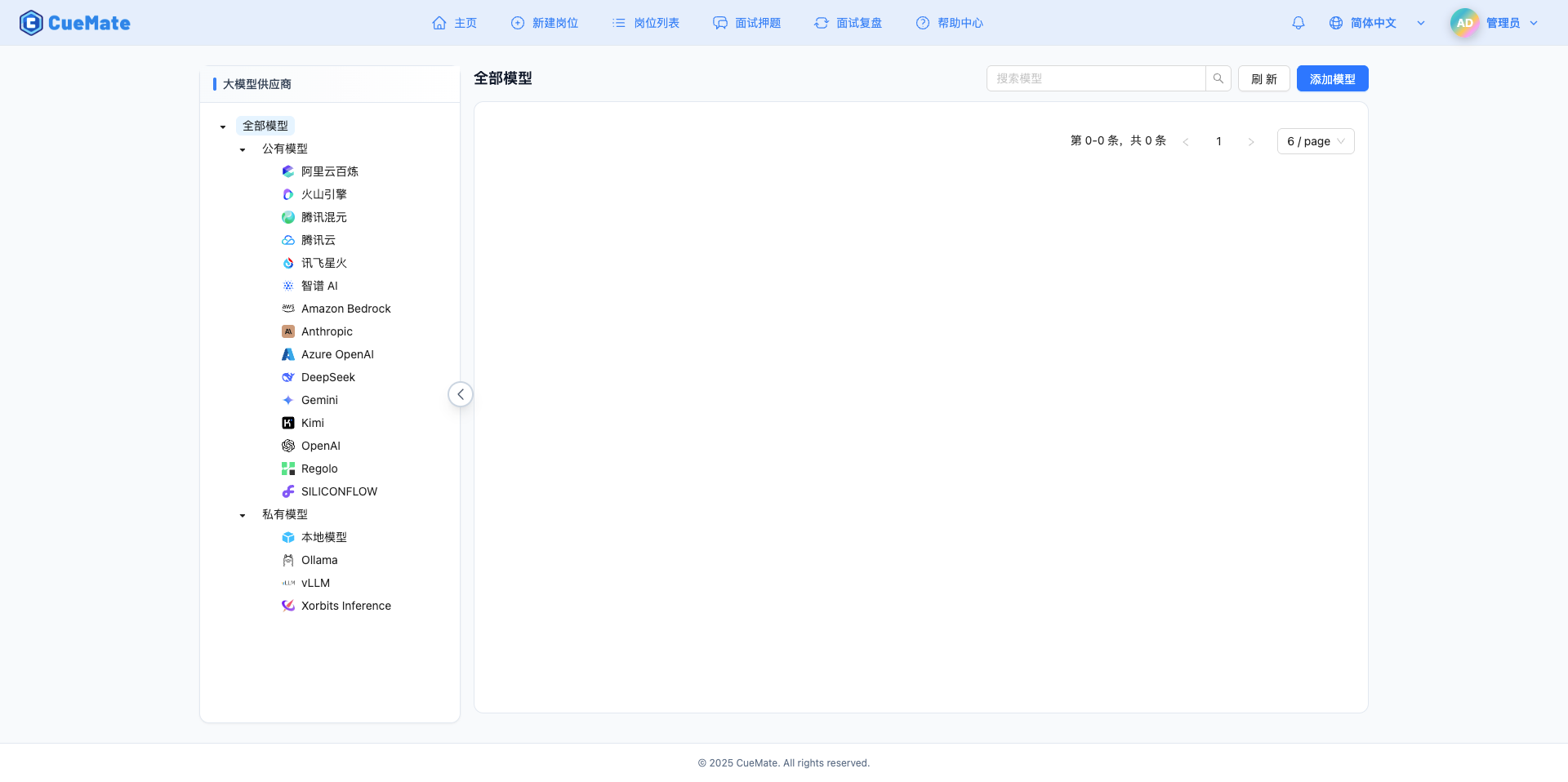

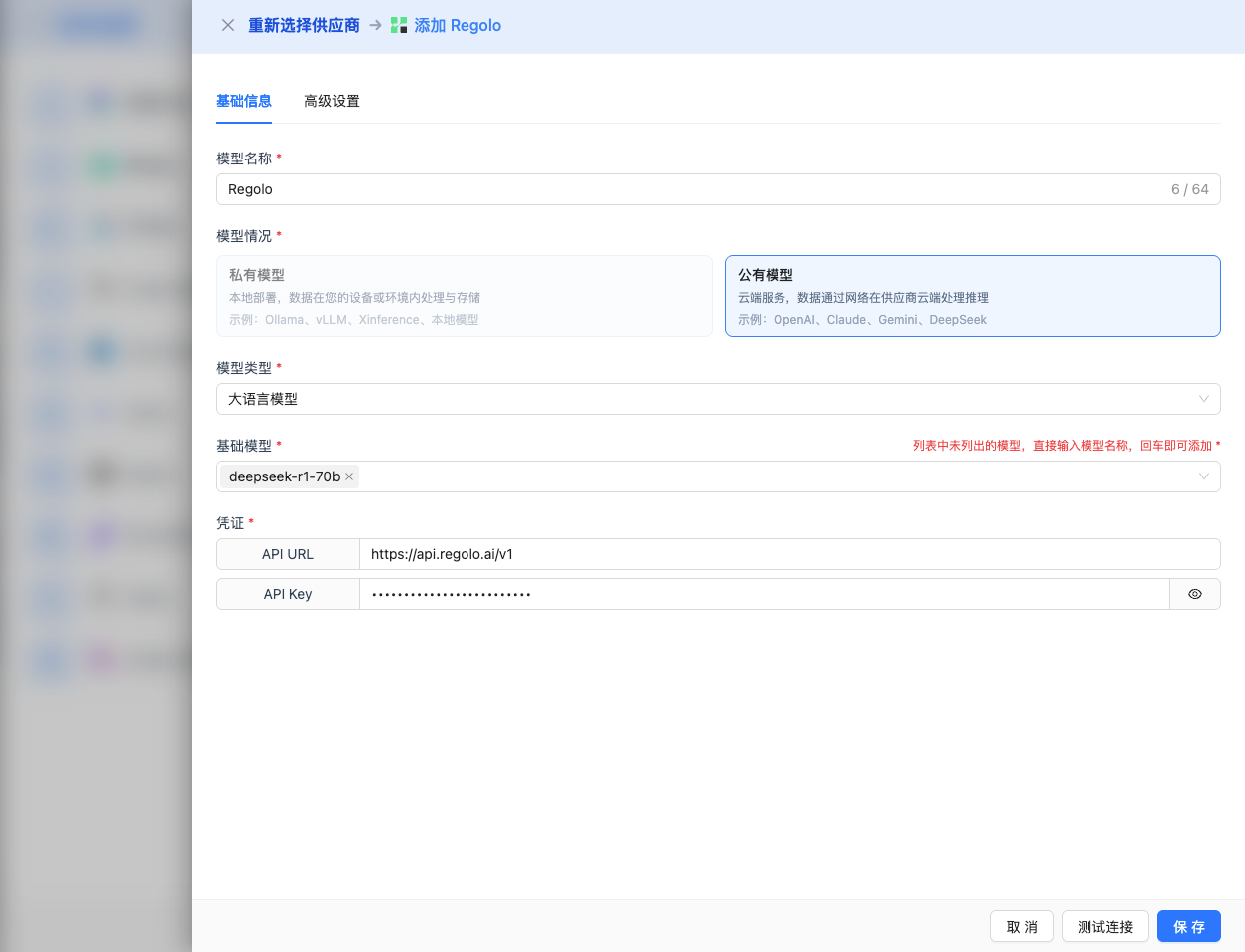

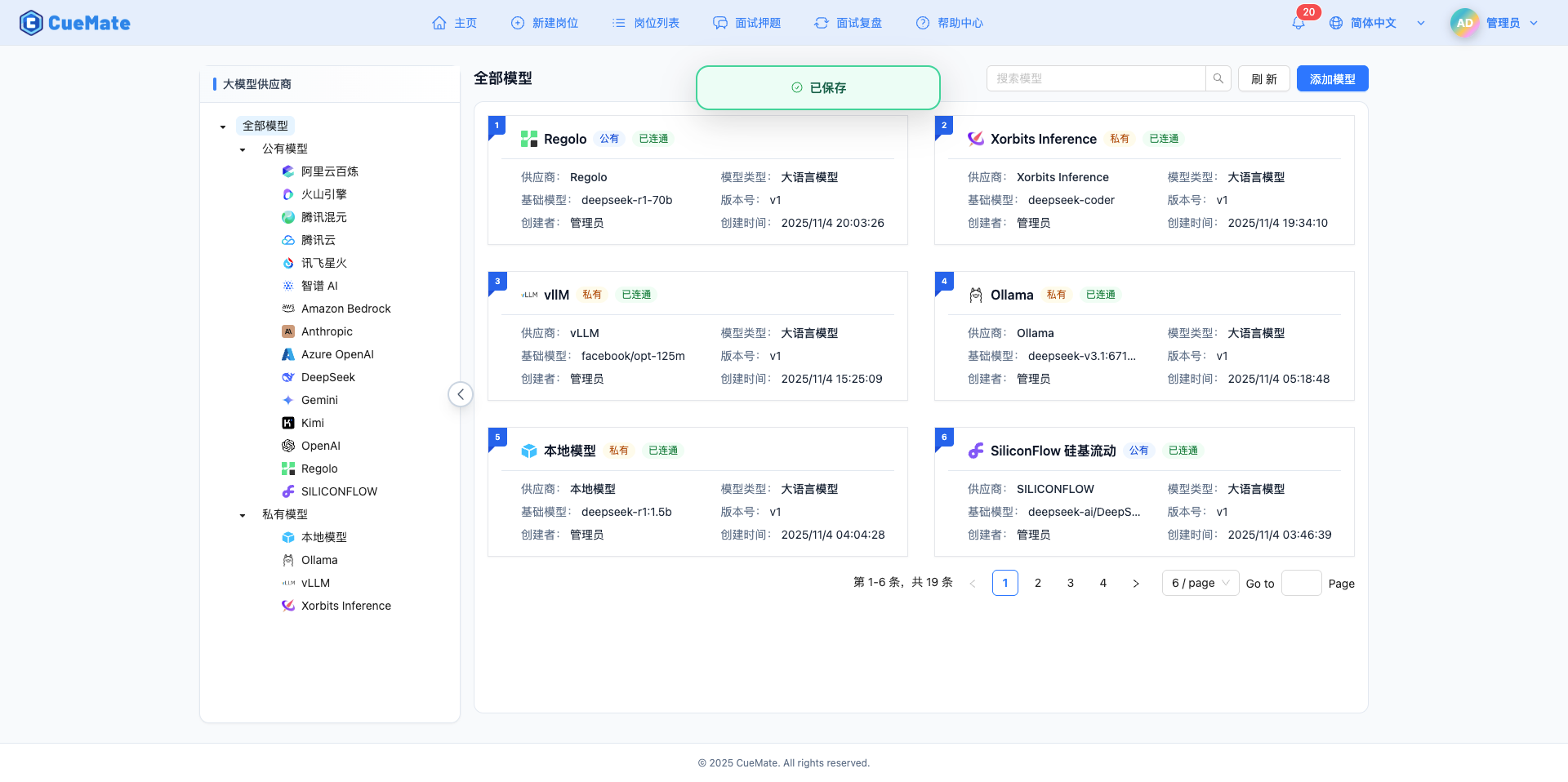

2. 在 CueMate 中配置 Regolo 模型

2.1 进入模型设置页面

登录 CueMate 系统后,点击右上角下拉菜单的 模型设置。

2.2 添加新模型

点击右上角的 添加模型 按钮。

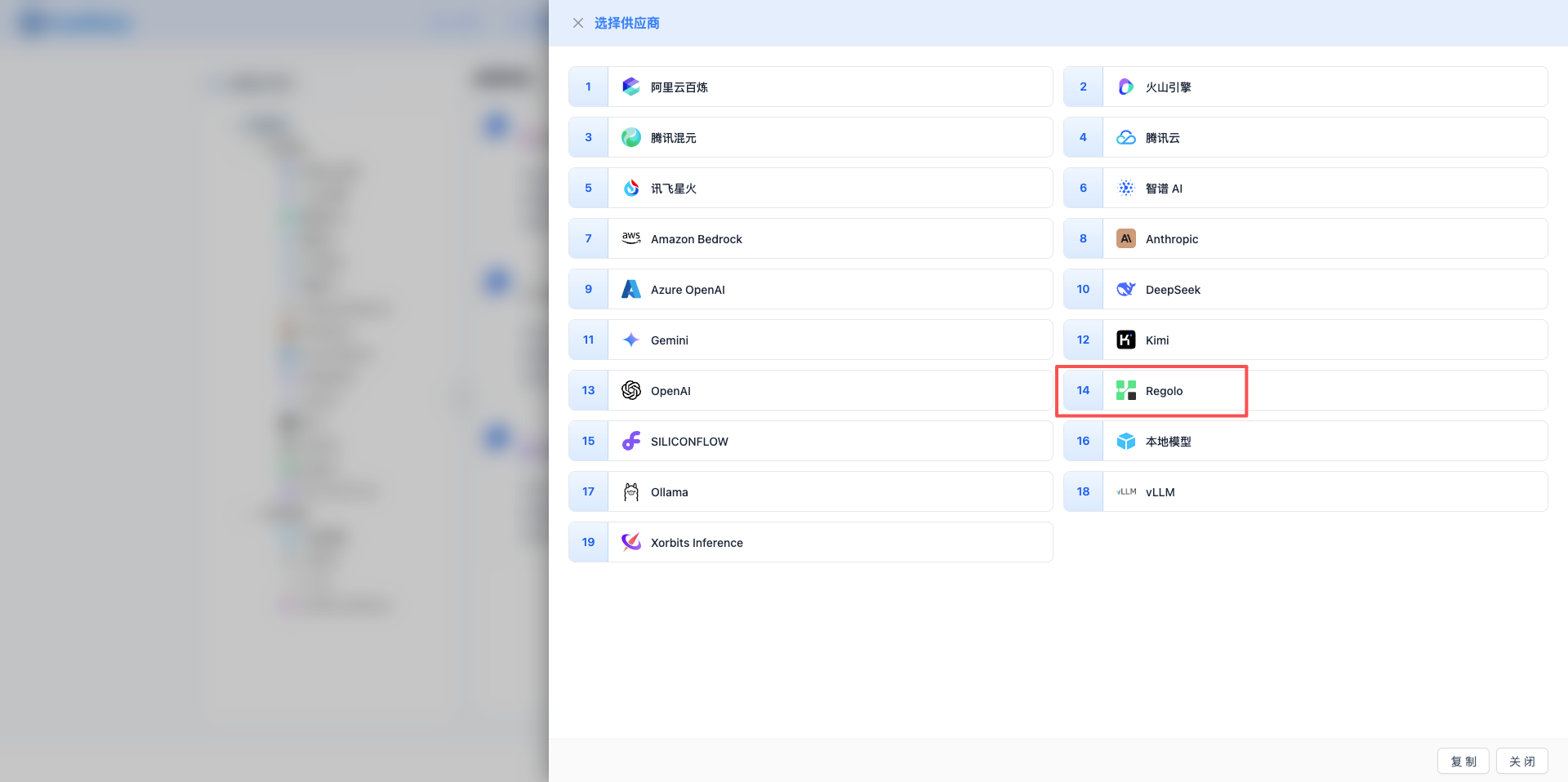

2.3 选择 Regolo 服务商

在弹出的对话框中:

- 服务商类型:选择 Regolo

- 点击后 自动进入下一步

2.4 填写配置信息

在配置页面填写以下信息:

基础配置

- 模型名称:为这个模型配置起个名字(例如:Regolo Phi-4)

- API URL:保持默认

https://api.regolo.ai/v1 - API Key:粘贴 Regolo 的 API Key

- 模型版本:选择或输入要使用的模型

- Microsoft 系列:

Phi-4:Microsoft Phi-4,轻量高效

- DeepSeek R1 系列:

DeepSeek-R1-Distill-Qwen-32B:DeepSeek R1 蒸馏版 32BDeepSeek-R1-Distill-Qwen-14B:DeepSeek R1 蒸馏版 14BDeepSeek-R1-Distill-Qwen-7B:DeepSeek R1 蒸馏版 7BDeepSeek-R1-Distill-Llama-8B:DeepSeek R1 Llama 8B

- Regolo 原创:

maestrale-chat-v0.4-beta:Maestrale 对话模型

- Llama 系列:

Llama-3.3-70B-Instruct:Llama 3.3 70B 指令版Llama-3.1-70B-Instruct:Llama 3.1 70B 指令版Llama-3.1-8B-Instruct:Llama 3.1 8B 指令版

- DeepSeek Coder:

DeepSeek-Coder-6.7B-Instruct:DeepSeek Coder 6.7B

- Qwen 系列:

Qwen2.5-72B-Instruct:Qwen 2.5 72B 指令版

- Microsoft 系列:

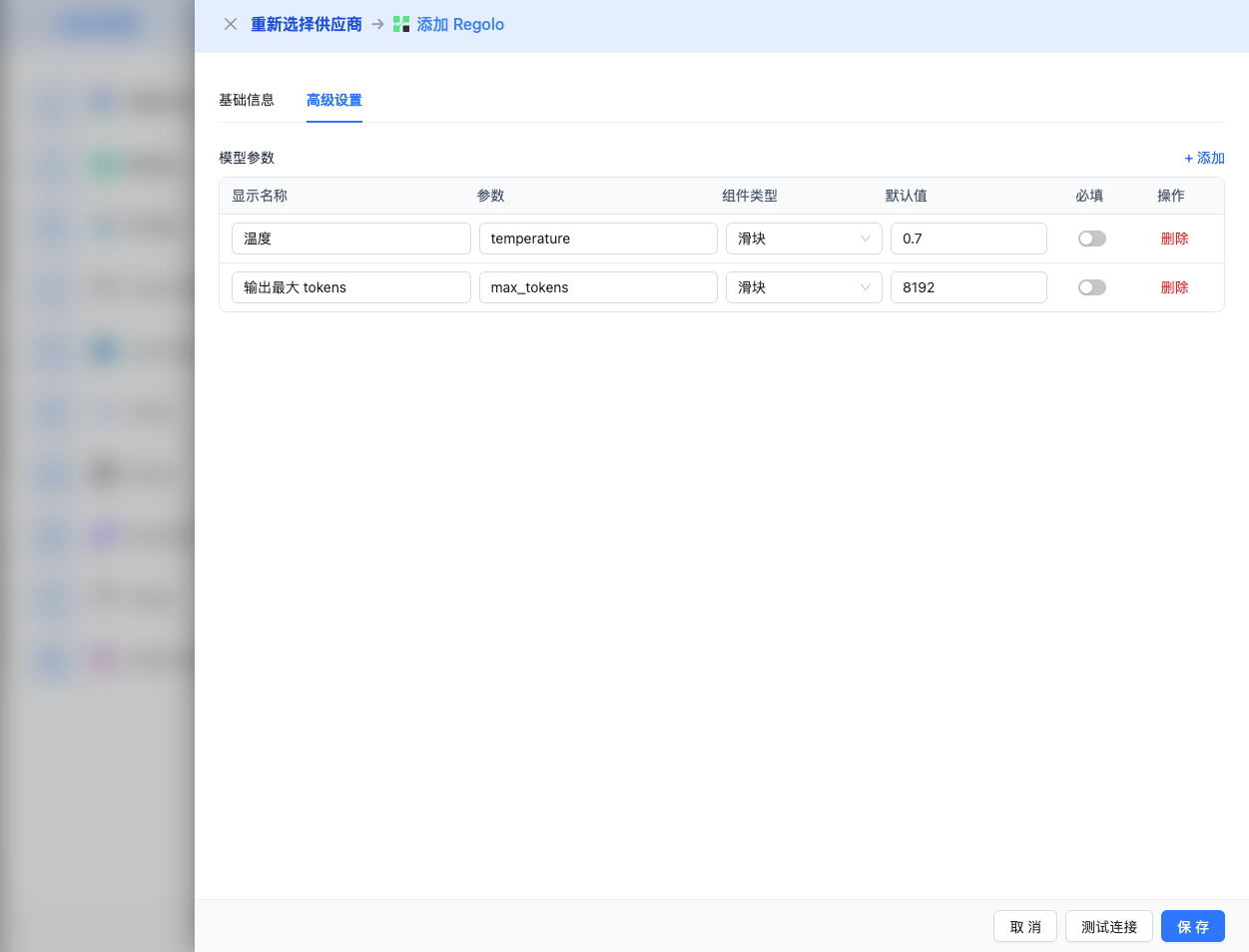

高级配置(可选)

展开 高级配置 面板,可以调整以下参数:

CueMate 界面可调参数:

温度(temperature):控制输出随机性

- 范围:0-2(不同模型上限不同)

- 推荐值:0.7

- 作用:值越高输出越随机创新,值越低输出越稳定保守

- 使用建议:

- 创意写作/头脑风暴:1.0-1.5

- 常规对话/问答:0.7-0.9

- 代码生成/精确任务:0.3-0.5

输出最大 tokens(max_tokens):限制单次输出长度

- 范围:256 - 262144(根据模型而定)

- 推荐值:8192

- 作用:控制模型单次响应的最大字数

- 模型限制:

- deepseek-r1-70b:最大 64K tokens

- gemma-3-27b-it:最大 128K tokens

- qwen3-coder-30b:最大 256K tokens

- 其他模型:8K-32K tokens

- 使用建议:

- 简短问答:1024-2048

- 常规对话:4096-8192

- 长文生成:16384-32768

- 超长文档:65536+(仅支持的模型)

Regolo API 支持的其他高级参数:

虽然 CueMate 界面只提供 temperature 和 max_tokens 调整,但如果你通过 API 直接调用 Regolo,还可以使用以下高级参数(Regolo 采用 OpenAI 兼容的 API 格式):

top_p(nucleus sampling)

- 范围:0-1

- 默认值:0.9

- 作用:从概率累积达到 p 的最小候选集中采样

- 与 temperature 的关系:通常只调整其中一个

- 使用建议:

- 保持多样性但避免离谱:0.9-0.95

- 更保守的输出:0.7-0.8

top_k

- 范围:1-100

- 默认值:50

- 作用:从概率最高的 k 个候选词中采样

- 使用建议:

- 更多样化:50-100

- 更保守:10-30

frequency_penalty

- 范围:-2.0 到 2.0

- 默认值:0

- 作用:降低重复相同词汇的概率(基于频率)

- 使用建议:

- 减少重复:0.3-0.8

- 允许重复:0(默认)

- 强制多样化:1.0-2.0

presence_penalty

- 范围:-2.0 到 2.0

- 默认值:0

- 作用:降低已出现过的词汇再次出现的概率(基于是否出现)

- 使用建议:

- 鼓励新话题:0.3-0.8

- 允许重复话题:0(默认)

stop(停止序列)

- 类型:字符串数组

- 默认值:null

- 作用:当生成内容包含指定字符串时停止

- 示例:

["###", "用户:", "\n\n"] - 使用场景:

- 结构化输出:使用分隔符控制格式

- 对话系统:防止模型代替用户说话

stream(流式输出)

- 类型:布尔值

- 默认值:false

- 作用:启用 SSE 流式返回,边生成边返回

- CueMate 中:自动处理,无需手动设置

seed(随机种子)

- 类型:整数

- 默认值:null

- 作用:固定随机种子,相同输入产生相同输出

- 使用场景:

- 可复现的测试

- 对比实验

- 注意:不是所有模型都支持

| 序号 | 场景 | temperature | max_tokens | top_p | frequency_penalty | presence_penalty |

|---|---|---|---|---|---|---|

| 1 | 创意写作 | 1.0-1.2 | 4096-8192 | 0.95 | 0.5 | 0.5 |

| 2 | 代码生成 | 0.2-0.5 | 2048-4096 | 0.9 | 0.0 | 0.0 |

| 3 | 问答系统 | 0.7 | 1024-2048 | 0.9 | 0.0 | 0.0 |

| 4 | 摘要总结 | 0.3-0.5 | 512-1024 | 0.9 | 0.0 | 0.0 |

| 5 | 头脑风暴 | 1.2-1.5 | 2048-4096 | 0.95 | 0.8 | 0.8 |

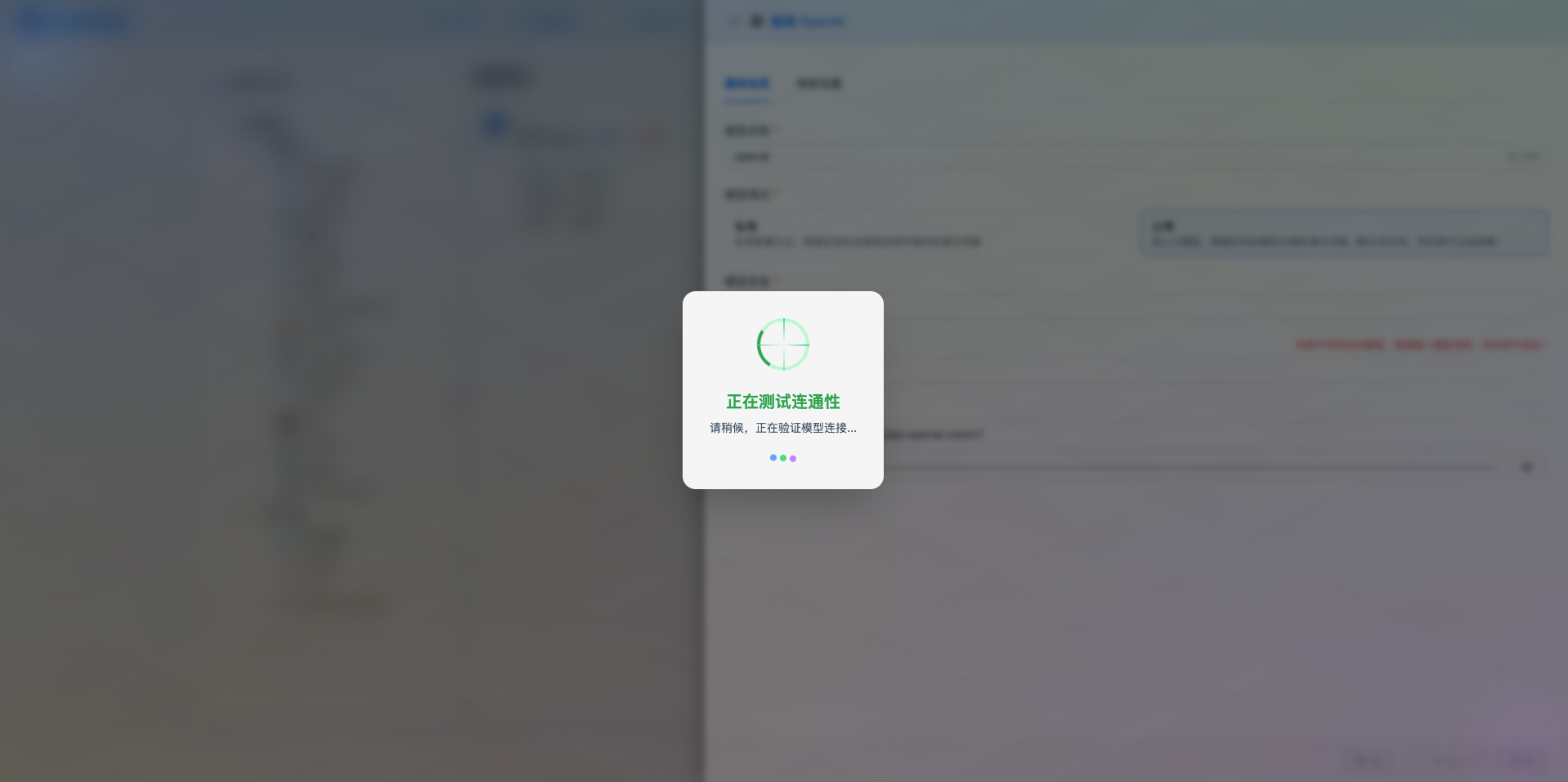

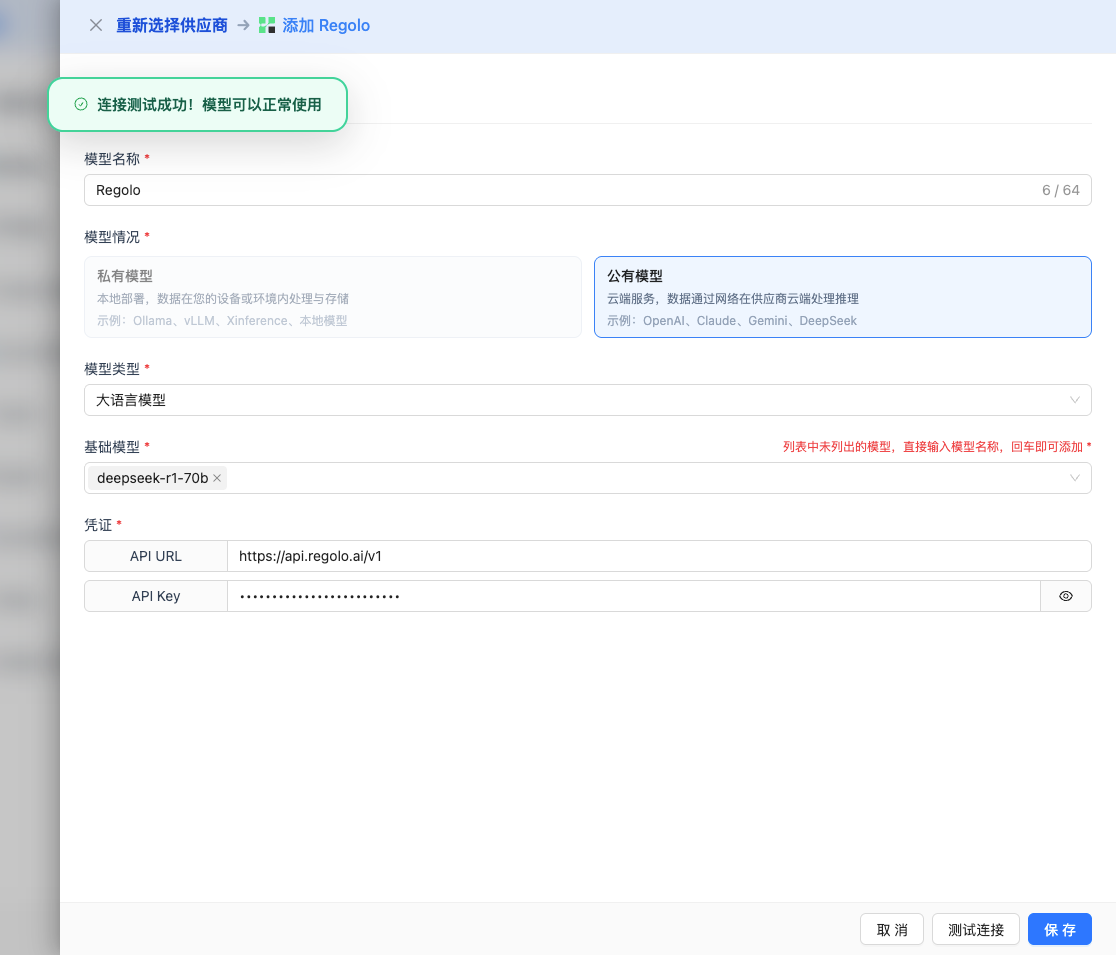

2.5 测试连接

填写完配置后,点击 测试连接 按钮,验证配置是否正确。

如果配置正确,会显示测试成功的提示,并返回模型的响应示例。

如果配置错误,会显示测试错误的日志,并且可以通过日志管理,查看具体报错信息。

2.6 保存配置

测试成功后,点击 保存 按钮,完成模型配置。

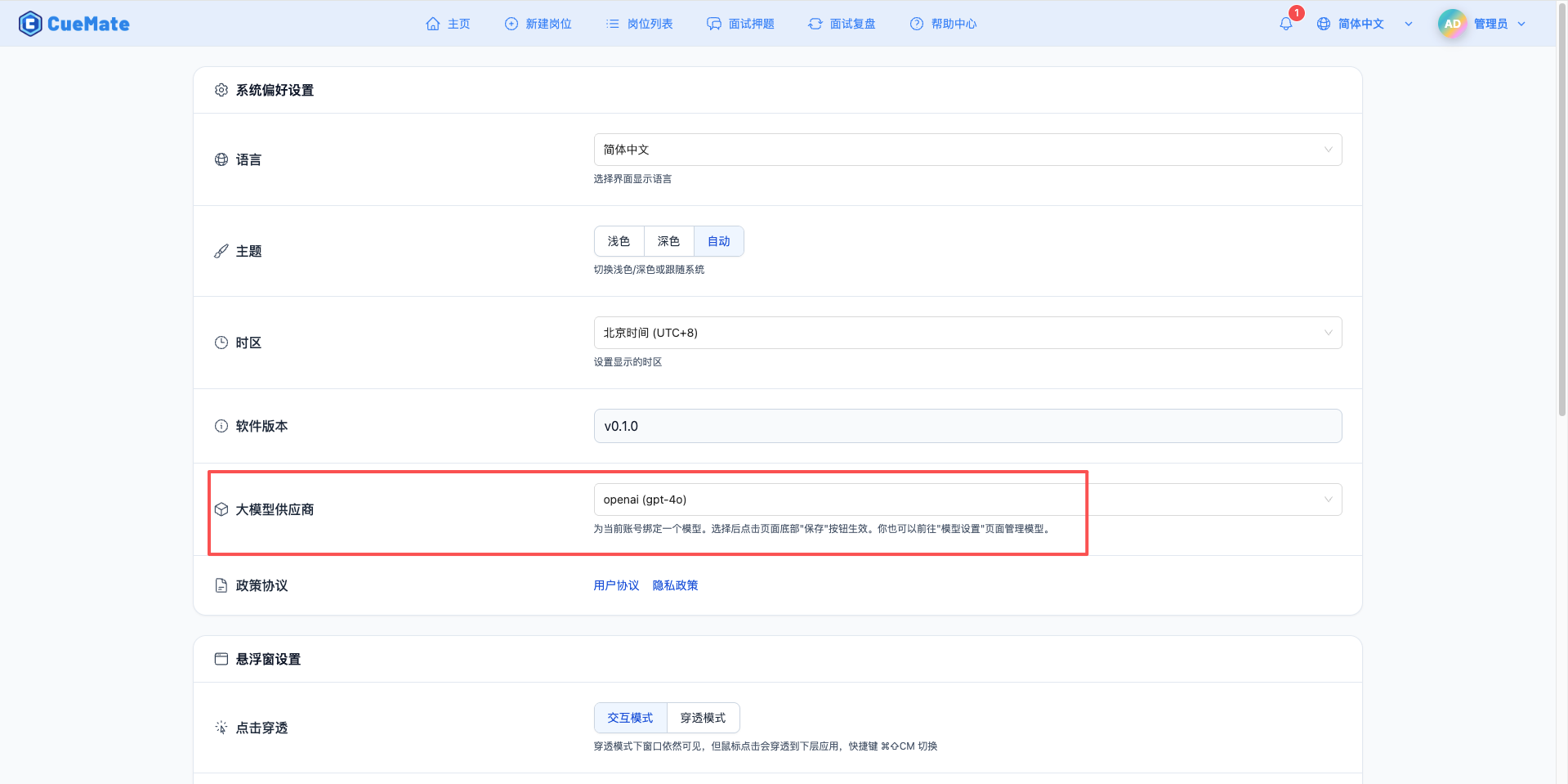

3. 使用模型

通过右上角下拉菜单,进入系统设置界面,在大模型服务商栏目选择想要使用的模型配置。

配置完成后,可以在面试训练、问题生成等功能中选择使用此模型, 当然也可以在面试的选项中单此选择此次面试的模型配置。

4. 支持的模型列表

4.1 DeepSeek 系列

| 序号 | 模型名称 | 模型 ID | 参数量 | 最大输出 | 适用场景 |

|---|---|---|---|---|---|

| 1 | DeepSeek R1 70B | deepseek-r1-70b | 70B | 64K tokens | 推理增强、复杂任务、超长上下文 |

4.2 Llama 系列

| 序号 | 模型名称 | 模型 ID | 参数量 | 最大输出 | 适用场景 |

|---|---|---|---|---|---|

| 1 | Llama Guard 3 8B | llama-guard3-8b | 8B | 8K tokens | 内容安全审核、风险检测 |

| 2 | Llama 3.3 70B | Llama-3.3-70B-Instruct | 70B | 8K tokens | 最新版本、高性能通用任务 |

| 3 | Llama 3.1 8B | Llama-3.1-8B-Instruct | 8B | 8K tokens | 标准任务、高性价比 |

4.3 Qwen 系列

| 序号 | 模型名称 | 模型 ID | 参数量 | 最大输出 | 适用场景 |

|---|---|---|---|---|---|

| 1 | Qwen3 30B | qwen3-30b | 30B | 32K tokens | 通用对话、长文本处理 |

| 2 | Qwen3 8B | Qwen3-8B | 8B | 32K tokens | 轻量高效、快速响应 |

| 3 | Qwen3 Coder 30B | qwen3-coder-30b | 30B | 256K tokens | 代码生成、超长代码上下文 |

4.4 Mistral 系列

| 序号 | 模型名称 | 模型 ID | 参数量 | 最大输出 | 适用场景 |

|---|---|---|---|---|---|

| 1 | Mistral Small 3.2 | mistral-small3.2 | - | 32K tokens | 轻量模型、多语言支持 |

4.5 Google Gemma 系列

| 序号 | 模型名称 | 模型 ID | 参数量 | 最大输出 | 适用场景 |

|---|---|---|---|---|---|

| 1 | Gemma 3 27B | gemma-3-27b-it | 27B | 128K tokens | 超长上下文、文档分析 |

4.6 开源社区模型

| 序号 | 模型名称 | 模型 ID | 参数量 | 最大输出 | 适用场景 |

|---|---|---|---|---|---|

| 1 | GPT OSS 120B | gpt-oss-120b | 120B | 8K tokens | 开源超大模型、实验性任务 |

4.7 Regolo 原创

| 序号 | 模型名称 | 模型 ID | 参数量 | 最大输出 | 适用场景 |

|---|---|---|---|---|---|

| 1 | Maestrale Chat v0.4 | maestrale-chat-v0.4-beta | - | 8K tokens | 对话优化、多语言(意大利语增强) |

5. 常见问题

5.1 API Key 无效

现象:测试连接时提示 API Key 错误

解决方案:

- 检查 API Key 是否完整复制

- 确认 API Key 未过期或被禁用

- 验证 API Key 权限设置正确

5.2 模型不可用

现象:提示模型不存在或未授权

解决方案:

- 确认模型 ID 拼写正确

- 检查账户是否有该模型的访问权限

- 验证账户余额充足

5.3 请求超时

现象:测试连接或使用时长时间无响应

解决方案:

- 检查网络连接是否正常

- 确认 API URL 配置正确

- 检查防火墙设置

5.4 配额限制

现象:提示超出请求配额

解决方案:

- 登录 Regolo 平台查看配额使用情况

- 充值或申请更多配额

- 优化使用频率

5.5 企业级服务

- 高可用性保障

- 专业技术支持

- 灵活的定价方案

5.6 模型丰富

- 支持多种主流开源模型

- Regolo 原创优化模型

- 持续更新最新模型

5.7 性能优化

- 分布式推理集群

- 低延迟响应

- 高并发支持

5.8 数据安全

- 数据加密传输

- 隐私保护机制

- 合规认证

Regolo 采用按使用量计费模式:

| 模型级别 | 输入价格 | 输出价格 | 单位 |

|---|---|---|---|

| 轻量级(<10B) | ¥0.001 | ¥0.003 | /1K tokens |

| 标准级(10B-30B) | ¥0.003 | ¥0.009 | /1K tokens |

| 高性能(>30B) | ¥0.006 | ¥0.018 | /1K tokens |

注意:具体价格以 Regolo 官网为准。

5.9 模型选择

- 开发测试:使用 7B-14B 参数的模型,成本低

- 生产环境:根据性能需求选择 32B-70B 模型

- 代码生成:优先选择 DeepSeek Coder 系列

- 通用对话:推荐 Llama 3.3 或 Qwen 2.5 系列

5.10 成本优化

- 合理设置

max_tokens参数 - 使用缓存减少重复请求

- 选择合适参数量的模型

- 监控 API 使用量

相关链接

5.1 企业应用

- 内部知识库问答

- 客户服务自动化

- 文档生成与处理

5.2 开发者

- 应用原型开发

- AI 功能集成

- 算法验证测试

5.3 私有化需求

- 支持私有化部署方案

- 定制化模型训练

- 专属技术支持