配置 Amazon Bedrock

Amazon Bedrock 是 AWS 提供的全托管基础模型服务,集成了 Anthropic Claude、Meta Llama、Amazon Titan 等多家顶级模型。提供企业级安全、隐私保护和灵活的模型选择,支持按需付费。

1. 获取 AWS Bedrock 访问权限

1.1 访问 AWS 控制台

访问 AWS Management Console 并登录:https://console.aws.amazon.com/

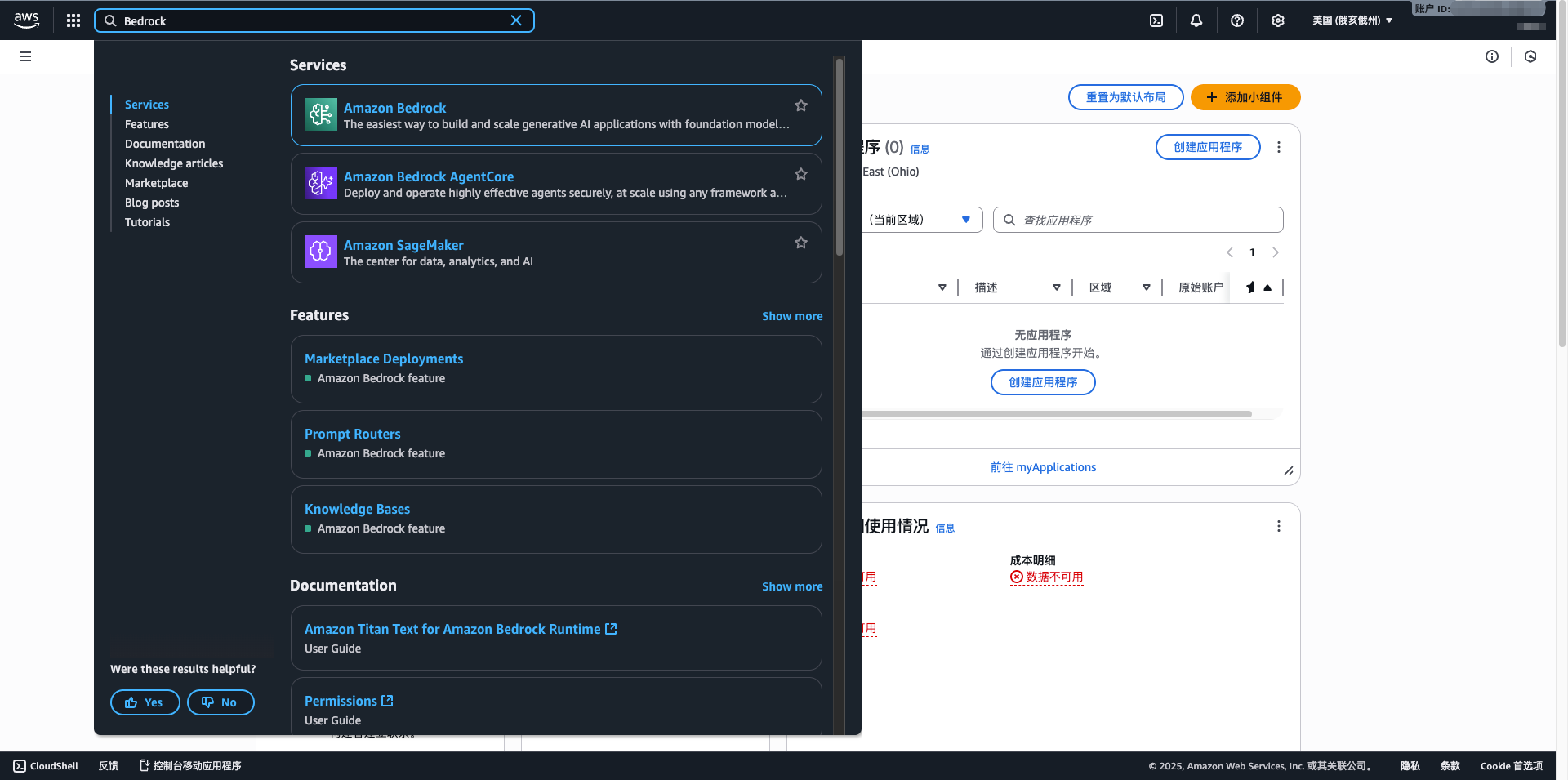

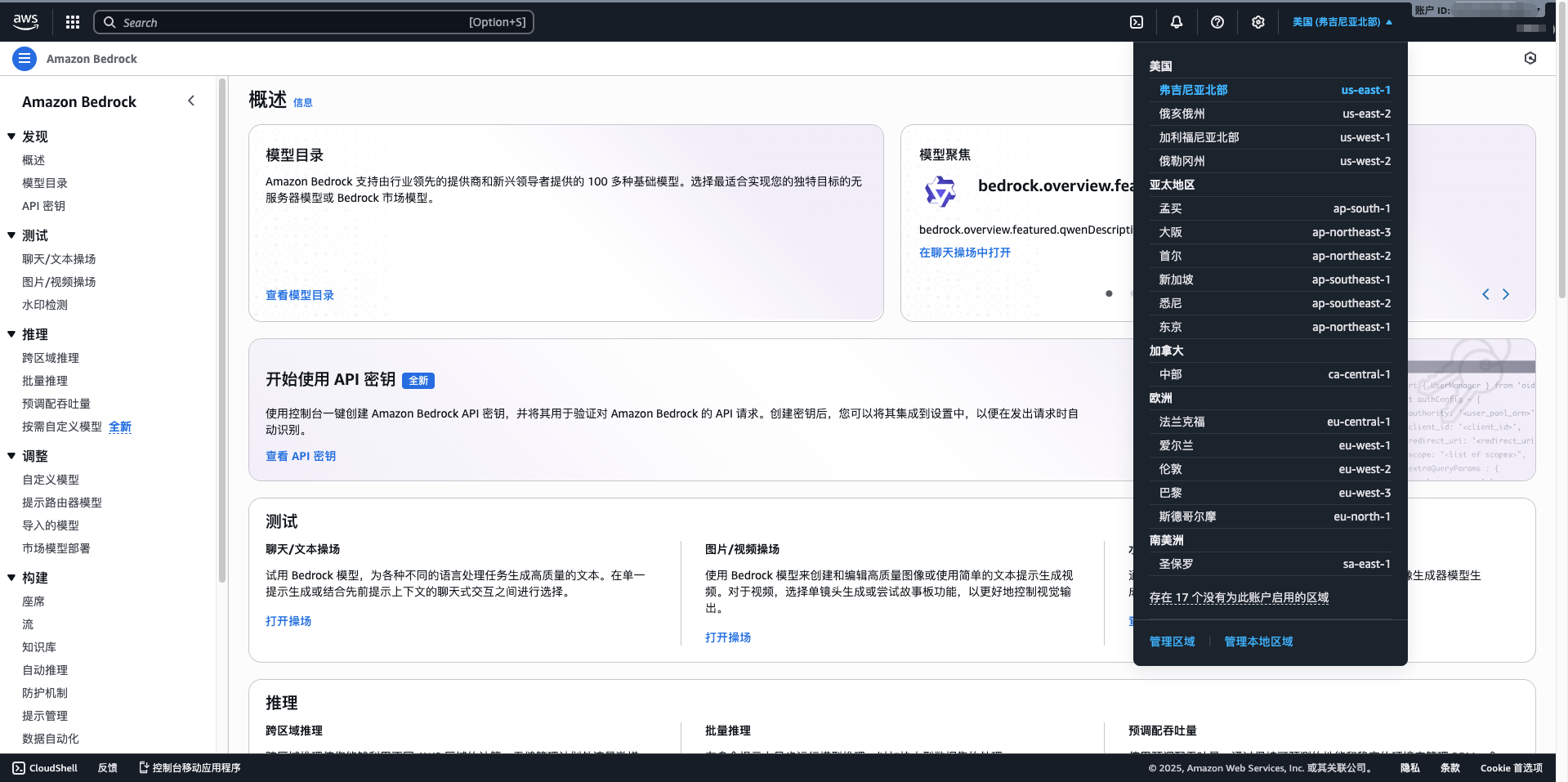

1.2 进入 Bedrock 服务

- 在搜索框中输入 Bedrock

- 点击 Amazon Bedrock

- 选择您的区域(建议 us-east-1)

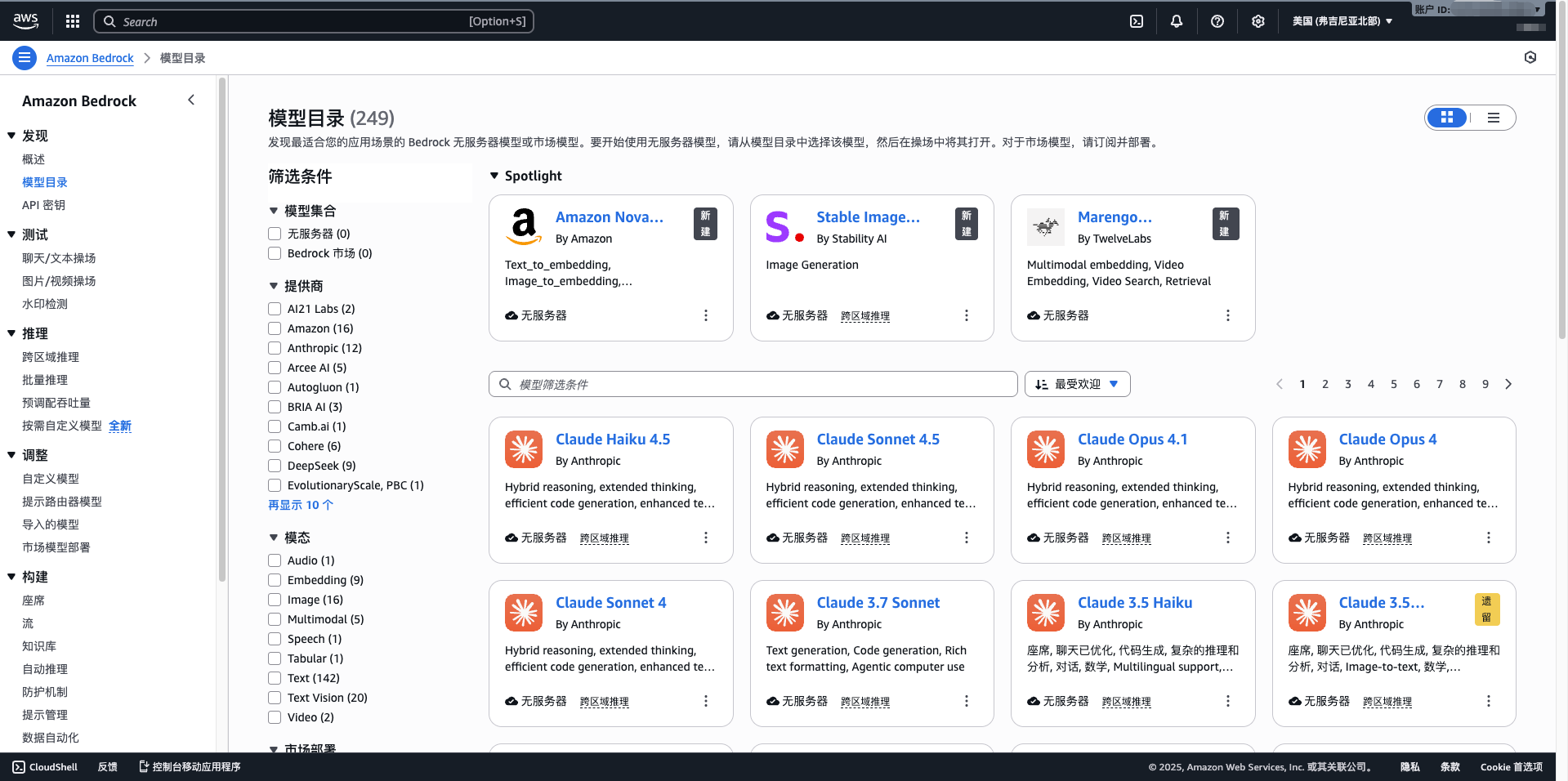

1.3 请求模型访问权限

- 点击左侧菜单的 Model access

- 点击 Manage model access

- 勾选需要使用的模型(如 Claude 3.5 Sonnet、Llama 3.1、Mistral Large)

- 点击 Request model access

- 等待审核通过(通常几分钟内)

1.4 创建 IAM 用户和访问密钥

- 访问 IAM 控制台:https://console.aws.amazon.com/iam/

- 点击 用户 > 添加用户

- 输入用户名(例如:cuemate-bedrock)

- 选择 访问密钥 - 程序化访问

- 附加策略:AmazonBedrockFullAccess

- 完成创建,记录 Access Key ID 和 Secret Access Key

2. 在 CueMate 中配置 Bedrock 模型

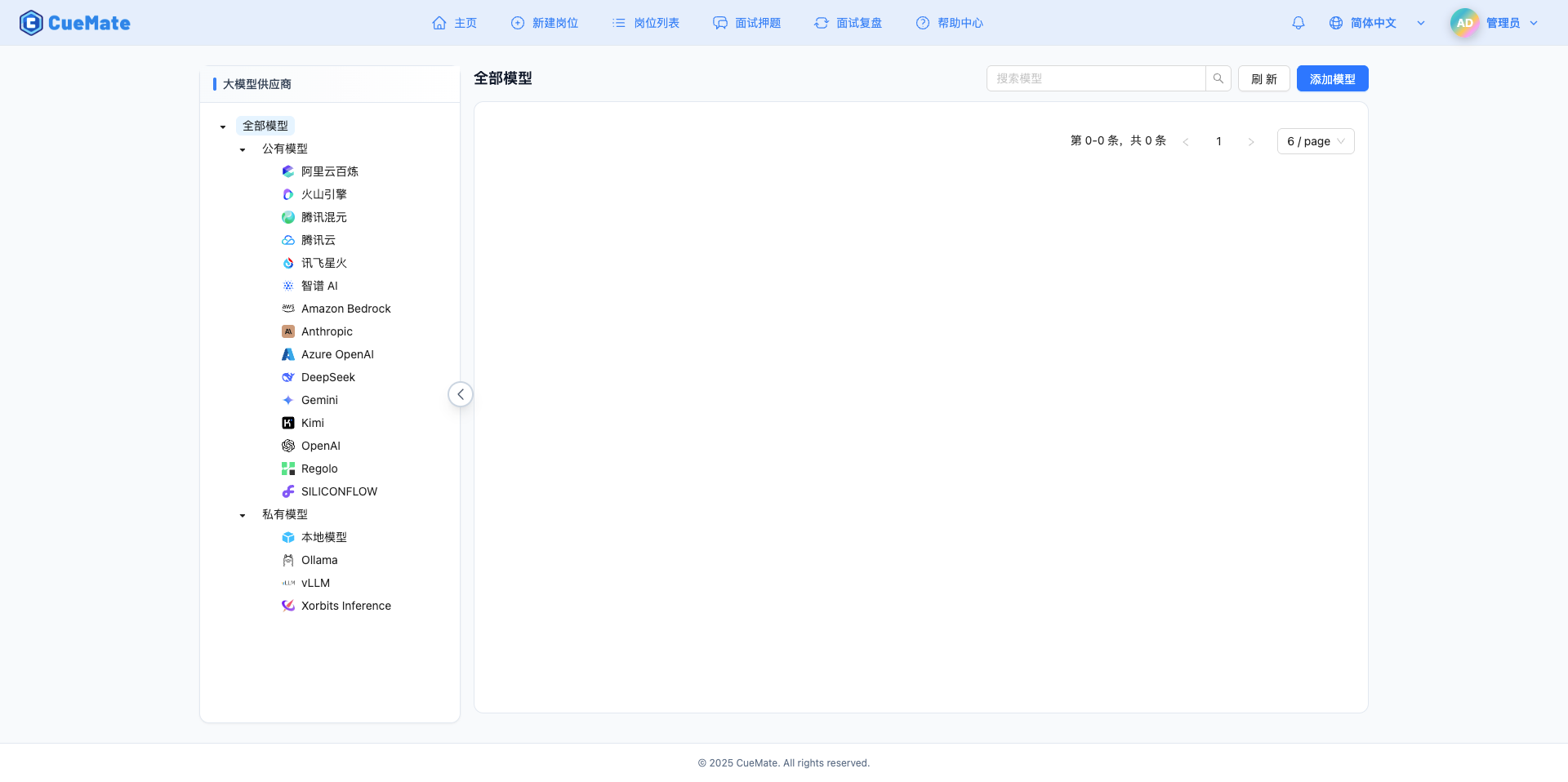

2.1 进入模型设置页面

登录 CueMate 系统后,点击右上角下拉菜单的 模型设置。

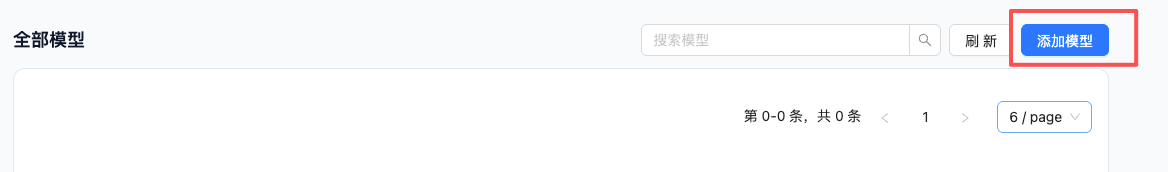

2.2 添加新模型

点击右上角的 添加模型 按钮。

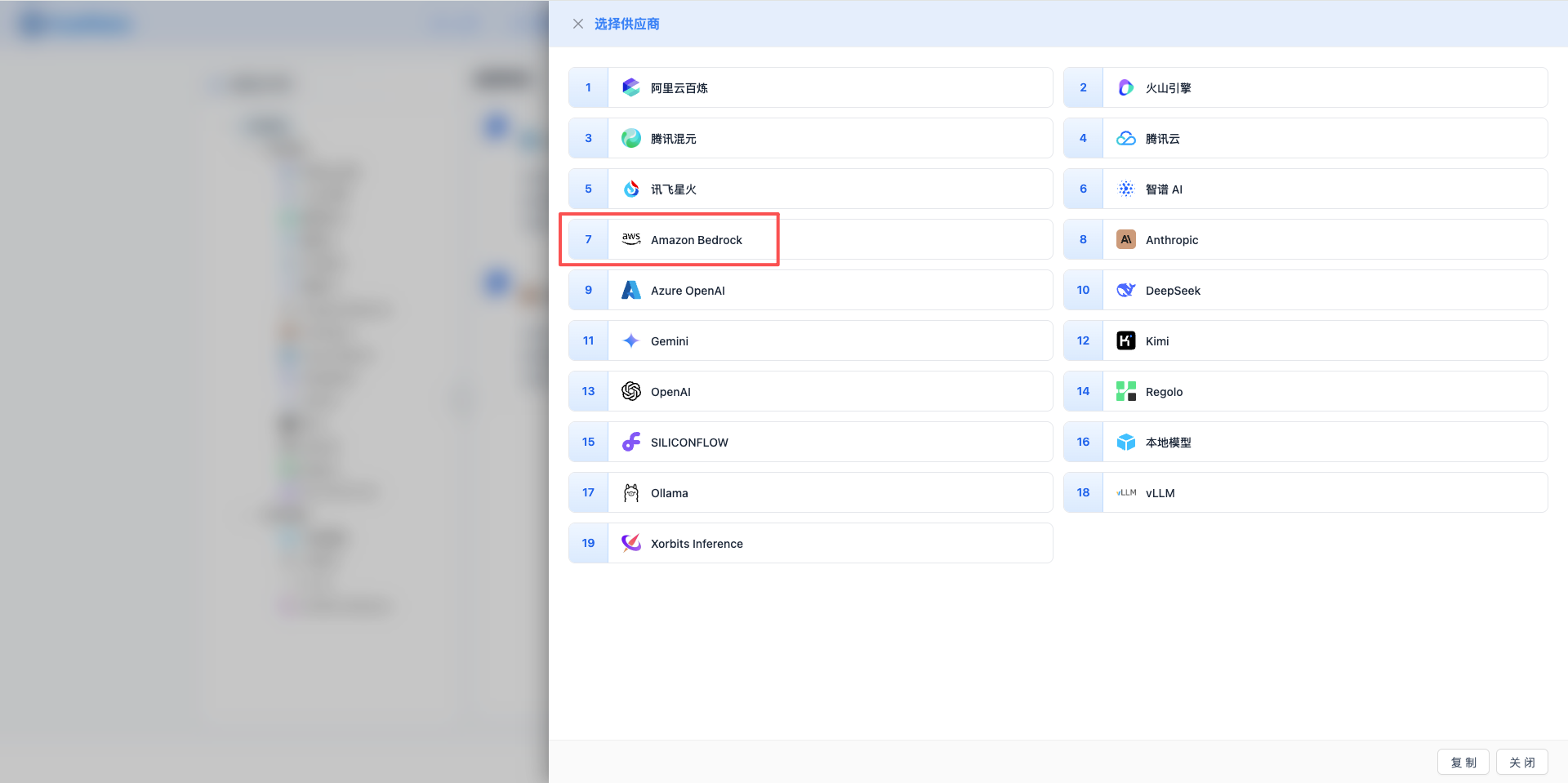

2.3 选择 Amazon Bedrock 服务商

在弹出的对话框中:

- 服务商类型:选择 Amazon Bedrock

- 点击后 自动进入下一步

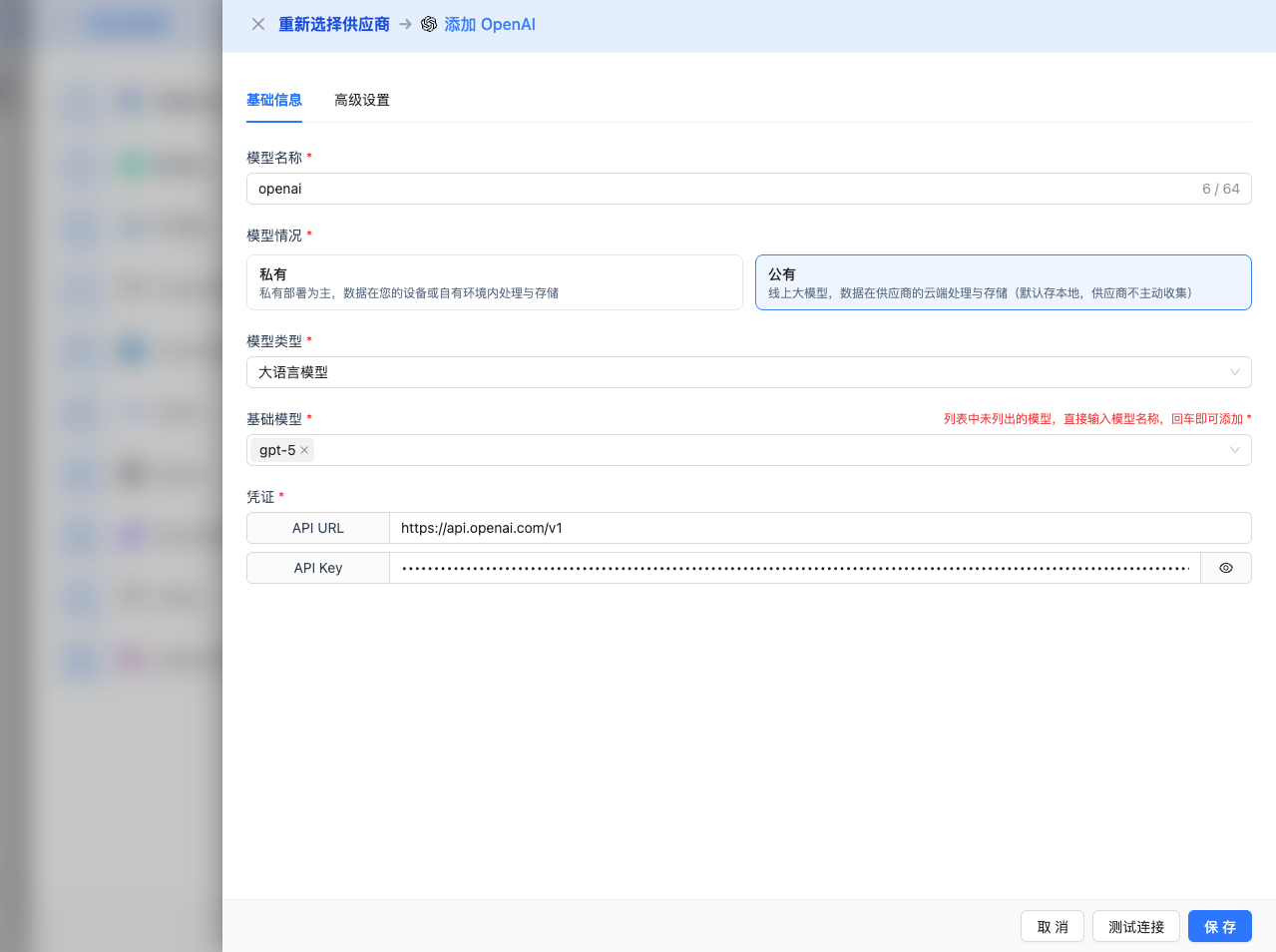

2.4 填写配置信息

在配置页面填写以下信息:

基础配置

- 模型名称:为这个模型配置起个名字(例如:Bedrock Claude 4.5 Sonnet)

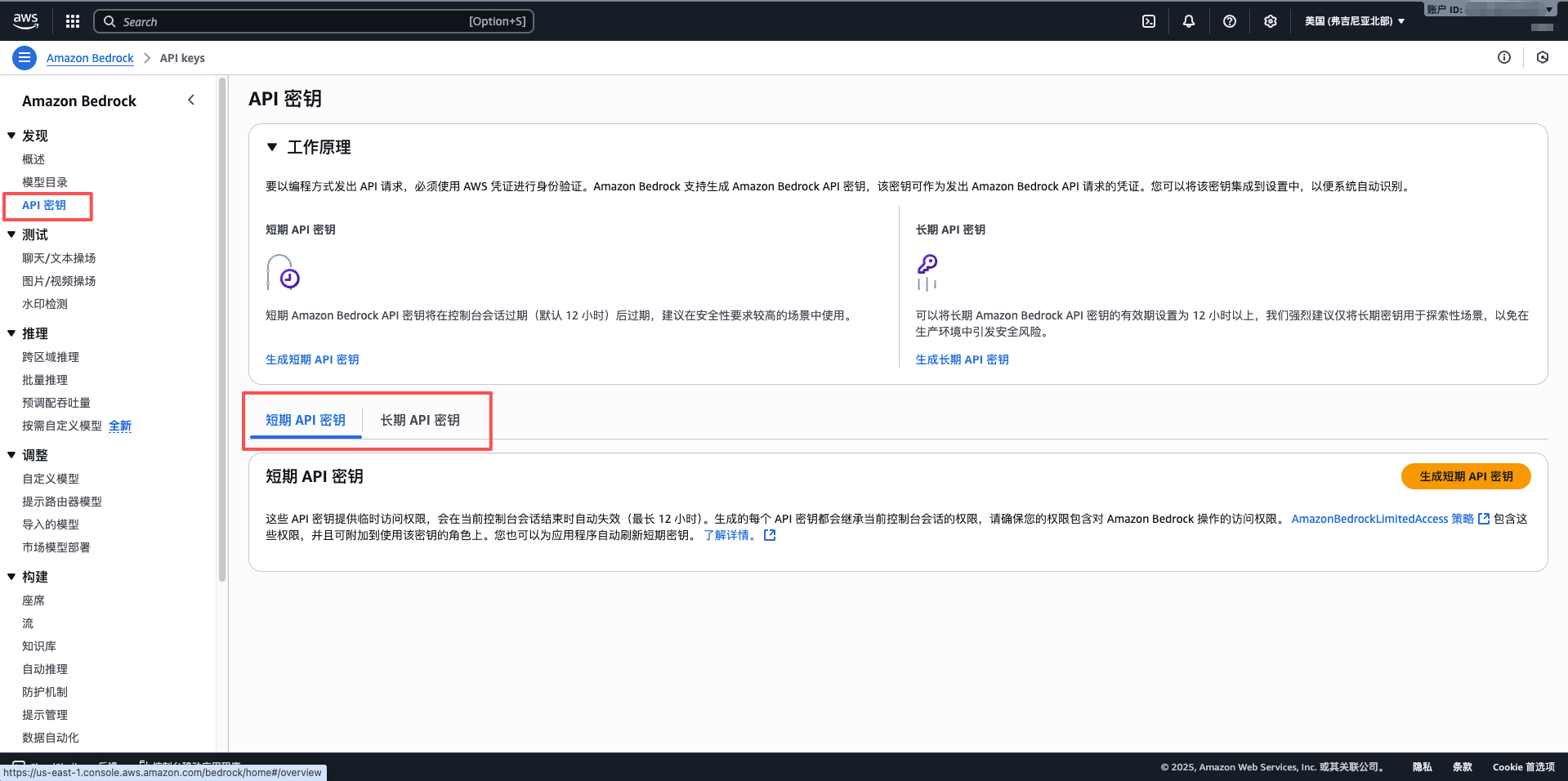

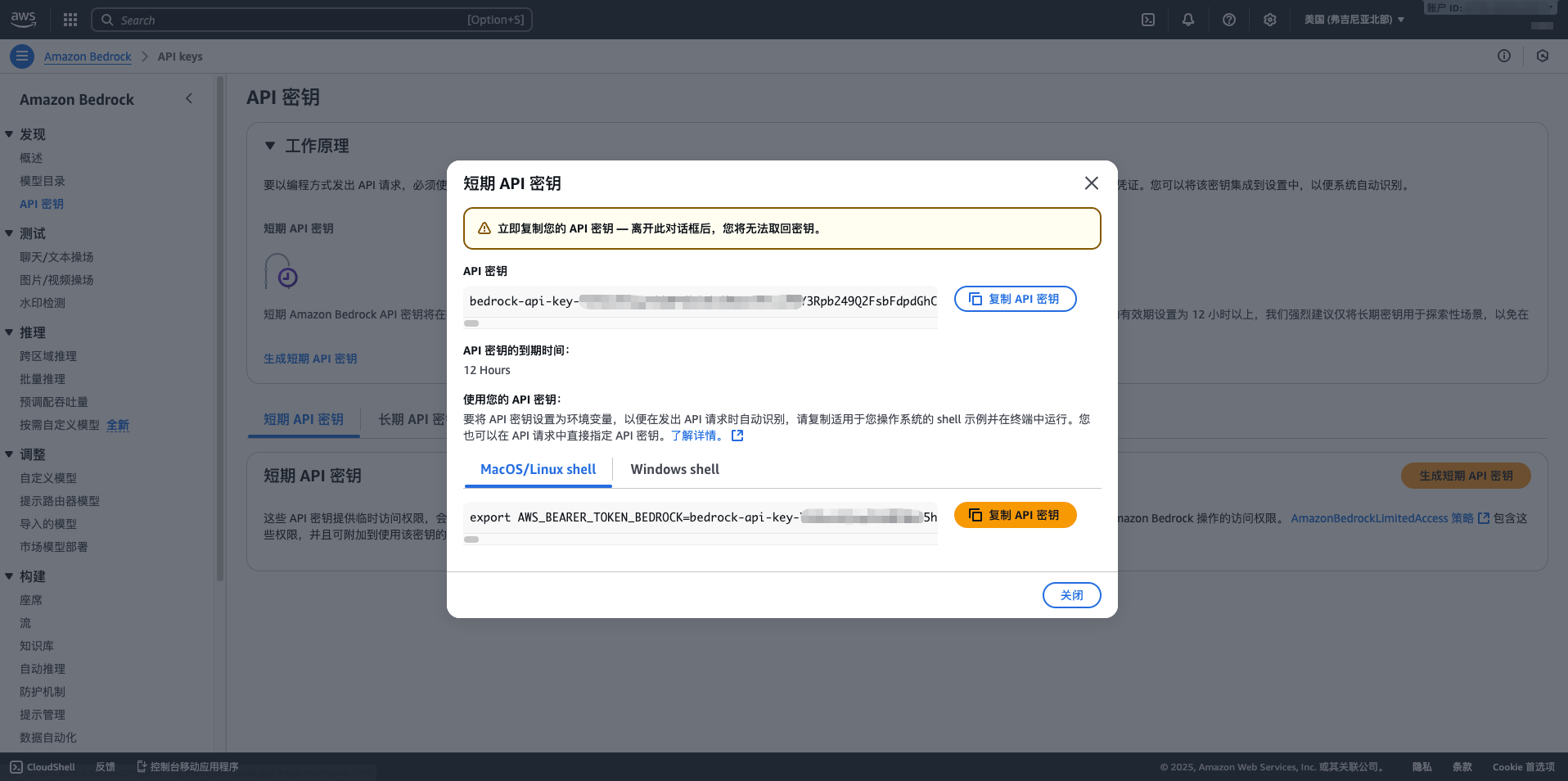

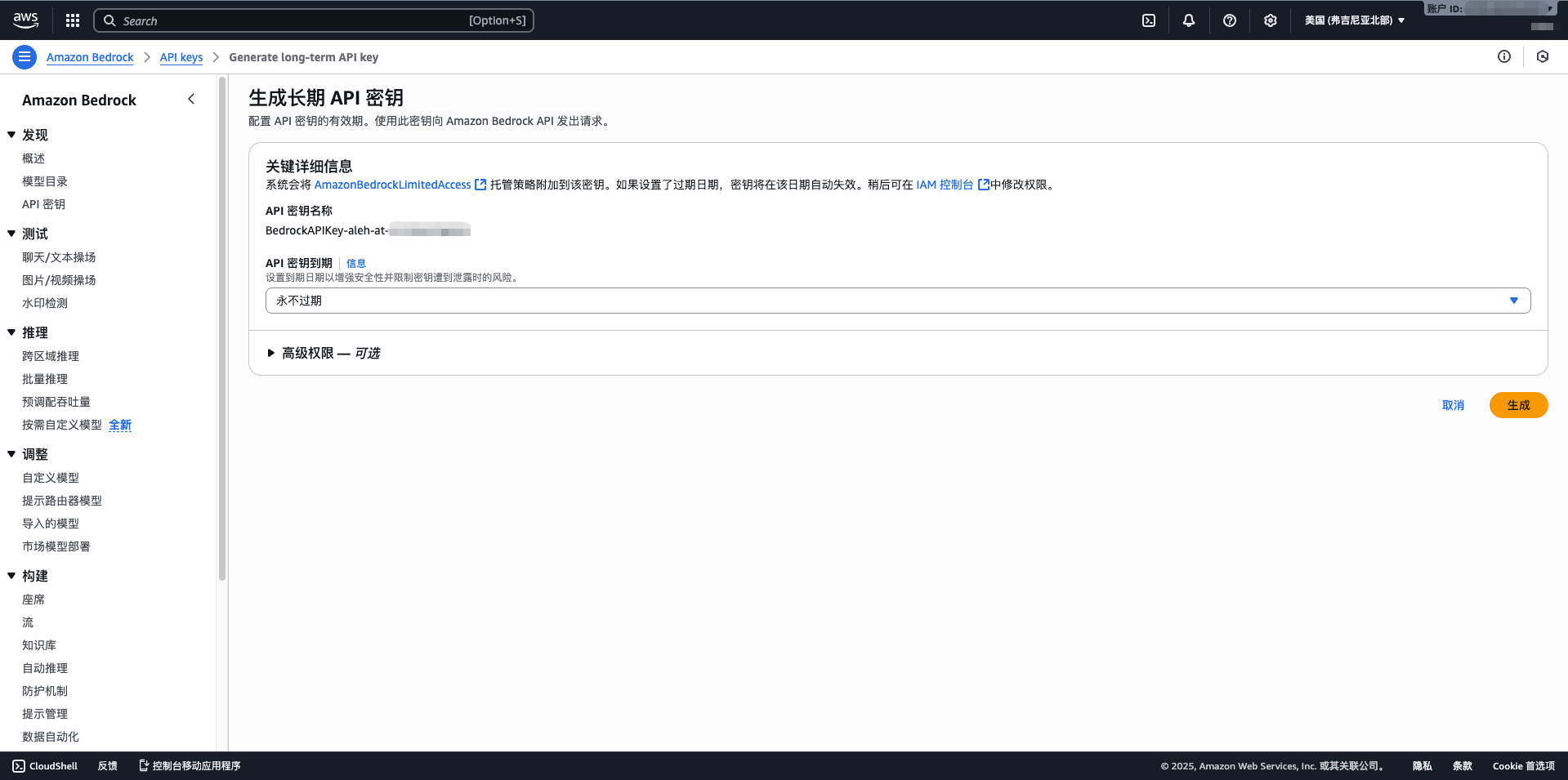

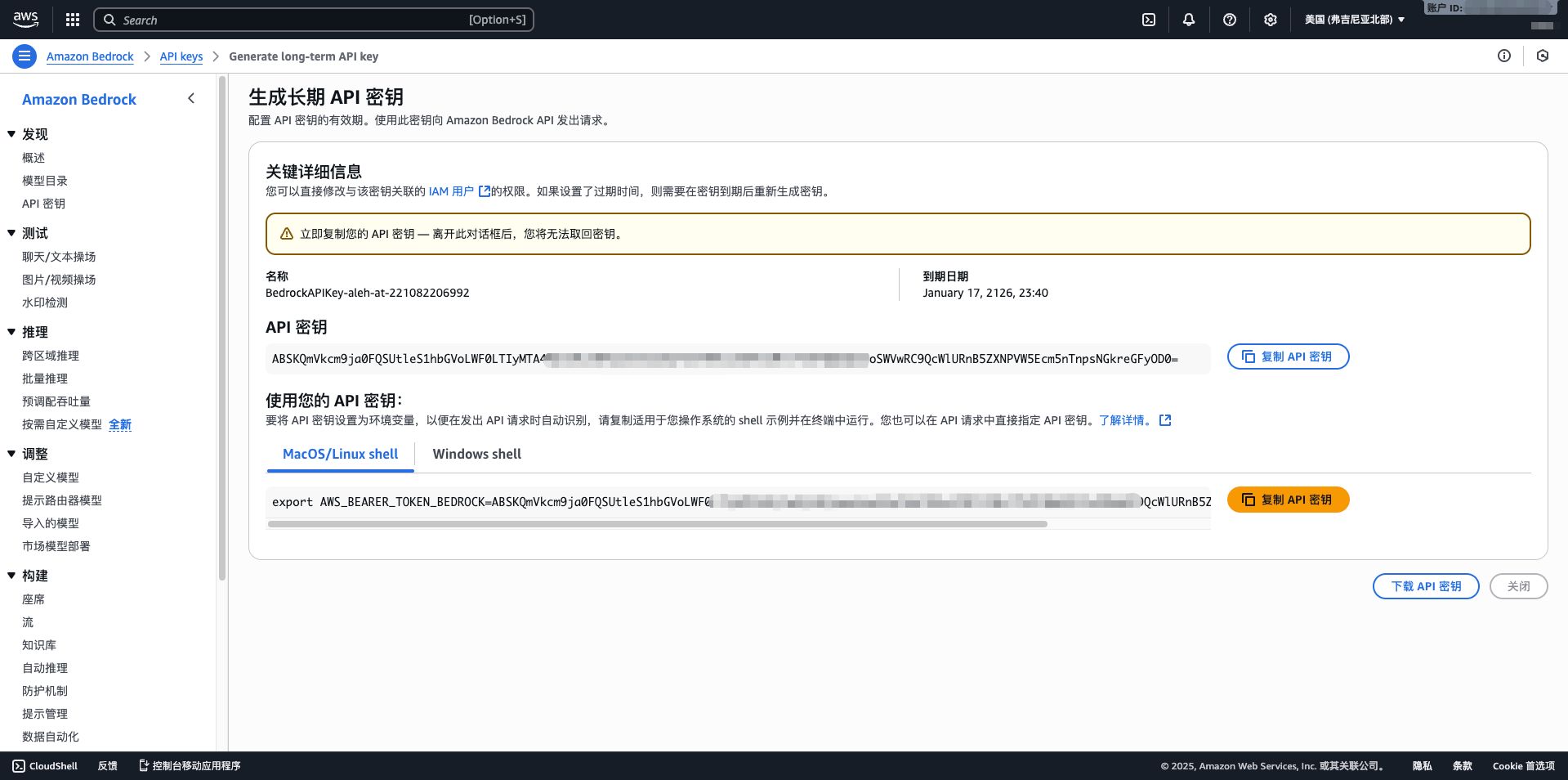

- API Key:粘贴从 AWS Bedrock 获取的长期 API 密钥

- AWS Region:选择区域(如 us-east-1,默认值)

- 模型版本:选择或输入要使用的模型ID,常用模型包括:

anthropic.claude-sonnet-4-5-20250929-v1:0:Claude 4.5 Sonnet(最新,最大输出64K)anthropic.claude-haiku-4-5-20251001-v1:0:Claude 4.5 Haiku(快速,最大输出64K)anthropic.claude-opus-4-1-20250805-v1:0:Claude 4.1 Opus(高性能,最大输出32K)anthropic.claude-3-5-sonnet-20241022-v2:0:Claude 3.5 Sonnet(最大输出64K)amazon.nova-pro-v1:0:Amazon Nova Pro(多模态,最大输出8K)meta.llama3-1-405b-instruct-v1:0:Llama 3.1 405B(超大规模,最大输出8K)mistral.mistral-large-2407-v1:0:Mistral Large(高性能,最大输出8K)

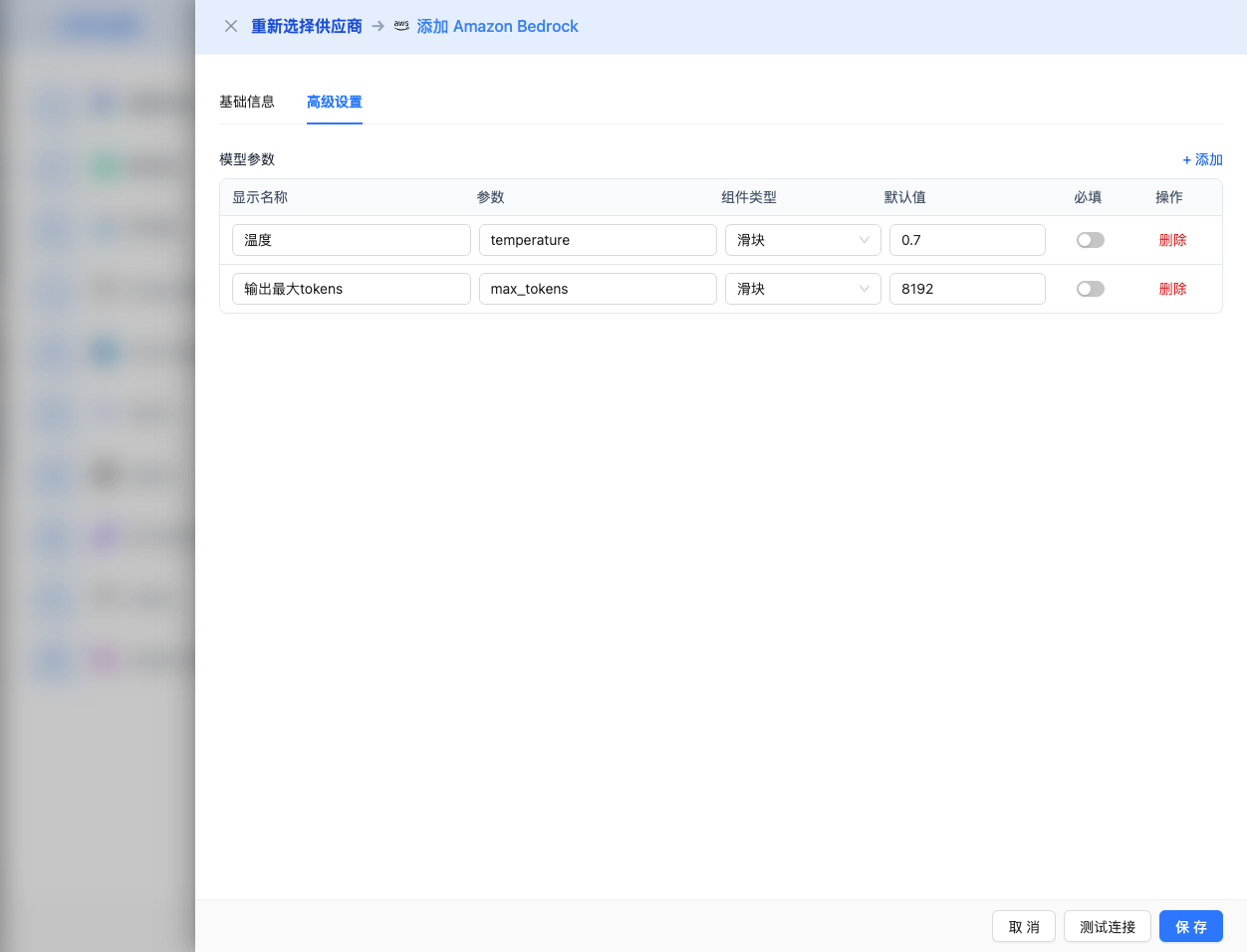

高级配置(可选)

展开 高级配置 面板,可以调整以下参数:

CueMate 界面可调参数:

温度(temperature):控制输出随机性

- 范围:0-2(根据模型系列而定)

- 推荐值:0.7

- 作用:值越高输出越随机创新,值越低输出越稳定保守

- 模型范围:

- Claude 系列:0-1

- Llama 系列:0-2

- Mistral 系列:0-1

- DeepSeek 系列:0-2

- Amazon Titan 系列:0-1

- 使用建议:

- 创意写作/头脑风暴:0.8-1.2(根据模型上限)

- 常规对话/问答:0.6-0.8

- 代码生成/精确任务:0.3-0.5

输出最大 tokens(max_tokens):限制单次输出长度

- 范围:256 - 65536(根据模型而定)

- 推荐值:8192

- 作用:控制模型单次响应的最大字数

- 模型限制:

- Claude 4.5 Sonnet/Haiku: 最大 65536 (64K tokens)

- Claude 4 Opus: 最大 32768 (32K tokens)

- Claude 4 Sonnet: 最大 65536 (64K tokens)

- Claude 3.7 Sonnet: 最大 65536 (64K tokens)

- Claude 3.5 Sonnet: 最大 65536 (64K tokens)

- Claude 3.5 Haiku: 最大 8192 (8K tokens)

- Claude 3 Opus/Sonnet/Haiku: 最大 4096 (4K tokens)

- Amazon Nova 全系列: 最大 8192 (8K tokens)

- Amazon Titan 全系列: 最大 8192 (8K tokens)

- Meta Llama 全系列: 最大 8192 (8K tokens)

- Mistral 全系列: 最大 8192 (8K tokens)

- DeepSeek 全系列: 最大 8192 (8K tokens)

- AI21 Jamba 系列: 最大 4096 (4K tokens)

- Cohere Command 系列: 最大 4096 (4K tokens)

- Qwen 全系列: 最大 8192 (8K tokens)

- 使用建议:

- 简短问答:1024-2048

- 常规对话:4096-8192

- 长文生成:16384-32768

- 超长文档:65536(仅 Claude 4.5/4/3.7/3.5 Sonnet)

AWS Bedrock API 支持的其他高级参数:

虽然 CueMate 界面只提供 temperature 和 max_tokens 调整,但如果你通过 API 直接调用 AWS Bedrock,不同模型系列还支持以下高级参数:

Anthropic Claude 系列参数

top_p(nucleus sampling)

- 范围:0-1

- 默认值:1

- 作用:从概率累积达到 p 的最小候选集中采样

- 与 temperature 的关系:通常只调整其中一个

- 使用建议:

- 保持多样性:0.9-0.95

- 更保守的输出:0.7-0.8

top_k

- 范围:0-500

- 默认值:250

- 作用:从概率最高的 k 个候选词中采样

- 使用建议:

- 更多样化:300-500

- 更保守:50-150

stop_sequences(停止序列)

- 类型:字符串数组

- 默认值:

["\n\nHuman:"] - 作用:当生成内容包含指定字符串时停止

- 最大数量:4 个

- 示例:

["###", "用户:", "\n\n"]

Meta Llama 系列参数

top_p(nucleus sampling)

- 范围:0-1

- 默认值:0.9

- 作用:从概率累积达到 p 的最小候选集中采样

top_k

- 范围:1-500

- 默认值:50

- 作用:从概率最高的 k 个候选词中采样

Amazon Titan 系列参数

topP(nucleus sampling)

- 范围:0-1

- 默认值:1

- 作用:从概率累积达到 p 的最小候选集中采样

stopSequences(停止序列)

- 类型:字符串数组

- 作用:当生成内容包含指定字符串时停止

- 示例:

["User:", "###"]

Mistral 系列参数

top_p(nucleus sampling)

- 范围:0-1

- 默认值:1

- 作用:从概率累积达到 p 的最小候选集中采样

top_k

- 范围:0-200

- 默认值:50

- 作用:从概率最高的 k 个候选词中采样

AWS Bedrock 通用特性:

stream(流式输出)

- 类型:布尔值

- 默认值:false

- 作用:启用流式返回,边生成边返回

- CueMate 中:自动处理,无需手动设置

guardrails(安全防护)

- 类型:对象

- 作用:配置 AWS Bedrock Guardrails 进行内容过滤

- 使用场景:企业级安全合规要求

- 示例:json

{ "guardrailIdentifier": "your-guardrail-id", "guardrailVersion": "1" }

| 场景 | 模型系列 | temperature | max_tokens | top_p | top_k |

|---|---|---|---|---|---|

| 创意写作 | Claude | 0.8-0.9 | 4096-8192 | 0.95 | 300 |

| 代码生成 | Claude | 0.3-0.5 | 2048-4096 | 0.9 | 100 |

| 问答系统 | Claude | 0.7 | 1024-2048 | 0.9 | 250 |

| 复杂推理 | Claude Opus | 0.7 | 32768 | 0.9 | 250 |

| 长文生成 | Claude Sonnet | 0.7 | 65536 | 0.9 | 250 |

| 快速响应 | Claude Haiku | 0.6 | 4096 | 0.9 | 200 |

| 大规模推理 | Llama 3.1 405B | 0.7 | 8192 | 0.9 | 50 |

| 多模态任务 | Nova Pro | 0.7 | 8192 | 1.0 | - |

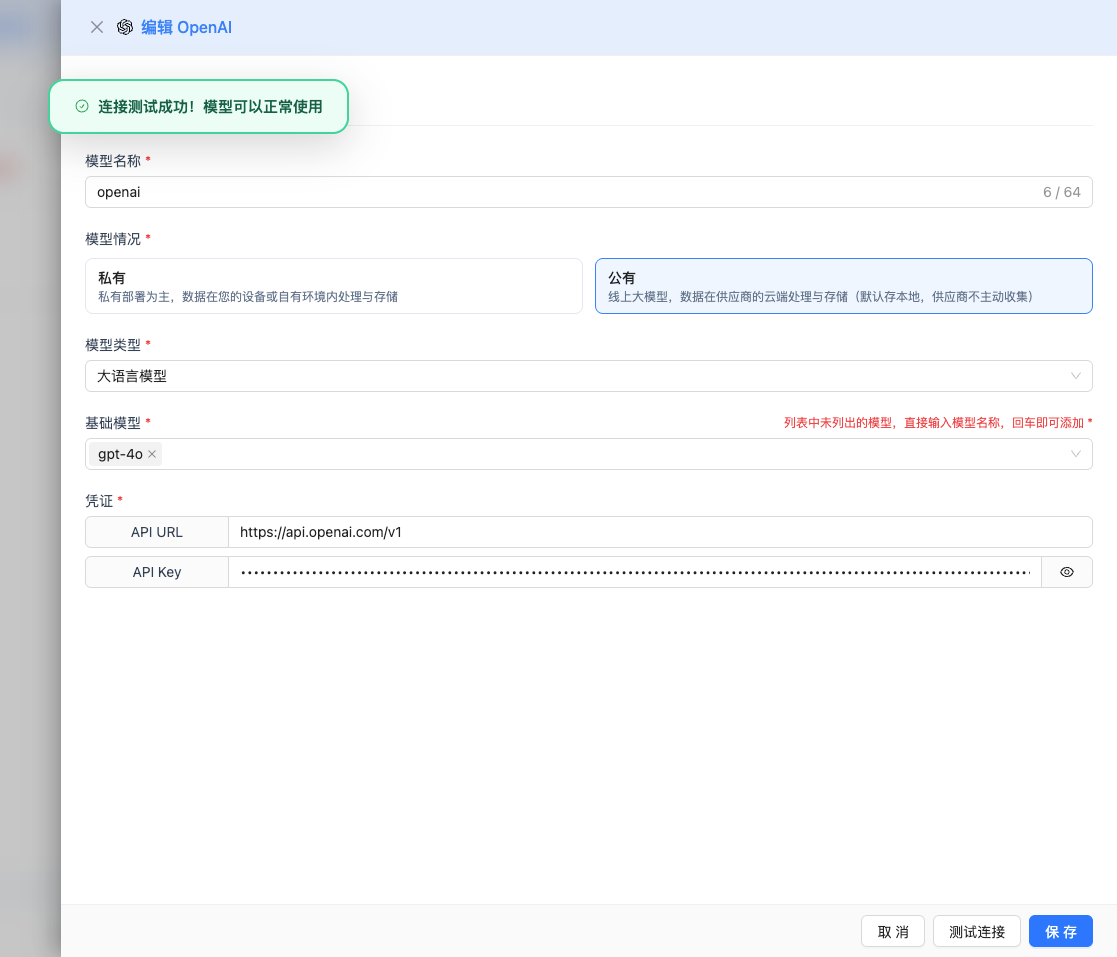

2.5 测试连接

填写完配置后,点击 测试连接 按钮,验证配置是否正确。

如果配置正确,会显示测试成功的提示,并返回模型的响应示例。

如果配置错误,会显示测试错误的日志,并且可以通过日志管理,查看具体报错信息。

2.6 保存配置

测试成功后,点击 保存 按钮,完成模型配置。

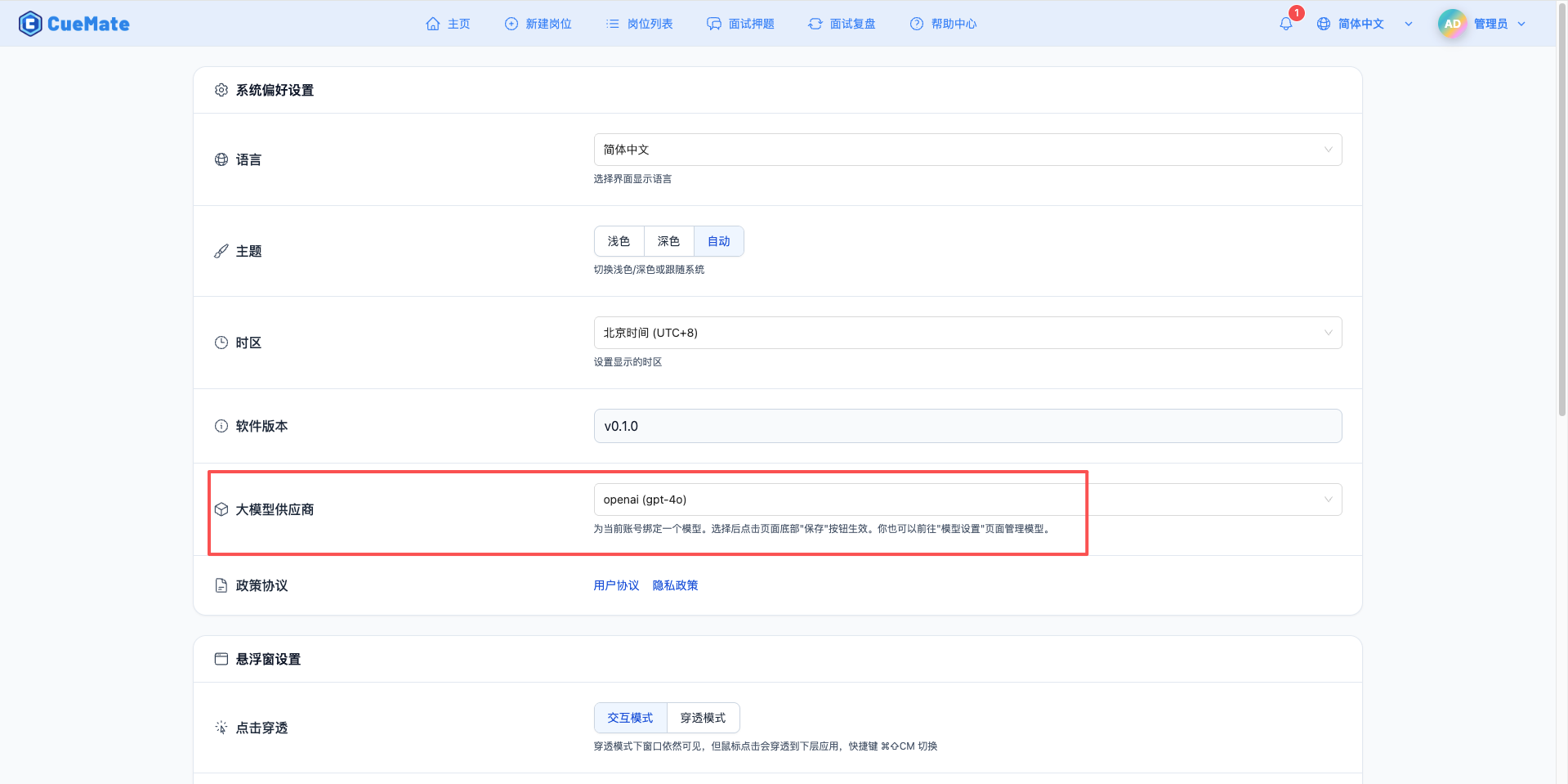

3. 使用模型

通过右上角下拉菜单,进入系统设置界面,在大模型服务商栏目选择想要使用的模型配置。

配置完成后,可以在面试训练、问题生成等功能中选择使用此模型, 当然也可以在面试的选项中单此选择此次面试的模型配置。

4. 支持的模型列表

CueMate 支持 AWS Bedrock 平台上的所有主流大模型,涵盖 10+ 个服务商的 70+ 个模型。以下是各系列的代表性模型:

4.1 Anthropic Claude系列

| 序号 | 模型名称 | 模型 ID | 最大输出 | 适用场景 |

|---|---|---|---|---|

| 1 | Claude 4.5 Sonnet | anthropic.claude-sonnet-4-5-20250929-v1:0 | 64K tokens | 最新一代,通用场景、高性能推理 |

| 2 | Claude 4.5 Haiku | anthropic.claude-haiku-4-5-20251001-v1:0 | 64K tokens | 快速响应、高吞吐量 |

| 3 | Claude 4.1 Opus | anthropic.claude-opus-4-1-20250805-v1:0 | 32K tokens | 复杂推理、深度分析 |

| 4 | Claude 4 Opus | anthropic.claude-opus-4-20250514-v1:0 | 32K tokens | 高质量输出 |

| 5 | Claude 4 Sonnet | anthropic.claude-sonnet-4-20250514-v1:0 | 64K tokens | 平衡性能与成本 |

| 6 | Claude 3.7 Sonnet | anthropic.claude-3-7-sonnet-20250219-v1:0 | 64K tokens | 增强版通用模型 |

| 7 | Claude 3.5 Sonnet v2 | anthropic.claude-3-5-sonnet-20241022-v2:0 | 64K tokens | 通用场景、高性能 |

| 8 | Claude 3.5 Sonnet v1 | anthropic.claude-3-5-sonnet-20240620-v1:0 | 64K tokens | 通用场景 |

| 9 | Claude 3.5 Haiku | anthropic.claude-3-5-haiku-20241022-v1:0 | 8K tokens | 快速响应 |

| 10 | Claude 3 Opus | anthropic.claude-3-opus-20240229-v1:0 | 4K tokens | 复杂推理 |

| 11 | Claude 3 Sonnet | anthropic.claude-3-sonnet-20240229-v1:0 | 4K tokens | 平衡性能 |

| 12 | Claude 3 Haiku | anthropic.claude-3-haiku-20240307-v1:0 | 4K tokens | 轻量级任务 |

4.2 Amazon Nova系列

| 序号 | 模型名称 | 模型 ID | 最大输出 | 适用场景 |

|---|---|---|---|---|

| 1 | Nova Premier | amazon.nova-premier-v1:0 | 8K tokens | 旗舰级多模态模型 |

| 2 | Nova Pro | amazon.nova-pro-v1:0 | 8K tokens | 高性能多模态处理 |

| 3 | Nova Lite | amazon.nova-lite-v1:0 | 8K tokens | 轻量级多模态任务 |

| 4 | Nova Micro | amazon.nova-micro-v1:0 | 8K tokens | 超轻量级场景 |

| 5 | Nova Sonic | amazon.nova-sonic-v1:0 | 8K tokens | 快速响应 |

4.3 Amazon Titan系列

| 序号 | 模型名称 | 模型 ID | 最大输出 | 适用场景 |

|---|---|---|---|---|

| 1 | Titan Premier | amazon.titan-text-premier-v1:0 | 8K tokens | 企业级应用 |

| 2 | Titan Express | amazon.titan-text-express-v1 | 8K tokens | 快速响应 |

| 3 | Titan Lite | amazon.titan-text-lite-v1 | 8K tokens | 轻量级任务 |

4.4 Meta Llama系列

| 序号 | 模型名称 | 模型 ID | 最大输出 | 适用场景 |

|---|---|---|---|---|

| 1 | Llama 4 Scout 17B | meta.llama4-scout-17b-instruct-v1:0 | 8K tokens | 新一代中等规模模型 |

| 2 | Llama 4 Maverick 17B | meta.llama4-maverick-17b-instruct-v1:0 | 8K tokens | 新一代高性能模型 |

| 3 | Llama 3.3 70B | meta.llama3-3-70b-instruct-v1:0 | 8K tokens | 增强版大规模推理 |

| 4 | Llama 3.2 90B | meta.llama3-2-90b-instruct-v1:0 | 8K tokens | 大规模推理 |

| 5 | Llama 3.2 11B | meta.llama3-2-11b-instruct-v1:0 | 8K tokens | 中等规模任务 |

| 6 | Llama 3.2 3B | meta.llama3-2-3b-instruct-v1:0 | 8K tokens | 轻量级任务 |

| 7 | Llama 3.2 1B | meta.llama3-2-1b-instruct-v1:0 | 8K tokens | 超轻量级 |

| 8 | Llama 3.1 405B | meta.llama3-1-405b-instruct-v1:0 | 8K tokens | 超大规模推理 |

| 9 | Llama 3.1 70B | meta.llama3-1-70b-instruct-v1:0 | 8K tokens | 大规模任务 |

| 10 | Llama 3.1 8B | meta.llama3-1-8b-instruct-v1:0 | 8K tokens | 标准任务 |

| 11 | Llama 3 70B | meta.llama3-70b-instruct-v1:0 | 8K tokens | 经典大规模模型 |

| 12 | Llama 3 8B | meta.llama3-8b-instruct-v1:0 | 8K tokens | 经典标准模型 |

4.5 Mistral AI系列

| 序号 | 模型名称 | 模型 ID | 最大输出 | 适用场景 |

|---|---|---|---|---|

| 1 | Pixtral Large 2502 | mistral.pixtral-large-2502-v1:0 | 8K tokens | 多模态大模型 |

| 2 | Mistral Large 2407 | mistral.mistral-large-2407-v1:0 | 8K tokens | 高性能场景 |

| 3 | Mistral Large 2402 | mistral.mistral-large-2402-v1:0 | 8K tokens | 通用场景 |

| 4 | Mistral Small 2402 | mistral.mistral-small-2402-v1:0 | 8K tokens | 轻量高效 |

| 5 | Mixtral 8x7B | mistral.mixtral-8x7b-instruct-v0:1 | 4K tokens | 混合专家模型 |

| 6 | Mistral 7B | mistral.mistral-7b-instruct-v0:2 | 8K tokens | 轻量级任务 |

4.6 AI21 Labs系列

| 序号 | 模型名称 | 模型 ID | 最大输出 | 适用场景 |

|---|---|---|---|---|

| 1 | Jamba 1.5 Large | ai21.jamba-1-5-large-v1:0 | 4K tokens | 大规模混合架构 |

| 2 | Jamba 1.5 Mini | ai21.jamba-1-5-mini-v1:0 | 4K tokens | 轻量级混合架构 |

4.7 Cohere系列

| 序号 | 模型名称 | 模型 ID | 最大输出 | 适用场景 |

|---|---|---|---|---|

| 1 | Command R+ | cohere.command-r-plus-v1:0 | 4K tokens | 增强版命令模型 |

| 2 | Command R | cohere.command-r-v1:0 | 4K tokens | 标准命令模型 |

4.8 DeepSeek系列

| 序号 | 模型名称 | 模型 ID | 最大输出 | 适用场景 |

|---|---|---|---|---|

| 1 | DeepSeek R1 | deepseek.r1-v1:0 | 8K tokens | 推理优化版本 |

| 2 | DeepSeek V3 | deepseek.v3-v1:0 | 8K tokens | 最新一代模型 |

4.9 Qwen系列

| 序号 | 模型名称 | 模型 ID | 最大输出 | 适用场景 |

|---|---|---|---|---|

| 1 | Qwen 3 Coder 480B | qwen.qwen3-coder-480b-a35b-v1:0 | 8K tokens | 超大规模代码生成 |

| 2 | Qwen 3 235B | qwen.qwen3-235b-a22b-2507-v1:0 | 8K tokens | 超大规模通用推理 |

| 3 | Qwen 3 Coder 30B | qwen.qwen3-coder-30b-a3b-v1:0 | 8K tokens | 代码生成专用 |

| 4 | Qwen 3 32B | qwen.qwen3-32b-v1:0 | 8K tokens | 标准通用模型 |

4.10 OpenAI系列

| 序号 | 模型名称 | 模型 ID | 最大输出 | 适用场景 |

|---|---|---|---|---|

| 1 | GPT-OSS 120B | openai.gpt-oss-120b-1:0 | 4K tokens | 开源版GPT大模型 |

| 2 | GPT-OSS 20B | openai.gpt-oss-20b-1:0 | 4K tokens | 开源版GPT中等模型 |

注意事项:

- 以上模型均需要在 AWS Bedrock 控制台申请访问权限后才能使用

- 不同模型的定价不同,请参考 AWS Bedrock 定价说明

- 实际最大输出取决于您在 CueMate 配置中设置的 Max Tokens 参数

- 部分模型可能仅在特定 AWS 区域可用,建议使用 us-east-1 获得最佳模型覆盖

5. 常见问题

5.1 模型访问未授权

现象:提示模型访问被拒绝

解决方案:

- 在Bedrock控制台检查模型访问状态

- 确认已请求并获得模型访问权限

- 等待审核通过(部分模型可能需要1-2个工作日)

5.2 IAM权限不足

现象:提示权限错误

解决方案:

- 确认IAM用户已附加 AmazonBedrockFullAccess 策略

- 检查访问密钥是否正确

- 验证区域设置是否与模型可用区域匹配

5.3 区域不支持

现象:提示服务在当前区域不可用

解决方案:

- 使用支持Bedrock的区域(推荐 us-east-1 或 us-west-2)

- 修改API URL中的区域代码

- 确认选择的模型在该区域可用

5.4 配额限制

现象:提示超出请求配额

解决方案:

- 在Bedrock控制台查看配额使用情况

- 申请提高TPM(每分钟Token数)或RPM(每分钟请求数)限制

- 优化请求频率