配置 Google Gemini

Google Gemini 是 Google 开发的多模态 AI 模型系列,支持文本、图像、音频等多种输入形式。提供从轻量级到旗舰级的多层次模型选择,具备强大的推理、分析和创作能力。

1. 获取 Google Gemini API Key

1.1 访问 AI Studio

访问 AI Studio 并登录:https://aistudio.google.com/

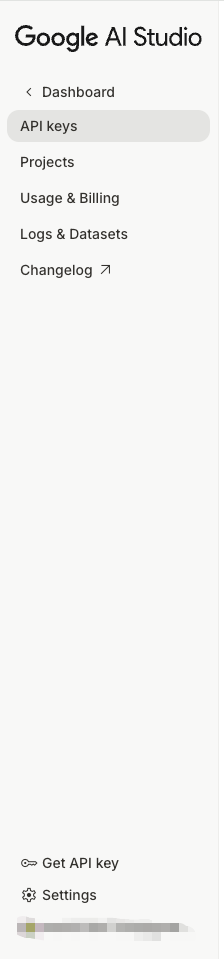

1.2 进入 API Keys 页面

登录后,点击左侧菜单的 Get API key。

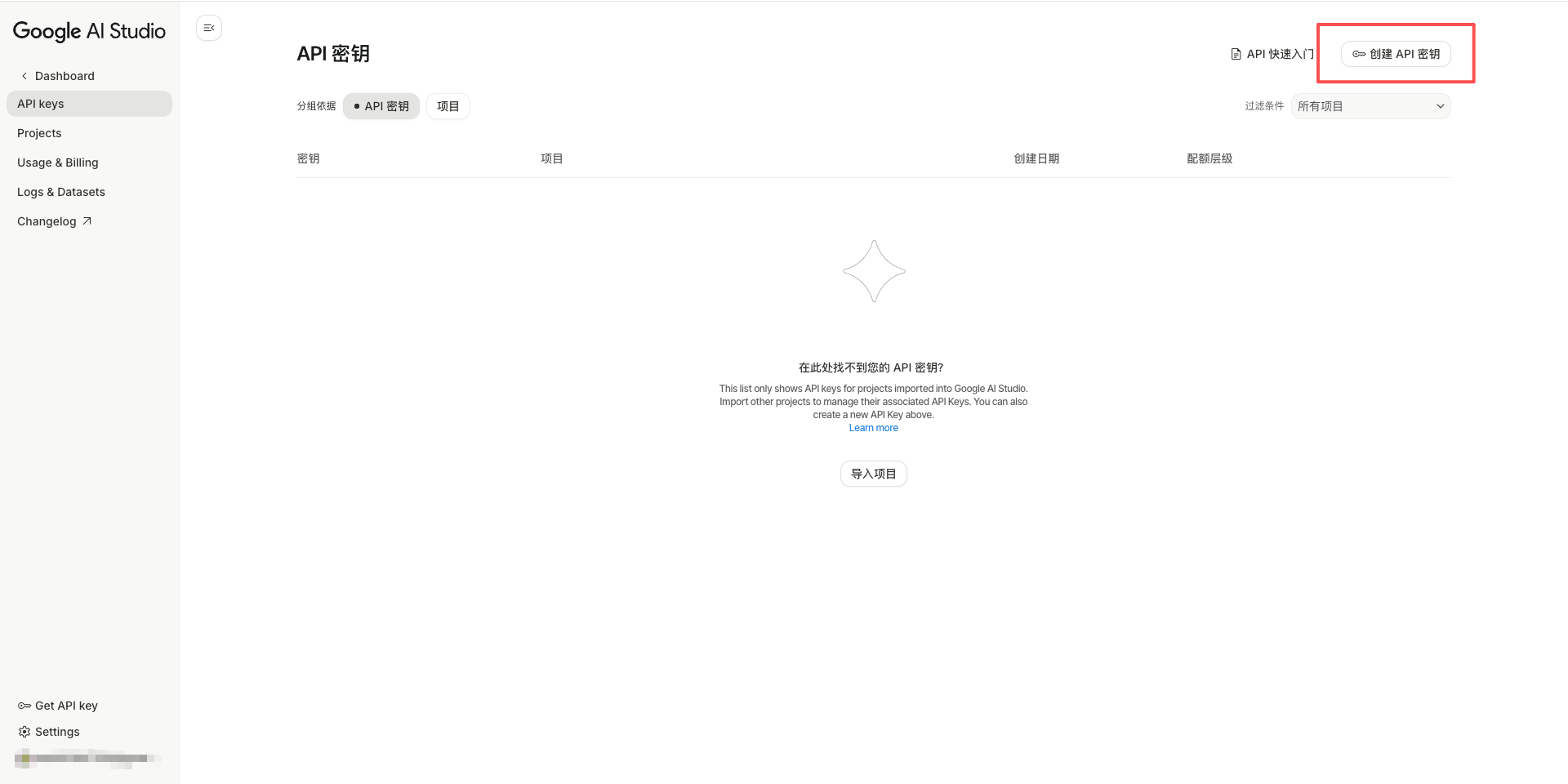

1.3 创建新的 API Key

点击 Create API key 按钮。

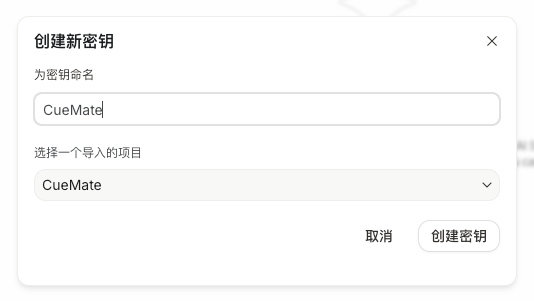

1.4 选择 Google Cloud 项目

在弹出的对话框中:

- 选择现有项目或创建新项目

- 点击 Create API key in existing project 或 Create API key in new project

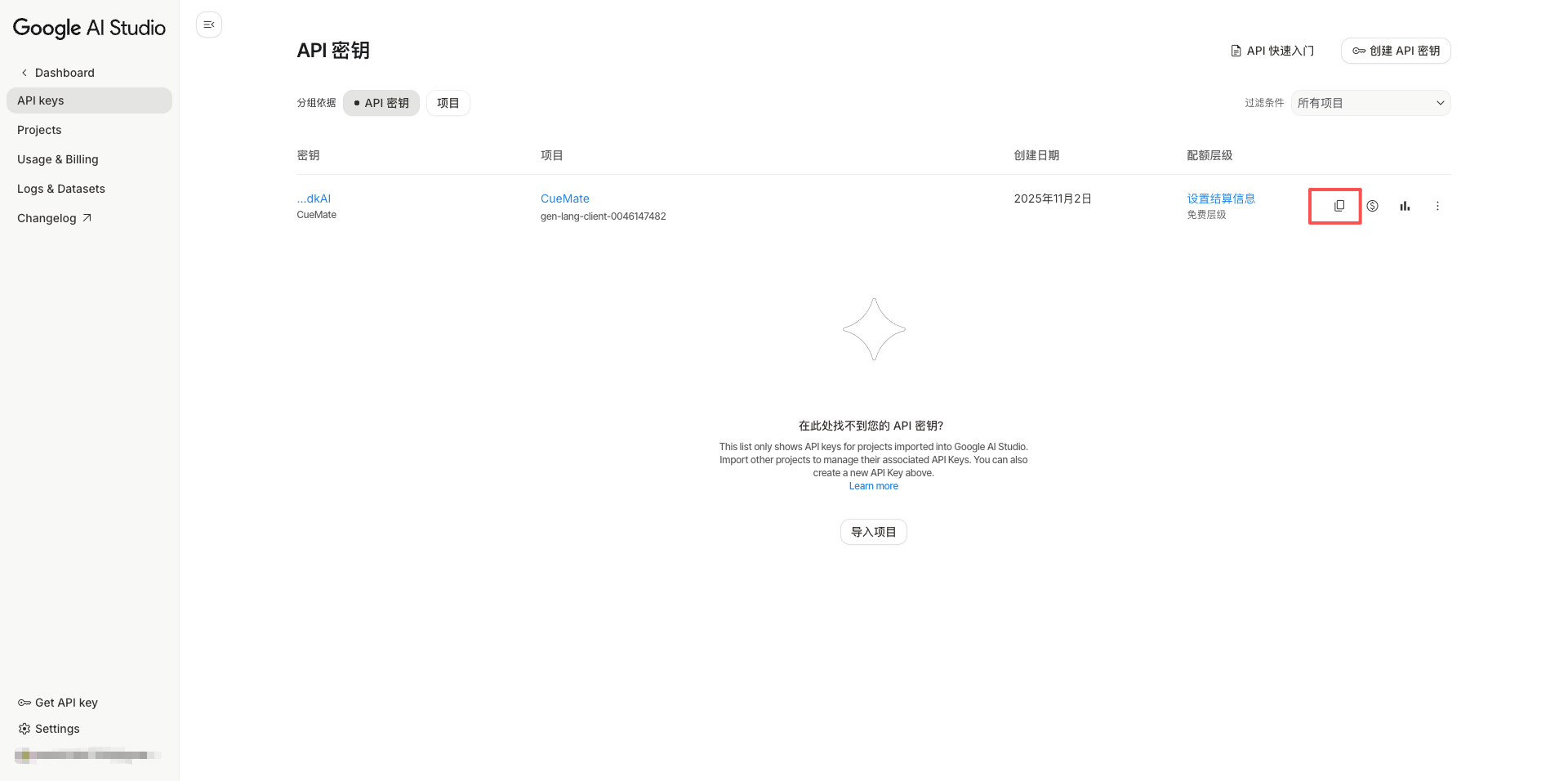

1.5 复制 API Key

创建成功后,系统会显示 API Key。

重要:请立即复制并妥善保存,API Key 以 AIzaSy 开头,长度为39位字符。

点击复制按钮,API Key 已复制到剪贴板。

2. 在 CueMate 中配置 Gemini 模型

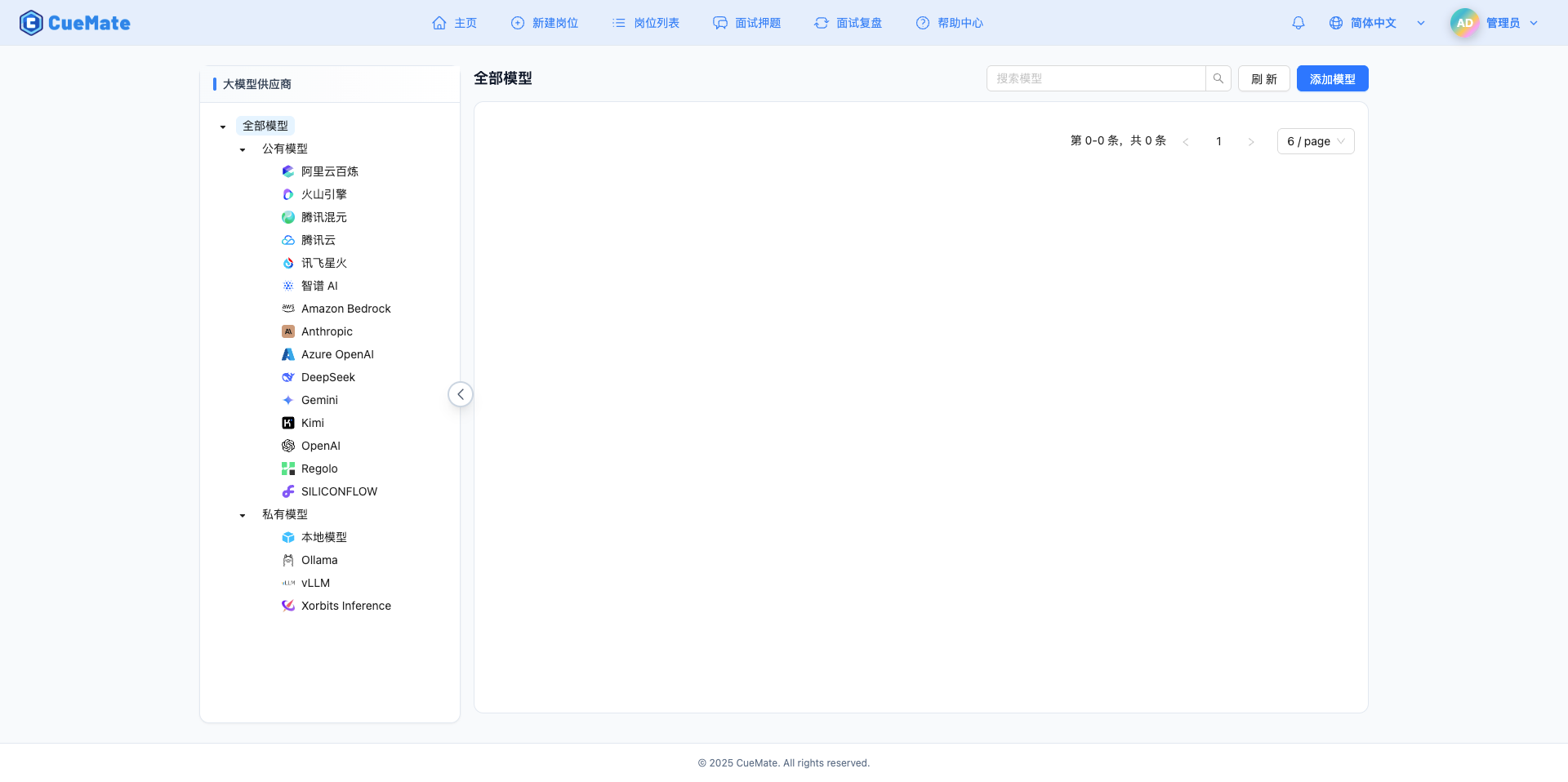

2.1 进入模型设置页面

登录 CueMate 系统后,点击右上角下拉菜单的 模型设置。

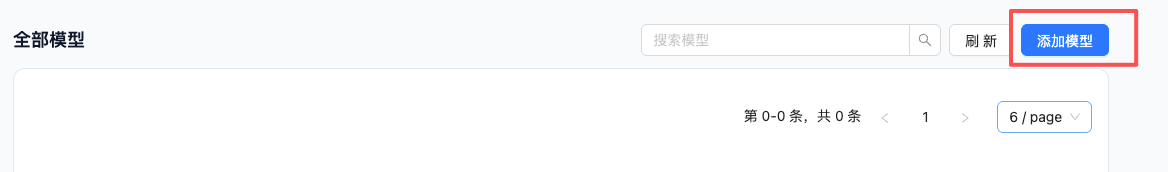

2.2 添加新模型

点击右上角的 添加模型 按钮。

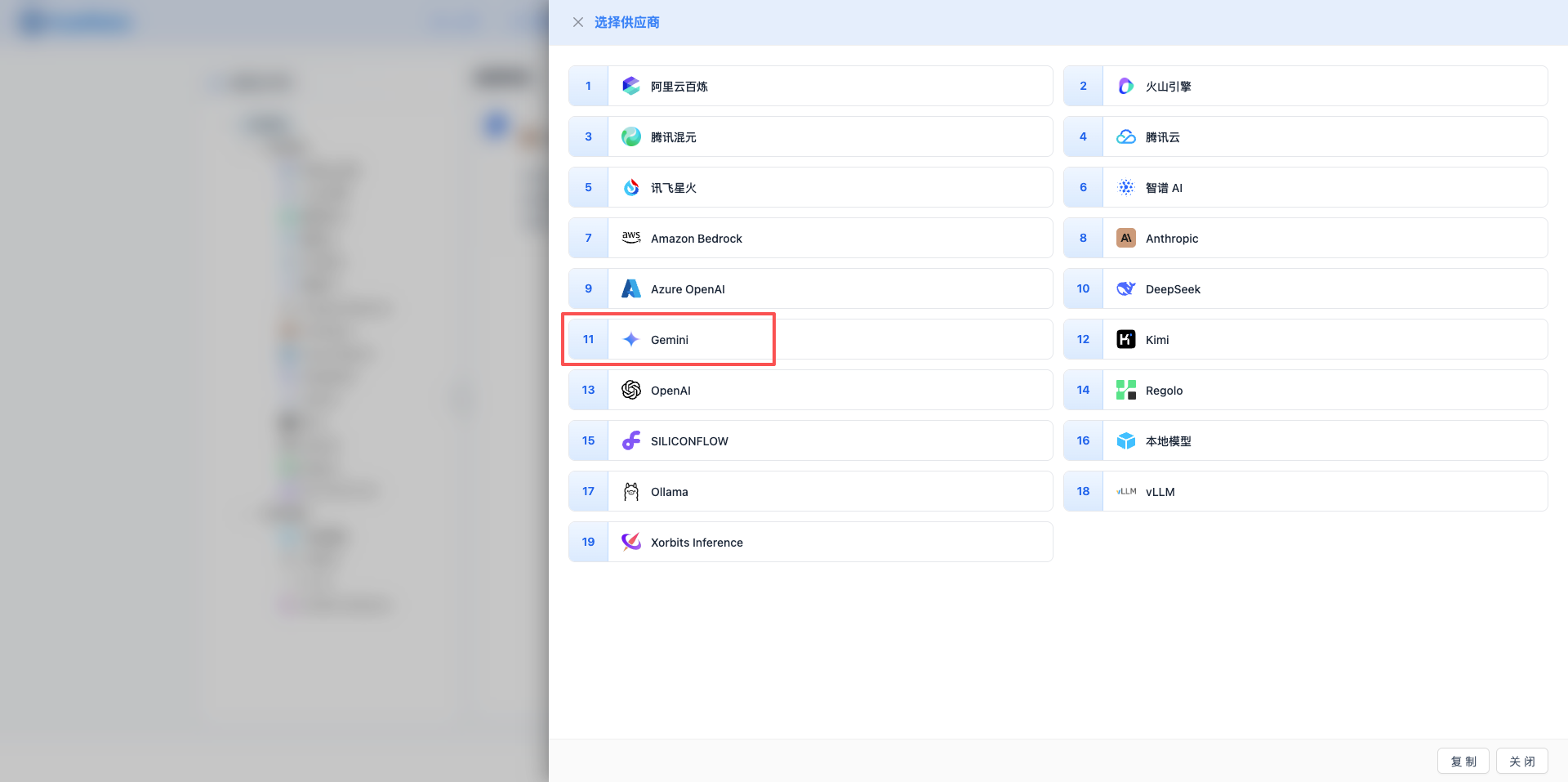

2.3 选择 Gemini 服务商

在弹出的对话框中:

- 服务商类型:选择 Gemini

- 点击后 自动进入下一步

2.4 填写配置信息

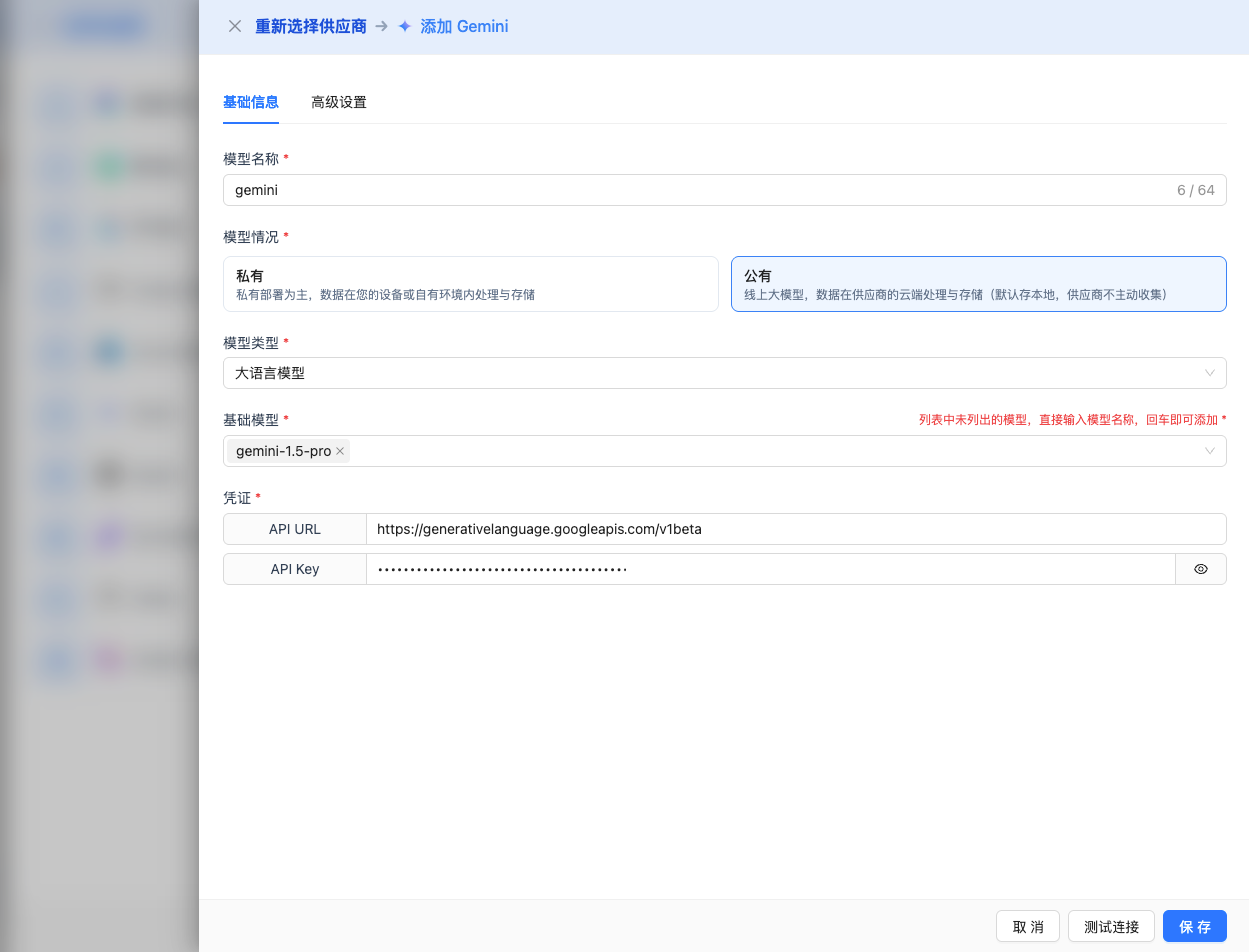

在配置页面填写以下信息:

基础配置

- 模型名称:为这个模型配置起个名字(例如:Gemini-2.0-Flash)

- API Key:粘贴刚才复制的Google Gemini API Key

- API URL:保持默认

https://generativelanguage.googleapis.com/v1beta - 模型版本:选择或输入要使用的模型(推荐使用完整版本号)

gemini-2.5-pro-exp-03-25:2.5 Pro实验版,最强性能gemini-2.0-flash-001:2.0 Flash稳定版,推荐使用gemini-2.0-flash-exp:2.0 Flash实验版gemini-1.5-pro-latest:1.5 Pro最新版gemini-1.5-pro-002:1.5 Pro稳定版gemini-1.5-flash-latest:1.5 Flash最新版gemini-1.5-flash-002:1.5 Flash稳定版gemini-1.5-flash-8b:8B参数轻量版gemini-1.0-pro:1.0 Pro标准版(旧版)gemini-1.0-pro-vision:1.0 支持视觉理解(旧版)

高级配置(可选)

展开 高级配置 面板,可以调整以下参数:

CueMate 界面可调参数:

温度(temperature):控制输出随机性

- 范围:0-2

- 推荐值:0.7

- 作用:值越高输出越随机创新,值越低输出越稳定保守

- 使用建议:

- 创意写作/头脑风暴:1.0-1.5

- 常规对话/问答:0.7-0.9

- 代码生成/精确任务:0.3-0.5

- 注意:Gemini 的 temperature 范围是 0-2,与 Claude 的 0-1 不同

输出最大 tokens(maxOutputTokens):限制单次输出长度

- 范围:256 - 65536(根据模型而定)

- 推荐值:8192

- 作用:控制模型单次响应的最大字数

- 模型限制:

- Gemini 2.5 Pro:最大 65K tokens

- Gemini 2.0 系列:最大 8K tokens

- Gemini 1.5 系列:最大 8K tokens

- Gemini 1.0 Pro:最大 2K tokens

- Gemini 1.0 Pro Vision:最大 4K tokens

- 使用建议:

- 简短问答:1024-2048

- 常规对话:4096-8192

- 长文生成:16384-32768

- 超长输出:65536(仅 2.5 Pro)

Google Gemini API 支持的其他高级参数:

虽然 CueMate 界面只提供 temperature 和 maxOutputTokens 调整,但如果你通过 API 直接调用 Gemini,还可以使用以下高级参数:

topP(nucleus sampling)

- 范围:0-1

- 默认值:0.95

- 作用:从概率累积达到 p 的最小候选集中采样

- 与 temperature 的关系:可以同时使用

- 使用建议:

- 保持多样性:0.9-1.0

- 更保守的输出:0.7-0.8

topK

- 范围:1-40

- 默认值:40(或 null,表示不限制)

- 作用:从概率最高的 k 个候选词中采样

- 使用建议:

- 更多样化:32-40

- 更保守:10-20

- 注意:Gemini 的 topK 最大值为 40

stopSequences(停止序列)

- 类型:字符串数组

- 默认值:null

- 最大数量:5 个字符串

- 作用:当生成内容包含指定字符串时停止

- 示例:

["END", "###", "\n\n"] - 使用场景:

- 结构化输出:使用分隔符控制格式

- 对话系统:防止模型继续生成

- 代码块控制:使用代码块结束标记

candidateCount

- 类型:整数

- 范围:1-8

- 默认值:1

- 作用:生成多个候选回复供选择

- 使用场景:

- A/B 测试不同输出

- 选择最佳回复

- 注意:会增加 API 调用成本

Gemini 安全设置:

- safetySettings

- 类型:对象数组

- 作用:配置内容安全过滤级别

- 安全类别:

HARM_CATEGORY_HARASSMENT:骚扰内容HARM_CATEGORY_HATE_SPEECH:仇恨言论HARM_CATEGORY_SEXUALLY_EXPLICIT:性相关内容HARM_CATEGORY_DANGEROUS_CONTENT:危险内容

- 过滤级别:

BLOCK_NONE:不过滤BLOCK_LOW_AND_ABOVE:过滤低风险及以上BLOCK_MEDIUM_AND_ABOVE:过滤中等及以上(默认)BLOCK_ONLY_HIGH:仅过滤高风险

- 示例:json

{ "safetySettings": [ { "category": "HARM_CATEGORY_HARASSMENT", "threshold": "BLOCK_MEDIUM_AND_ABOVE" } ] } - 使用建议:

- 面向公众的应用:保持默认设置

- 内部工具/研究:可适当放宽(BLOCK_ONLY_HIGH)

- 严格场景:使用 BLOCK_LOW_AND_ABOVE

| 场景 | temperature | maxOutputTokens | topP | topK | stopSequences |

|---|---|---|---|---|---|

| 创意写作 | 1.0-1.2 | 4096-8192 | 0.95 | 40 | null |

| 代码生成 | 0.2-0.5 | 2048-4096 | 0.9 | 30 | null |

| 问答系统 | 0.7 | 1024-2048 | 0.9 | 40 | null |

| 摘要总结 | 0.3-0.5 | 512-1024 | 0.9 | 20 | null |

| 结构化输出 | 0.5 | 2048 | 0.9 | 30 | ["END", "###"] |

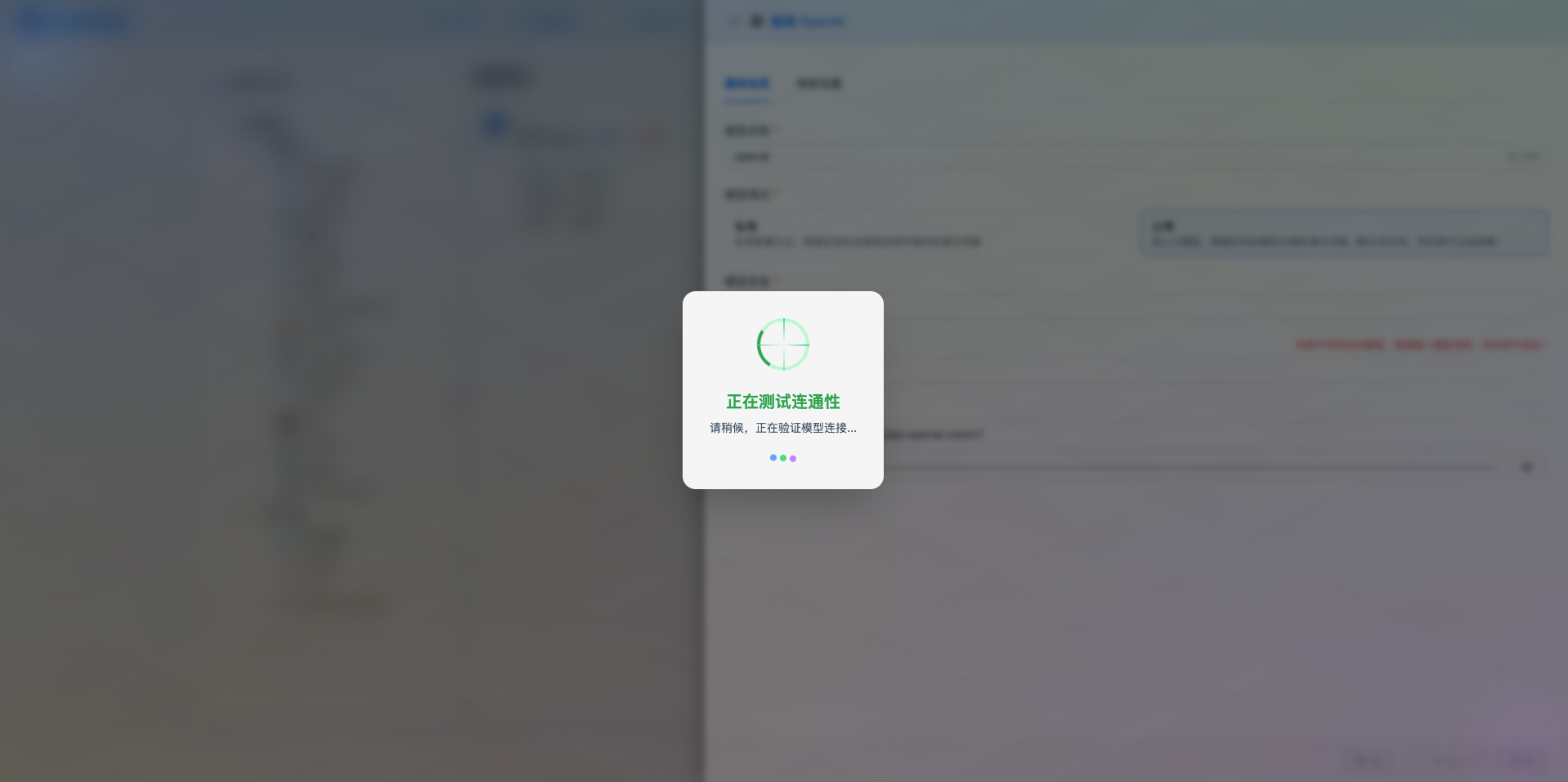

2.5 测试连接

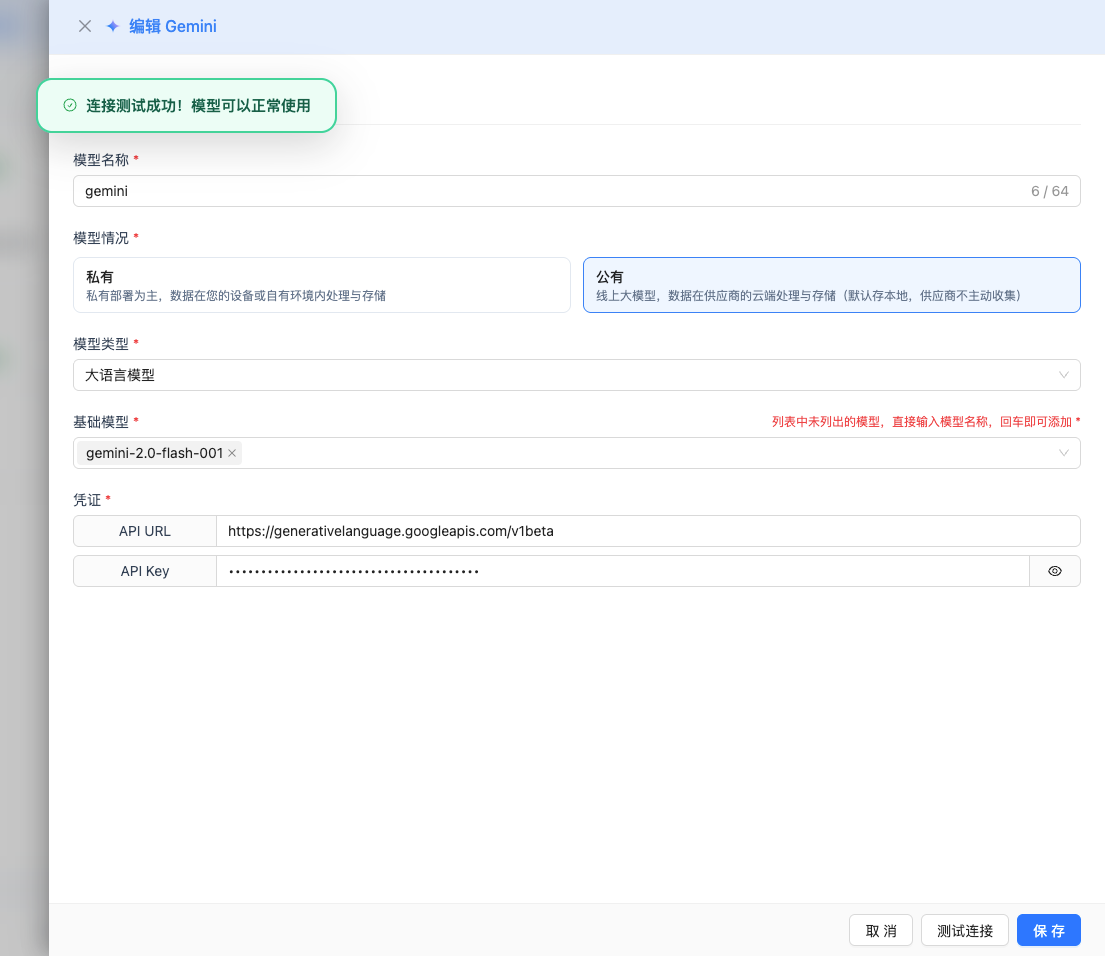

填写完配置后,点击 测试连接 按钮,验证配置是否正确。

如果配置正确,会显示测试成功的提示,并返回模型的响应示例。

如果配置错误,会显示测试错误的日志,并且可以通过日志管理,查看具体报错信息。

2.6 保存配置

测试成功后,点击 保存 按钮,完成模型配置。

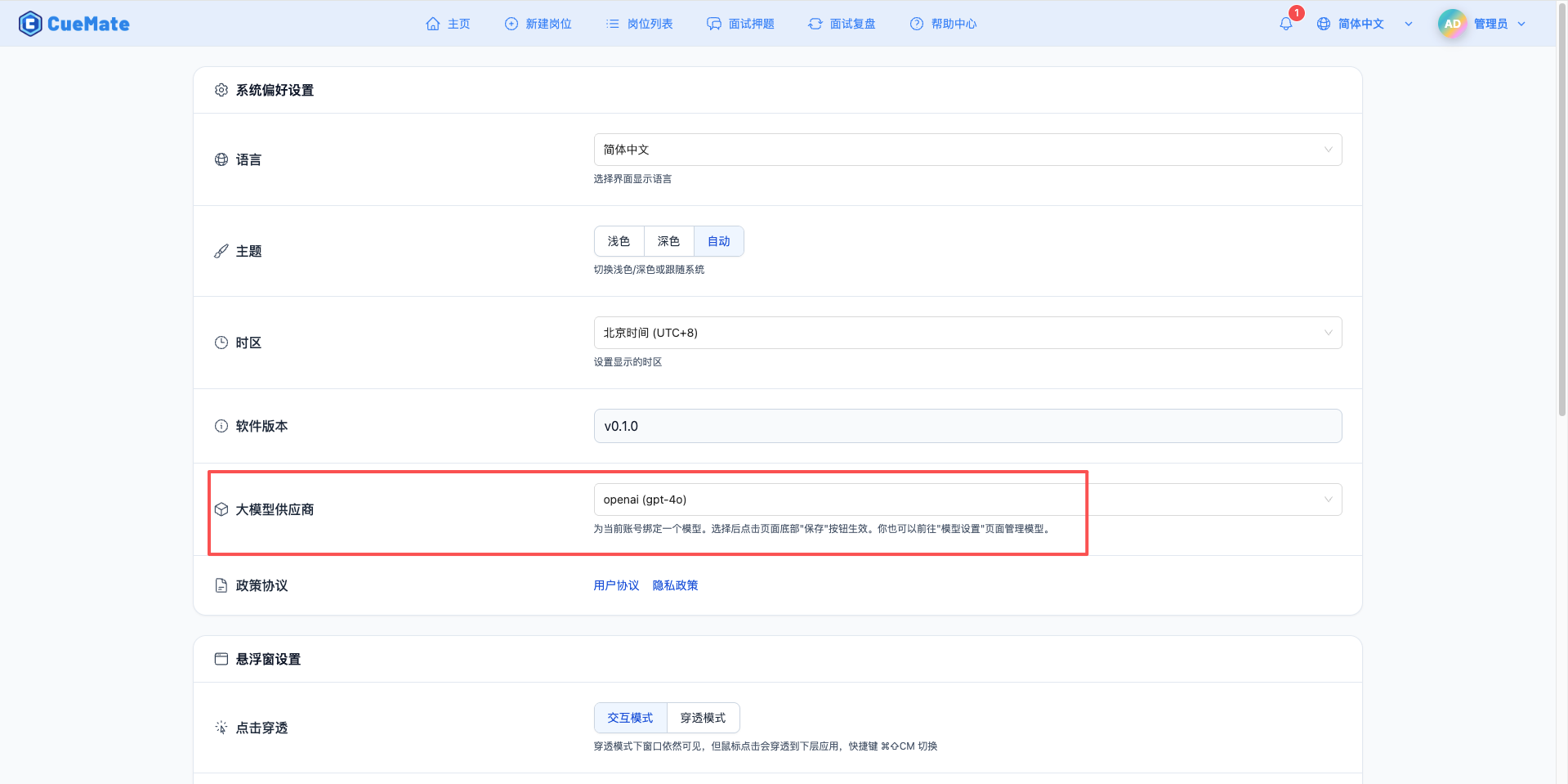

3. 使用模型

通过右上角下拉菜单,进入系统设置界面,在大模型服务商栏目选择想要使用的模型配置。

配置完成后,可以在面试训练、问题生成等功能中选择使用此模型, 当然也可以在面试的选项中单此选择此次面试的模型配置。

4. 支持的模型列表

4.1 Gemini 2.5 系列(2025 最新)

| 序号 | 模型名称 | 模型 ID | 最大输出 | 适用场景 |

|---|---|---|---|---|

| 1 | Gemini 2.5 Pro (实验) | gemini-2.5-pro-exp-03-25 | 65K tokens | 最强性能、长文本生成 |

4.2 Gemini 2.0 系列

| 序号 | 模型名称 | 模型 ID | 最大输出 | 适用场景 |

|---|---|---|---|---|

| 1 | Gemini 2.0 Flash | gemini-2.0-flash-001 | 8K tokens | 推荐使用、稳定版本 |

| 2 | Gemini 2.0 Flash (实验) | gemini-2.0-flash-exp | 8K tokens | 实验性功能测试 |

4.3 Gemini 1.5 系列

| 序号 | 模型名称 | 模型 ID | 最大输出 | 适用场景 |

|---|---|---|---|---|

| 1 | Gemini 1.5 Pro (最新) | gemini-1.5-pro-latest | 8K tokens | 自动使用最新版本 |

| 2 | Gemini 1.5 Pro 002 | gemini-1.5-pro-002 | 8K tokens | 复杂推理、技术面试 |

| 3 | Gemini 1.5 Flash (最新) | gemini-1.5-flash-latest | 8K tokens | 自动使用最新版本 |

| 4 | Gemini 1.5 Flash 002 | gemini-1.5-flash-002 | 8K tokens | 快速响应、常规对话 |

| 5 | Gemini 1.5 Flash 8B | gemini-1.5-flash-8b | 8K tokens | 轻量级任务、低成本 |

4.4 Gemini 1.0 系列(旧版)

| 序号 | 模型名称 | 模型 ID | 最大输出 | 适用场景 |

|---|---|---|---|---|

| 1 | Gemini 1.0 Pro | gemini-1.0-pro | 2K tokens | 基础对话 |

| 2 | Gemini 1.0 Pro Vision | gemini-1.0-pro-vision | 4K tokens | 图像理解、多模态 |

4.5 推荐选择

- 生产环境:

gemini-2.0-flash-001(稳定、高性价比) - 长文本生成:

gemini-2.5-pro-exp-03-25(最大 65K 输出) - 快速响应:

gemini-1.5-flash-002(低延迟) - 轻量级应用:

gemini-1.5-flash-8b(最低成本)

5. 常见问题

5.1 模型名称不存在(404 错误)

现象:测试连接时提示 models/gemini-1.5-pro is not found for API version v1beta

解决方案:

- 检查模型名称是否使用完整版本号

- 错误示例:

gemini-1.5-pro(不带版本号,会返回 404) - 正确示例:

gemini-2.0-flash-001(推荐)gemini-1.5-pro-002gemini-1.5-flash-002gemini-1.5-pro-latest(使用 latest 别名)

- 不要使用简短别名如

gemini-1.5-pro或gemini-1.5-flash,必须使用完整版本号

5.2 API Key 无效

现象:测试连接时提示 API Key 错误

解决方案:

- 检查 API Key 是否以

AIzaSy开头 - 确认 API Key 长度为 39 位字符

- 检查 Google Cloud 项目是否启用了 Generative Language API

- 确认 API Key 未被限制或禁用

5.3 请求超时

现象:测试连接或使用时长时间无响应

解决方案:

- 检查网络连接是否正常

- 如果在国内,可能需要使用代理

- 检查防火墙设置

5.4 配额不足

现象:提示配额已用完或请求频率过高

解决方案:

- 登录 Google Cloud Console 查看配额使用情况

- 申请提高配额限制

- 优化使用频率

5.5 API 未启用

现象:提示 API 未启用或项目无权限

解决方案:

- 访问 Google Cloud Console

- 启用 Generative Language API

- 确认项目配置正确

5.6 无法访问 AI Studio(权限拒绝)

现象:点击"获取 API 密钥"后直接报错 "permission denied" 并跳转到文档页面

解决方案:

- IP 地区限制:AI Studio 对某些地区有访问限制,需要使用美国等支持地区的代理

- 绕过 AI Studio 创建 API Key:

- 访问 Google Cloud Console - 凭据页面

- 点击"创建凭据" → "API 密钥"

- 复制生成的 API Key(以

AIzaSy开头) - 在"API 限制"中选择"Generative Language API"

- 说明:通过 Cloud Console 创建的 API Key 与 AI Studio 创建的完全相同,可以正常使用